Informationstheorie/AWGN–Kanalkapazität bei wertdiskretem Eingang: Unterschied zwischen den Versionen

Wael (Diskussion | Beiträge) |

|||

| (29 dazwischenliegende Versionen von 2 Benutzern werden nicht angezeigt) | |||

| Zeile 7: | Zeile 7: | ||

==AWGN–Modell für zeitdiskrete bandbegrenzte Signale== | ==AWGN–Modell für zeitdiskrete bandbegrenzte Signale== | ||

| − | + | <br> | |

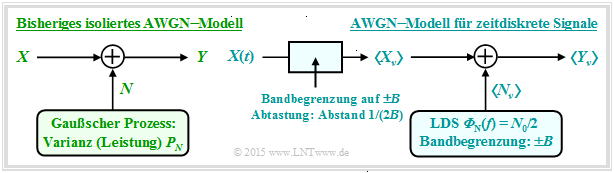

| − | Am Ende des [[Informationstheorie/AWGN–Kanalkapazität_bei_wertkontinuierlichem_Eingang#Kanalkapazit.C3.A4t_des_AWGN.E2.80.93Kanals|letzten Kapitels]] wurde das AWGN–Modell entsprechend der linken Grafik verwendet, gekennzeichnet durch die beiden Zufallsgrößen $X$ und $Y$ am Eingang und Ausgang sowie die stochastische Störung $N$ als das Ergebnis eines mittelwertfreien Gaußschen Zufallsprozesses ⇒ „Weißes Rauschen” mit der Varianz $σ_N^2$. Die Störleistung $P_N$ ist ebenfalls gleich $σ_N^2$. | + | Am Ende des [[Informationstheorie/AWGN–Kanalkapazität_bei_wertkontinuierlichem_Eingang#Kanalkapazit.C3.A4t_des_AWGN.E2.80.93Kanals|letzten Kapitels]] wurde das AWGN–Modell entsprechend der linken Grafik verwendet, gekennzeichnet durch die beiden Zufallsgrößen $X$ und $Y$ am Eingang und Ausgang sowie die stochastische Störung $N$ als das Ergebnis eines mittelwertfreien Gaußschen Zufallsprozesses ⇒ „Weißes Rauschen” mit der Varianz $σ_N^2$. Die Störleistung $P_N$ ist ebenfalls gleich $σ_N^2$. |

[[Datei:P_ID2931__Inf_T_4_3_S1a.png|center|frame|Zwei weitgehend äquivalente Modelle für den AWGN–Kanal]] | [[Datei:P_ID2931__Inf_T_4_3_S1a.png|center|frame|Zwei weitgehend äquivalente Modelle für den AWGN–Kanal]] | ||

| − | Die maximale Transinformation $I(X; Y)$ zwischen Eingang und Ausgang | + | Die maximale Transinformation $I(X; Y)$ zwischen Eingang und Ausgang ⇒ '''Kanalkapazität''' $C$ ergibt sich dann, wenn eine Gaußsche Eingangs–WDF $f_X(x)$ vorliegt. Mit der Sendeleistung $P_X = σ_X^2$ ⇒ Varianz der Zufallsgröße $X$ lautet die Kanalkapazitätsgleichung: |

:$$C = 1/2 \cdot {\rm log}_2 \hspace{0.1cm} ( 1 + {P_X}/{P_N}) | :$$C = 1/2 \cdot {\rm log}_2 \hspace{0.1cm} ( 1 + {P_X}/{P_N}) | ||

\hspace{0.05cm}.$$ | \hspace{0.05cm}.$$ | ||

| − | Nun beschreiben wir das AWGN–Kanalmodell gemäß dem rechts skizzierten Fall, dass am Kanaleingang die Folge $〈X_ν〉$ anliegt, wobei der Abstand zwischen aufeinander folgenden Werten $T_{\rm A}$ beträgt. Diese Folge ist das zeitdiskrete Äquivalent des zeitkontinuierlichen Signals $X(t)$ nach Bandbegrenzung und Abtastung | + | Nun beschreiben wir das AWGN–Kanalmodell gemäß dem rechts skizzierten Fall, dass am Kanaleingang die Folge $〈X_ν〉$ anliegt, wobei der Abstand zwischen aufeinander folgenden Werten $T_{\rm A}$ beträgt. Diese Folge ist das zeitdiskrete Äquivalent des zeitkontinuierlichen Signals $X(t)$ nach Bandbegrenzung und Abtastung. |

| − | |||

| − | + | Der Zusammenhang zwischen beiden Modellen kann anhand einer Grafik hergestellt werden, die anschließend genauer beschrieben wird. | |

| − | {{BlaueBox|TEXT= Die | + | {{BlaueBox|TEXT= Die $\text{wesentlichen Erkenntnisse}$ vorneweg: |

| − | *Beim rechten Modell gilt zu den Abtastzeitpunkten $ν·T_{\rm A}$ | + | *Beim rechten Modell gilt zu den Abtastzeitpunkten $ν·T_{\rm A}$ der gleiche Zusammenhang $Y_ν = X_ν + N_ν$ wie beim linken Modell. |

| − | *Die Störkomponente $N_ν$ ist nun durch (auf $±B$ | + | *Die Störkomponente $N_ν$ ist nun durch $($auf $±B)$ bandbegrenztes Weißes Rauschen mit der zweiseitigen Leistungsdichte ${\it Φ}_N(f) = N_0/2$ zu modellieren, <br>wobei $B = 1/(2T_{\rm A})$ gelten muss ⇒ siehe [[Signaldarstellung/Zeitdiskrete_Signaldarstellung#Das_Abtasttheorem|Abtasttheorem]].}} |

| − | + | $\text{ Interpretation:}$ | |

| − | Beim Modell | + | |

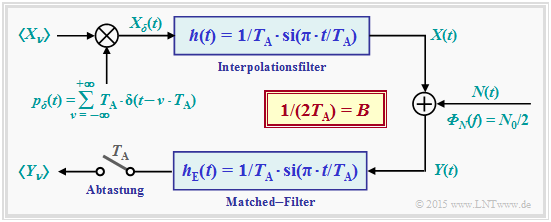

| + | Beim modifizierten Modell gehen wir von einer unendlichen Folge $〈X_ν〉$ von Gaußschen Zufallsgrößen aus, die einem [[Signaldarstellung/Zeitdiskrete_Signaldarstellung#Zeitbereichsdarstellung|Diracpuls]] $p_δ(t)$ eingeprägt werden. Das resultierende zeitdiskrete Signal lautet somit: | ||

| + | |||

| + | [[Datei:P_ID2932__Inf_T_4_3_S1b.png|right|frame| AWGN–Modell unter Berücksichtigung von Zeitdiskretisierung und Bandbegrenzung]] | ||

:$$X_{\delta}(t) = T_{\rm A} \cdot \hspace{-0.1cm} \sum_{\nu = - \infty }^{+\infty} X_{\nu} \cdot | :$$X_{\delta}(t) = T_{\rm A} \cdot \hspace{-0.1cm} \sum_{\nu = - \infty }^{+\infty} X_{\nu} \cdot | ||

| Zeile 34: | Zeile 36: | ||

)\hspace{0.05cm}.$$ | )\hspace{0.05cm}.$$ | ||

| − | Der Abstand aller (gewichteten) Diracfunktionen ist einheitlich $T_{\rm A}$. | + | Der Abstand aller (gewichteten) Diracfunktionen ist einheitlich $T_{\rm A}$. Durch das Interpolationsfilter mit Impulsantwort $h(t)$ sowie Frequenzgang $H(f)$, |

| − | |||

| − | Durch das Interpolationsfilter mit | ||

| − | :$$h(t) = 1/T_{\rm A} \cdot {\rm | + | :$$h(t) = 1/T_{\rm A} \cdot {\rm sinc}(t/T_{\rm A}) \quad \circ\!\!\!-\!\!\!-\!\!\!-\!\!\bullet \quad H(f) = |

| − | \left\{ \begin{array}{c} 1 \\ 0 \\ \end{array} \right. \begin{array}{*{20}c} {\rm{f\ddot{u}r}} \hspace{0.3cm} |f| \le B, \\ {\rm{f\ddot{u}r}} \hspace{0.3cm} |f| > B, \\ \end{array} | + | \left\{ \begin{array}{c} 1 \\ 0 \\ \end{array} \right. \begin{array}{*{20}c} {\rm{f\ddot{u}r}} \hspace{0.3cm} |f| \le B, \\ {\rm{f\ddot{u}r}} \hspace{0.3cm} |f| > B, \\ \end{array},$$ |

| − | |||

| − | + | wobei die (einseitige) Bandbreite $B = 1/(2T_{\rm A})$ ist, entsteht das zeitkontinuierliche Signal $X(t)$ mit folgenden Eigenschaften: | |

| − | *Die Abtastwerte $X(ν·T_{\rm A})$ sind für alle ganzzahligen $ν$ identisch mit den Eingangswerten $X_ν$, was mit den äquidistanten Nullstellen der | + | *Die Abtastwerte $X(ν·T_{\rm A})$ sind für alle ganzzahligen $ν$ identisch mit den Eingangswerten $X_ν$, was mit den äquidistanten Nullstellen der Funktion $\text{sinc}(x) = \sin(\pi x)/(\pi x)$ begründet werden kann. |

| − | *Gemäß dem Abtasttheorem ist $X(t)$ auf den Spektralbereich $±B$ ideal bandbegrenzt | + | *Gemäß dem Abtasttheorem ist $X(t)$ auf den Spektralbereich $±B$ ideal bandbegrenzt ⇒ wegen rechteckförmigem Frequenzgang $H(f)$. |

| − | {{BlaueBox|TEXT= Nach der Addition der | + | {{BlaueBox|TEXT= |

| + | $\text{Störleisungsbetrachtung:}$ Nach der Addition der Störkomponente $N(t)$ mit der (zweiseitigen) Leistungsdichte ${\it Φ}_N(t) = N_0/2$ folgt das Matched–Filter $\rm (MF)$ mit $\rm sinc$–förmiger Impulsantwort. Für die '''Störleistung am MF–Ausgang''' gilt dann: | ||

| − | :$$P_N = {\rm E}[N_\nu^2] = \frac{N_0}{2T_{\rm A} } = N_0 \cdot B\hspace{0.05cm}.$$ | + | :$$P_N = {\rm E}\big[N_\nu^2 \big] = \frac{N_0}{2T_{\rm A} } = N_0 \cdot B\hspace{0.05cm}.$$}} |

| − | + | ||

| + | {{BlaueBox|TEXT= | ||

| + | $\text{Beweis:}$ | ||

| + | Mit $B = 1/(2T_{\rm A} )$ erhält man für die Impulsantwort $h_{\rm E}(t)$ und die Spektralfunktion $H_{\rm E}(f)$: | ||

| − | :$$h_{\rm E}(t) = 2B \cdot {\rm | + | :$$h_{\rm E}(t) = 2B \cdot {\rm sinc}(2 B \cdot t) \quad \circ\!\!\!-\!\!\!-\!\!\!-\!\!\bullet \quad H_{\rm E}(f) = |

\left\{ \begin{array}{c} 1 \\ 0 \\ \end{array} \right. | \left\{ \begin{array}{c} 1 \\ 0 \\ \end{array} \right. | ||

\begin{array}{*{20}c} \text{für} \hspace{0.3cm} \vert f \vert \le B, \\ \text{für} \hspace{0.3cm} \vert f \vert > B. \\ \end{array} | \begin{array}{*{20}c} \text{für} \hspace{0.3cm} \vert f \vert \le B, \\ \text{für} \hspace{0.3cm} \vert f \vert > B. \\ \end{array} | ||

$$ | $$ | ||

| − | Daraus folgt entsprechend den Erkenntnissen der [[Stochastische_Signaltheorie/Stochastische_Systemtheorie#Problemstellung|Stochastischen Systemtheorie]]: | + | Daraus folgt entsprechend den Erkenntnissen der [[Stochastische_Signaltheorie/Stochastische_Systemtheorie#Problemstellung|Stochastischen Systemtheorie]]: |

:$$P_N = | :$$P_N = | ||

| Zeile 70: | Zeile 73: | ||

Weiter gilt: | Weiter gilt: | ||

| − | *Tastet man das | + | *Tastet man das Matched–Filter–Ausgangssignal in äquidistanten Abständen $T_{\rm A}$ ab, so ergibt sich für die Zeitpunkte $ν ·T_{\rm A}$ die gleiche Konstellation wie bisher, nämlich: $Y_ν = X_ν + N_ν$. |

| − | *Der Störanteil $N_ν$ im zeitdiskreten Ausgangssignal $Y_ν$ ist somit „bandbegrenzt” und „weiß” | + | |

| − | *Mit | + | *Der Störanteil $N_ν$ im zeitdiskreten Ausgangssignal $Y_ν$ ist somit „bandbegrenzt” und „weiß” ⇒ Die Kanalkapazitätsgleichung muss nur geringfügig angepasst werden. |

| + | |||

| + | *Mit $E_{\rm S} = P_X \cdot T_{\rm A}$ ⇒ Sende–Energie innerhalb einer „Symboldauer” $T_{\rm A}$ ⇒ '''Exergie pro Symbol''' gilt dann: | ||

:$$C = {1}/{2} \cdot {\rm log}_2 \hspace{0.1cm} ( 1 + \frac {P_X}{N_0 \cdot B}) | :$$C = {1}/{2} \cdot {\rm log}_2 \hspace{0.1cm} ( 1 + \frac {P_X}{N_0 \cdot B}) | ||

| Zeile 81: | Zeile 86: | ||

| − | ==Die Kanalkapazität $C$ als Funktion von $E_{\rm S}/N_0$ == | + | ==Die Kanalkapazität $C$ als Funktion von $E_{\rm S}/N_0$ == |

| − | + | <br> | |

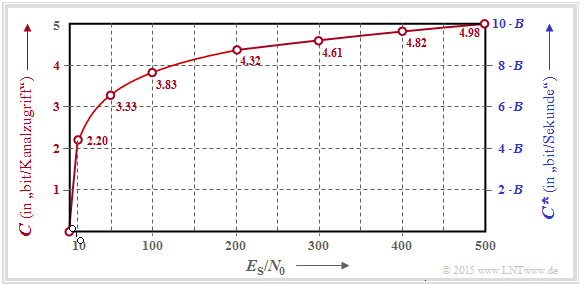

| − | Die | + | [[Datei:P_ID2934__Inf_T_4_3_S2a.png|right|frame|Kanalkapazitäten $C$ und $C^{\hspace{0.05cm}*}$ über $E_{\rm S}/N_0$]] |

| + | {{GraueBox|TEXT= | ||

| + | $\text{Beispiel 1:}$ Die Grafik zeigt den Verlauf der AWGN–Kanalkapazität in Abhängigkeit des Quotienten $E_{\rm S}/N_0$, wobei die linke Koordinatenachse und die roten Beschriftungen gültig sind: | ||

| − | :$$C = {1}/{2} \cdot {\rm log}_2 \hspace{0.1cm} ( 1 + \frac { 2 \cdot E_{\rm S}}{N_0}) | + | :$$C = {1}/{2} \cdot {\rm log}_2 \hspace{0.1cm} ( 1 + \frac { 2 \cdot E_{\rm S} }{N_0}) |

| − | \hspace{0.5cm}{\rm Einheit\hspace{-0.15cm}: \hspace{0.05cm}bit/Kanalzugriff | + | \hspace{0.5cm}{\rm Einheit\hspace{-0.15cm}: \hspace{0.05cm}bit/Kanalzugriff} |

\hspace{0.05cm}.$$ | \hspace{0.05cm}.$$ | ||

| − | Die Einheit wird manchmal auch mit „bit/Quellensymbol” oder kurz „bit/Symbol” bezeichnet. | + | Die (Pseudo–)Einheit wird manchmal auch mit „bit/Quellensymbol” oder kurz „bit/Symbol” bezeichnet. |

| + | |||

| + | Die rechte (blaue) Achsenbeschriftung berücksichtigt die Beziehung $B = 1/(2T_{\rm A})$ und liefert somit eine obere Schranke für die Bitrate $R$ eines Digitalsystems, die bei diesem AWGN–Kanal noch möglich ist. | ||

| + | |||

| + | :$$C^{\hspace{0.05cm}*} = \frac{C}{T_{\rm A} } = B \cdot {\rm log}_2 \hspace{0.1cm} ( 1 + \frac { 2 \cdot E_{\rm S} }{N_0}) | ||

| + | \hspace{0.5cm}{\rm Einheit\hspace{-0.15cm}: \hspace{0.05cm}bit/Sekunde} | ||

| + | \hspace{0.05cm}.$$}} | ||

| − | |||

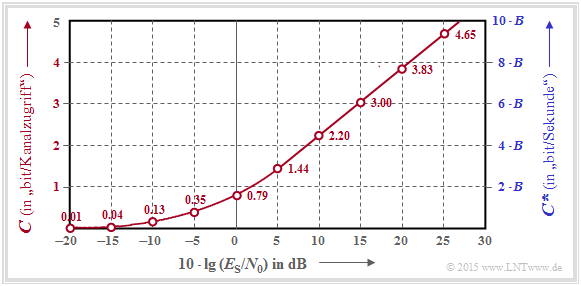

| − | + | [[Datei:P_ID2935__Inf_T_4_3_S2b.png|right|frame|AWGN–Kanalkapazitäten $C$ und $C^{\hspace{0.05cm}*}$ als Funktion von $10 \cdot \lg \ E_{\rm S}/N_0$]] | |

| + | {{GraueBox|TEXT= | ||

| + | $\text{Beispiel 2:}$ | ||

| + | Oft gibt man den Quotienten aus Symbolenergie $(E_{\rm S})$ und AWGN–Rauschleistungsdichte $(N_0)$ logarithmisch an. | ||

| − | + | *Diese Grafik zeigt die Kanalkapazitäten $C$ bzw. $C^{\hspace{0.05cm}*}$ als Funktion von $10 · \lg (E_{\rm S}/N_0)$ im Bereich von $-20 \ \rm dB$ bis $+30 \ \rm dB$. | |

| − | \ | ||

| − | |||

| − | + | ||

| + | *Oberhalb von $\approx 10 \ \rm dB$ ergibt sich hier ein (nahezu) linearer Verlauf. | ||

| − | + | }} | |

==Systemmodell zur Interpretation der AWGN–Kanalkapazität== | ==Systemmodell zur Interpretation der AWGN–Kanalkapazität== | ||

| + | <br> | ||

| + | Um das [[Informationstheorie/Anwendung_auf_die_Digitalsignalübertragung#Definition_und_Bedeutung_der_Kanalkapazit.C3.A4t|Kanalcodierungstheorem]] im Zusammenhang mit dem AWGN–Kanal besprechen zu können, benötigen wir noch eine „Codiervorrichtung”, die hier allerdings informationstheoretisch allein durch die Coderate $R$ gekennzeichnet wird. | ||

| − | + | [[Datei:P_ID2937__Inf_T_4_3_S3_neu.png|right|frame|Modell zur Interpretation der AWGN–Kanalkapazität]] | |

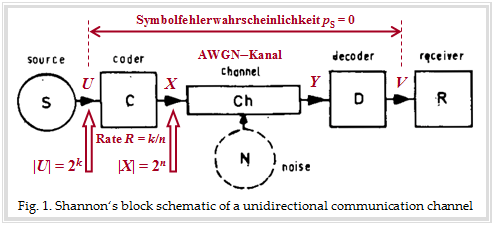

| − | + | Die Grafik beschreibt das von Shannon betrachtete Nachrichtensystem mit den Blöcken Quelle, Coder, (AWGN–)Kanal, Decoder und Empfänger. Im Hintergrund erkennt man ein Originalbild aus einem Aufsatz über die Shannon–Theorie. Rot eingezeichnet wurden von uns nur einige Bezeichnungen und Erläuterungen für den folgenden Text: | |

| + | *Das Quellensymbol $U$ entstammt einem Alphabet mit $M_U = |U| = 2^k$ Symbolen und kann durch $k$ gleichwahrscheinliche statistisch unabhängige Binärsymbole repräsentiert werden. | ||

| + | *Das Alphabet des Codesymbols $X$ hat den Symbolumfang $M_X = |X| = 2^n$, wobei sich $n$ aus der Coderate $R = k/n$ ergibt. | ||

| + | *Für die Coderate $R = 1$ gilt somit $n = k$ und der Fall $n > k$ führt zu einer Coderate $R < 1$. | ||

| + | <br clear=all> | ||

| + | {{BlaueBox|TEXT= $\rm Kanalcodierungstheorem:$ | ||

| − | + | Dieses besagt, dass es (mindestens) einen Code der Rate $R$ gibt, der zur Symbolfehlerwahrscheinlichkeit $p_{\rm S} = \text{Pr}(V ≠ U) \equiv 0$ führt, falls folgende Bedingungen erfüllt sind: | |

| − | * | + | *Die Coderate $R$ ist nicht größer als die Kanalkapazität $C$. |

| − | * | + | *Ein solcher geeigneter Code ist unendlich lang: $n → ∞$. Deshalb ist auch tatsächlich eine Gaußverteilung $f_X(x)$ am Kanaleingang möglich, die der bisherigen Berechnung der AWGN–Kanalkapazität stets zugrunde gelegt wurde: |

| − | * | + | :$$C = {1}/{2} \cdot {\rm log}_2 \hspace{0.1cm} ( 1 + \frac { 2 \cdot E_{\rm S} }{N_0}) |

| + | \hspace{1.3cm}{\rm Einheit\hspace{-0.15cm}: \hspace{0.05cm}bit/Kanalzugriff\hspace{0.15cm} (englisch\hspace{-0.15cm}: \hspace{0.05cm}bit/channel \hspace{0.15cm}use)} | ||

| + | \hspace{0.05cm}.$$ | ||

| + | *Die Kanaleingangsgröße $X$ ist also wertkontinuierlich. Gleiches gilt für $U$ und für die Größen $Y$, $V$ nach dem AWGN–Kanal. | ||

| − | + | *Für einen Systemvergleich ist die "Energie pro Symbol" $(E_{\rm S} )$ allerdings ungeeignet. | |

| − | + | *Ein Vergleich sollte vielmehr auf der "Energie pro Informationsbit" ⇒ kurz: "Energie pro Bit" $(E_{\rm B})$ basieren. Mit $E_{\rm B} = E_{\rm S}/R$ gilt somit auch: | |

| − | |||

| − | *Ein | ||

| − | |||

| − | :$$C = {1}/{2} \cdot {\rm log}_2 \hspace{0.1cm} ( 1 + \frac { 2 \cdot E_{\rm | + | :$$C = {1}/{2} \cdot {\rm log}_2 \hspace{0.1cm} ( 1 + \frac { 2 \cdot R \cdot E_{\rm B} }{N_0}) |

| − | \hspace{0. | + | \hspace{0.7cm}{\rm Einheit\hspace{-0.15cm}: \hspace{0.05cm}bit/Kanalzugriff\hspace{0.1cm} (englisch\hspace{-0.15cm}: \hspace{0.05cm}bit/channel \hspace{0.15cm}use)} |

\hspace{0.05cm}.$$ | \hspace{0.05cm}.$$ | ||

| − | + | Diese beiden Gleichungen werden auf der nächsten Seite diskutiert.}} | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | Diese beiden Gleichungen werden auf der nächsten Seite diskutiert. | ||

| − | |||

| − | |||

| − | Die | + | ==Die Kanalkapazität $C$ als Funktion von $E_{\rm B}/N_0$== |

| − | + | <br> | |

| − | :$$C = {1}/{2} \cdot {\rm log}_2 \hspace{0.1cm} ( 1 + \frac { 2 \cdot E_{\rm S}}{N_0}) | + | [[Datei:P_ID2938__Inf_T_4_3_S4.png|right|frame|Die AWGN–Kanalkapazität $C$ in zwei unterschiedlichen Darstellungen.<br> Die Preudo–Einheit "bit/Symbol" ist identisch mit "bit/Kanalzugriff".]] |

| − | \hspace{ | + | {{GraueBox|TEXT= |

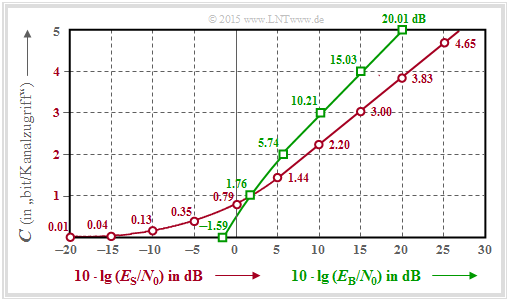

| + | $\text{Beispiel 3:}$ Die Grafik zu diesem Beispiel zeigt die AWGN–Kanalkapazität $C$ | ||

| + | *als Funktion von $10 · \lg (E_{\rm S}/N_0)$ ⇒ <u>roter Kurvenverlauf</u>: | ||

| + | ::$$C = {1}/{2} \cdot {\rm log}_2 \hspace{0.1cm} ( 1 + \frac { 2 \cdot E_{\rm S} }{N_0}); | ||

| + | \hspace{1.0cm}{\rm Einheit\hspace{-0.15cm}: \hspace{0.05cm}bit/Symbol} | ||

\hspace{0.05cm}.$$ | \hspace{0.05cm}.$$ | ||

| + | :Rote Zahlenwerte: Kapazität $C$ in „bit/Symbol” für Abszissen <br> $10 · \lg (E_{\rm S}/N_0) = -20 \ \rm dB, -15 \ \rm dB$, ... , $+30\ \rm dB$; | ||

| + | *als Funktion von $10 · \lg (E_{\rm B}/N_0)$ ⇒ <u>grüner Kurvenverlauf</u>: | ||

| + | ::$$C = {1}/{2} \cdot {\rm log}_2 \hspace{0.1cm} ( 1 + \frac { 2 \cdot R \cdot E_{\rm B} }{N_0}) | ||

| + | ; \hspace{0.8cm}{\rm Einheit\hspace{-0.15cm}: \hspace{0.05cm}bit/Symbol} | ||

| + | \hspace{0.05cm}; $$ | ||

| + | :Grüne Zahlenwerte: Erforderliches $10 · \lg (E_{\rm B}/N_0)$ in „dB” für Ordinate $C = 0,\ 1$, ... , $5$ in „bit/Symbol”. | ||

| + | :Die ausführliche $C(E_{\rm B}/N_0)$–Berechnung finden Sie in der [[Aufgaben:4.8_Numerische_Auswertung_der_AWGN-Kanalkapazität|Aufgabe 4.8]] und der zugehörigen Musterlösung. | ||

| + | <br clear=all> | ||

| + | Im Folgenden interpretieren wir das (grüne) $C(E_{\rm B}/N_0)$–Ergebnis im Vergleich zur (roten) $C(E_{\rm S}/N_0)$–Kurve: | ||

| + | *Wegen $E_{\rm S} = R · E_{\rm B}$ liegt der Schnittpunkt beider Kurven bei $C (= R) = 1$ bit/Symbol. Erforderlich sind $10 · \lg (E_{\rm S}/N_0) = 1.76$ dB bzw. $10 · \lg (E_{\rm B}/N_0) = 1.76$ dB gleichermaßen. | ||

| + | *Im Bereich $C > 1$ liegt die grüne Kurve stets über der roten. Beispielsweise ergibt sich für $10 · \lg (E_{\rm B}/N_0) = 20$ dB die Kanalkapazität $C ≈ 5$, für $10 · \lg (E_{\rm S}/N_0) = 20$ dB nur $C = 3.83$. | ||

| + | *Ein Vergleich in horizontaler Richtung zeigt, dass die Kanalkapazität $C = 3$ bit/Symbol schon mit $10 · \lg (E_{\rm B}/N_0) \approx 10$ dB erreichbar ist, man aber $10 · \lg (E_{\rm S}/N_0) \approx 15$ dB benötigt. | ||

| + | *Im Bereich $C < 1$ liegt die rote Kurve stets über der grünen. Für jedes $E_{\rm S}/N_0 > 0$ gilt $C > 0$. Bei logarithmischer Abszisse wie in der vorliegenden Darstellung reicht somit die rote Kurve bis ins „Minus–Unendliche”. | ||

| + | *Dagegen endet die grüne Kurve bei $E_{\rm B}/N_0 = \ln (2) = 0.693$ ⇒ $10 · \lg (E_{\rm B}/N_0)= -1.59$ dB ⇒ absolute Grenze für die (fehlerfreie) Übertragung über den AWGN–Kanal.}} | ||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | [[Datei: | + | ==AWGN–Kanalkapazität für binäre Eingangssignale == |

| + | <br> | ||

| + | [[Datei:P_ID2941__Inf_T_4_3_S5a_neu.png|right|frame|Zur Berechnung der AWGN–Kanalkapazität für BPSK]] | ||

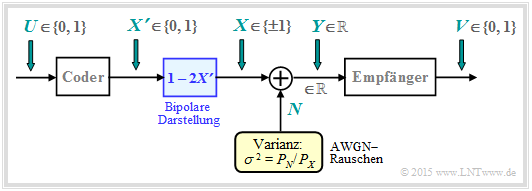

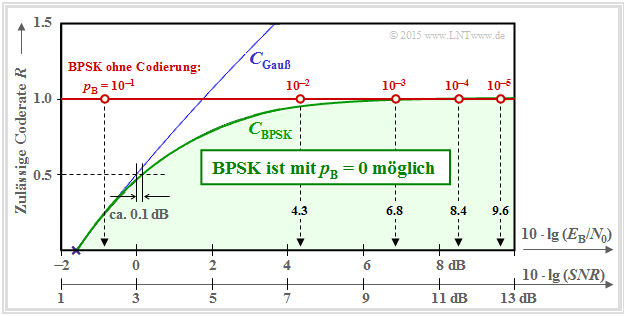

| − | + | Auf den bisherigen Seiten dieses Kapitels wurde stets gemäß der Shannon–Theorie von einem gaußverteilten, also wertkontinuierlichen AWGN–Eingang $X$ ausgegangen. | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| + | Nun betrachten wir den binären Fall und werden somit erst jetzt der Kapitel–Überschrift „AWGN–Kanalkapazität bei wertdiskretem Eingang” gerecht. | ||

| − | + | Die Grafik zeigt das zugrundeliegende Blockschaltbild für [[Digitalsignalübertragung/Lineare_digitale_Modulation_–_Kohärente_Demodulation#Gemeinsames_Blockschaltbild_f.C3.BCr_ASK_und_BPSK|Binary Phase Shift Keying]] $\rm (BPSK)$ mit binärem Eingang $U$ und binärem Ausgang $V$. | |

| − | + | Durch die bestmögliche Codierung soll erreicht werden, dass die Bitfehlerwahrscheinlichkeit $\text{Pr}(V ≠ U)$ verschwindend klein wird. | |

| + | <br clear=all> | ||

| + | *Der Coderausgang ist gekennzeichnet durch die binäre Zufallsgröße $X \hspace{0.03cm}' = \{0, 1\}$ ⇒ $M_{X'} = 2$, während der Ausgang $Y$ des AWGN–Kanals weiterhin wertkontinuierlich ist: $M_Y → ∞$. | ||

| + | *Durch das Mapping $X = 1 - 2X\hspace{0.03cm} '$ kommt man von der unipolaren Darstellung zu der für BPSK besser geeigneten bipolaren (antipodalen) Beschreibung: $X\hspace{0.03cm} ' = 0 → \ X = +1; \hspace{0.5cm} X\hspace{0.03cm} ' = 1 → X = -1$. | ||

| − | [[Datei: | + | [[Datei:P_ID2942__Inf_T_4_3_S5b_neu.png|right|frame|Bedingte WDF für $X=-1$ (rot) und $X=+1$ (blau) ]] |

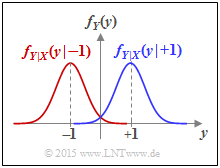

| − | + | *Der AWGN–Kanal wird durch zwei bedingte Wahrscheinlichkeitsdichtefunktionen charakterisiert: | |

| − | + | :$$f_{Y\hspace{0.05cm}|\hspace{0.03cm}{X}}(y\hspace{0.05cm}|\hspace{0.03cm}{X}=+1) =\frac{1}{\sqrt{2\pi\sigma^2}} \cdot {\rm e}^{-{(y - 1)^2}/(2 \sigma^2)} \hspace{0.05cm}\hspace{0.05cm},\hspace{0.5cm}\text{Kurzform:} \ \ f_{Y\hspace{0.05cm}|\hspace{0.03cm}{X}}(y\hspace{0.05cm}|\hspace{0.03cm}+1)\hspace{0.05cm},$$ | |

| − | * | + | :$$f_{Y\hspace{0.05cm}|\hspace{0.03cm}{X}}(y\hspace{0.05cm}|\hspace{0.03cm}{X}=-1) =\frac{1}{\sqrt{2\pi\sigma^2}} \cdot {\rm e}^{-{(y + 1)^2}/(2 \sigma^2)} \hspace{0.05cm}\hspace{0.05cm},\hspace{0.5cm}\text{Kurzform:} \ \ f_{Y\hspace{0.05cm}|\hspace{0.03cm}{X}}(y\hspace{0.05cm}|\hspace{0.03cm}-1)\hspace{0.05cm}.$$ |

| + | *Da hier das Nutzsignal $X$ auf $±1$ normiert ist ⇒ Leistung $1$ anstelle von $P_X$, muss die Varianz des AWGN–Rauschens $N$ in gleicher Weise normiert werden: $σ^2 = P_N/P_X$. | ||

| + | *Der Empfänger trifft aus der reellwertigen Zufallsgröße $Y$ (am AWGN–Kanalausgang) eine [[Kanalcodierung/Klassifizierung_von_Signalen#ML.E2.80.93Entscheidung_beim_AWGN.E2.80.93Kanal|Maximum–Likelihood–Entscheidung]]. Der Empfängerausgang $V$ ist binär $(0$ oder $1)$. | ||

| − | |||

| − | + | Ausgehend von diesem Modell berechnen wir nun die Kanalkapazität des AWGN–Kanals. | |

| − | |||

| − | |||

| − | + | Diese lautet bei einer binären Eingangsgröße $X$ allgemein unter Berücksichtigung von $\text{Pr}(X = -1) = 1 - \text{Pr}(X = +1)$: | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

:$$C_{\rm BPSK} = \max_{ {\rm Pr}({X} =+1)} \hspace{-0.15cm} I(X;Y) | :$$C_{\rm BPSK} = \max_{ {\rm Pr}({X} =+1)} \hspace{-0.15cm} I(X;Y) | ||

| Zeile 188: | Zeile 208: | ||

:$${\rm Pr}(X =+1) = {\rm Pr}(X =-1) = 0.5 $$ | :$${\rm Pr}(X =+1) = {\rm Pr}(X =-1) = 0.5 $$ | ||

| − | zum Optimum führen werden. Gemäß der Seite [[Informationstheorie/AWGN–Kanalkapazität_bei_wertkontinuierlichem_Eingang#Transinformationsberechnung_bei_additiver_St.C3.B6rung|Transinformationsberechnung bei additiver Störung]] gibt es mehrere Berechnungsmöglichkeiten: | + | zum Optimum führen werden. Gemäß der Seite [[Informationstheorie/AWGN–Kanalkapazität_bei_wertkontinuierlichem_Eingang#Transinformationsberechnung_bei_additiver_St.C3.B6rung|Transinformationsberechnung bei additiver Störung]] gibt es mehrere Berechnungsmöglichkeiten: |

| − | + | ||

:$$ \begin{align*}C_{\rm BPSK} & = h(X) + h(Y) - h(XY)\hspace{0.05cm},\\ | :$$ \begin{align*}C_{\rm BPSK} & = h(X) + h(Y) - h(XY)\hspace{0.05cm},\\ | ||

C_{\rm BPSK} & = h(Y) - h(Y|X)\hspace{0.05cm},\\ | C_{\rm BPSK} & = h(Y) - h(Y|X)\hspace{0.05cm},\\ | ||

C_{\rm BPSK} & = h(X) - h(X|Y)\hspace{0.05cm}. \end{align*}$$ | C_{\rm BPSK} & = h(X) - h(X|Y)\hspace{0.05cm}. \end{align*}$$ | ||

| − | Alle Ergebnisse sind noch um die Pseudo–Einheit | + | Alle Ergebnisse sind noch um die Pseudo–Einheit „bit/Kanalzugriff” zu ergänzen. |

| + | [[Datei:P_ID2946__Inf_T_4_3_S5c_neu.png|right|frame|Die Kanalkapazitätsgrenzen $C_{\rm BPSK}$ und $C_{\rm Gauß}$ im Vergleich]] | ||

| + | Wir wählen hier die mittlere Gleichung: | ||

| + | |||

*Die hierfür benötigte bedingte differentielle Entropie ist gleich | *Die hierfür benötigte bedingte differentielle Entropie ist gleich | ||

| − | :$$h(Y|X) = h(N) = 1/2 \cdot {\rm log}_2 \hspace{0.1cm}(2\pi{\rm e}\cdot \sigma^2) | + | :$$h(Y\hspace{0.03cm}|\hspace{0.03cm}X) = h(N) = 1/2 \cdot {\rm log}_2 \hspace{0.1cm}(2\pi{\rm e}\cdot \sigma^2) |

\hspace{0.05cm}. $$ | \hspace{0.05cm}. $$ | ||

| − | *Die differentielle Entropie $h(Y)$ ist vollständig durch die WDF $f_Y(y)$ gegeben. Mit den vorne definierten und skizzierten bedingten Wahrscheinlichkeitsdichtefunktionen erhält man: | + | *Die differentielle Entropie $h(Y)$ ist vollständig durch die WDF $f_Y(y)$ gegeben. Mit den vorne definierten und skizzierten bedingten Wahrscheinlichkeitsdichtefunktionen erhält man: |

| − | :$$f_Y(y) = {1}/{2} \cdot \ | + | :$$f_Y(y) = {1}/{2} \cdot \big [ f_{Y\hspace{0.03cm}|\hspace{0.03cm}{X}}(y\hspace{0.05cm}|\hspace{0.05cm}{X}=-1) + f_{Y\hspace{0.03cm}|\hspace{0.03cm}{X}}(y\hspace{0.05cm}|\hspace{0.05cm}{X}=+1) \big ]$$ |

| − | \Rightarrow \hspace{0.3cm} h(Y) \hspace{-0.01cm}=\hspace{0.05cm} | + | :$$\Rightarrow \hspace{0.3cm} h(Y) \hspace{-0.01cm}=\hspace{0.05cm} |

-\hspace{-0.7cm} \int\limits_{y \hspace{0.05cm}\in \hspace{0.05cm}{\rm supp}(f_Y)} \hspace{-0.65cm} f_Y(y) \cdot {\rm log}_2 \hspace{0.1cm} [f_Y(y)] \hspace{0.1cm}{\rm d}y | -\hspace{-0.7cm} \int\limits_{y \hspace{0.05cm}\in \hspace{0.05cm}{\rm supp}(f_Y)} \hspace{-0.65cm} f_Y(y) \cdot {\rm log}_2 \hspace{0.1cm} [f_Y(y)] \hspace{0.1cm}{\rm d}y | ||

\hspace{0.05cm}.$$ | \hspace{0.05cm}.$$ | ||

| − | Es ist offensichtlich, dass $h(Y)$ nur durch numerische Integration ermittelt werden kann, insbesondere, wenn man berücksichtigt, dass sich | + | Es ist offensichtlich, dass $h(Y)$ nur durch numerische Integration ermittelt werden kann, insbesondere, wenn man berücksichtigt, dass sich $f_Y(y)$ im Überlappungsbereich aus der Summe der beiden bedingten Gauß–Funktionen ergibt. |

| − | In der | + | In der obigen Grafik sind über der Abszisse $10 · \lg (E_{\rm B}/N_0)$ drei Kurven dargestellt: |

| − | *die blau gezeichnete Kanalkapazität $C_{\rm Gauß}$, gültig für eine Gaußsche Eingangsgröße $X$ ⇒ $M_X → ∞$, | + | *die blau gezeichnete Kanalkapazität $C_{\rm Gauß}$, gültig für eine Gaußsche Eingangsgröße $X$ ⇒ $M_X → ∞$, |

| − | *die grün gezeichnete Kanalkapazität $C_{\rm BPSK}$ für die Zufallsgröße $X = (+1, –1)$, sowie | + | *die grün gezeichnete Kanalkapazität $C_{\rm BPSK}$ für die Zufallsgröße $X = (+1, –1)$, sowie |

*die mit „BPSK ohne Codierung” bezeichnete rote Horizontale. | *die mit „BPSK ohne Codierung” bezeichnete rote Horizontale. | ||

| − | |||

Diese Kurvenverläufe sind wie folgt zu interpretieren: | Diese Kurvenverläufe sind wie folgt zu interpretieren: | ||

| − | *Die grüne Kurve $C_{\rm BPSK}$ gibt die maximal zulässige Coderate $R$ | + | *Die grüne Kurve $C_{\rm BPSK}$ gibt die maximal zulässige Coderate $R$ von "Binary Phase Shift Keying" (BPSK) an, bei der für das gegebene $E_{\rm B}/N_0$ durch bestmögliche Codierung die Bitfehlerwahrscheinlichkeit $p_{\rm B} \equiv 0$ möglich ist. |

| − | *Für alle BPSK–Systeme mit den Koordinaten ( | + | *Für alle BPSK–Systeme mit den Koordinaten $(10 · \lg \ E_{\rm B}/N_0, \ R)$ im „grünen Bereich” ist $p_{\rm B} \equiv 0$ prinzipiell erreichbar. Aufgabe der Nachrichtentechniker ist es, hierfür geeignete Codes zu finden. |

| − | *Die BPSK–Kurve liegt stets unter der absoluten Shannon–Grenzkurve $C_{\rm Gauß}$ für $M_X → ∞$. Im unteren Bereich gilt $C_{\rm BPSK} ≈ C_{\rm Gauß}$. Zum Beispiel muss ein BPSK–System mit $R = 1/2$ nur ein um $0.1$ | + | *Die BPSK–Kurve liegt stets unter der absoluten Shannon–Grenzkurve $C_{\rm Gauß}$ für $M_X → ∞$ (blaue Kurve). Im unteren Bereich gilt $C_{\rm BPSK} ≈ C_{\rm Gauß}$. Zum Beispiel muss ein BPSK–System mit $R = 1/2$ nur ein um $0.1\ \rm dB$ größeres $E_{\rm B}/N_0$ bereitstellen, als es die (absolute) Kanalkapazität $C_{\rm Gauß}$ fordert. |

| − | *Ist $E_{\rm B}/N_0$ endlich, so gilt stets $C_{\rm BPSK} < 1$ ⇒ siehe[[Aufgaben:4.9Z_Ist_bei_BPSK_die_Kanalkapazität_C_≡_1_möglich%3F| | + | *Ist $E_{\rm B}/N_0$ endlich, so gilt stets $C_{\rm BPSK} < 1$ ⇒ siehe [[Aufgaben:4.9Z_Ist_bei_BPSK_die_Kanalkapazität_C_≡_1_möglich%3F|Aufgabe 4.9Z]]. Eine BPSK mit $R = 1$ (und somit ohne Codierung) wird also stets eine Bitfehlerwahrscheinlichkeit $p_{\rm B} > 0$ zur Folge haben. |

| − | *Die Fehlerwahrscheinlichkeiten eines solchen BPSK–Systems ohne Codierung (mit $R = 1$ | + | *Die Fehlerwahrscheinlichkeiten eines solchen BPSK–Systems ohne Codierung $($mit $R = 1)$ sind auf der roten Horizontalen angegeben. Um $p_{\rm B} ≤ 10^{–5}$ zu erreichen, benötigt man demnach mindestens $10 · \lg (E_{\rm B}/N_0) = 9.6\ \rm dB$. |

| − | + | *Diese Wahrscheinlichkeiten ergeben sich gemäß dem Kapitel [[Digitalsignalübertragung/Lineare_digitale_Modulation_–_Kohärente_Demodulation#Fehlerwahrscheinlichkeit_des_optimalen_BPSK.E2.80.93Systems|Fehlerwahrscheinlichkeit des optimalen BPSK-Systems]] im Buch „Digitalsignalübertragung” zu | |

| − | |||

| − | |||

:$$p_{\rm B} = {\rm Q} \left ( \sqrt{S \hspace{-0.06cm}N\hspace{-0.06cm}R}\right ) \hspace{0.45cm} {\rm mit } \hspace{0.45cm} | :$$p_{\rm B} = {\rm Q} \left ( \sqrt{S \hspace{-0.06cm}N\hspace{-0.06cm}R}\right ) \hspace{0.45cm} {\rm mit } \hspace{0.45cm} | ||

| Zeile 228: | Zeile 248: | ||

\hspace{0.05cm}. $$ | \hspace{0.05cm}. $$ | ||

| − | + | <u>Hinweise</u>: | |

| + | *In obiger Grafik ist als zweite, zusätzliche Abszissenachse $10 · \lg (SNR)$ eingezeichnet. "SNR" steht hierbei für "Signal-to-Noise Ratio". | ||

| + | *Die Funktion ${\rm Q}(x)$ bezeichnet man als das [[Stochastische_Signaltheorie/Gaußverteilte_Zufallsgrößen#.C3.9Cberschreitungswahrscheinlichkeit|komplementäre Gaußsche Fehlerintegral]]. | ||

==Vergleich zwischen Theorie und Praxis== | ==Vergleich zwischen Theorie und Praxis== | ||

| + | <br> | ||

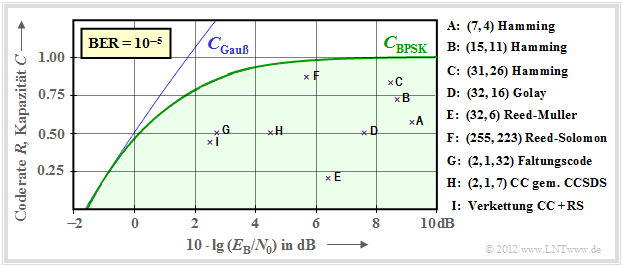

| + | Anhand zweier Grafiken soll gezeigt werden, in wie weit sich etablierte Kanalcodes der BPSK–Kanalkapazität (grüne Kurve) annähern. Als Ordinate aufgetragen ist die Rate $R = k/n$ dieser Codes bzw. die Kapazität $C$ (wenn noch die Pseudo–Einheit „bit/Kanalzugriff” hinzugefügt wird). | ||

| − | |||

Vorausgesetzt ist: | Vorausgesetzt ist: | ||

| − | *der AWGN–Kanal, gekennzeichnet durch $10 · \lg (E_{\rm B}/N_0)$ in dB, und | + | *der AWGN–Kanal, gekennzeichnet durch $10 · \lg (E_{\rm B}/N_0)$ in dB, und |

| − | *für die durch Kreuze markierten realisierten Codes eine [[Digitalsignalübertragung/Fehlerwahrscheinlichkeit_bei_Basisbandübertragung#Definition_der_Bitfehlerquote|Bitfehlerrate]] (BER) von $10^{–5}$. | + | *für die durch Kreuze markierten realisierten Codes eine [[Digitalsignalübertragung/Fehlerwahrscheinlichkeit_bei_Basisbandübertragung#Definition_der_Bitfehlerquote|Bitfehlerrate]] $\rm (BER)$ von $10^{–5}$. |

| − | |||

| − | + | Zu beachten ist, dass die Kanalkapazitätskurven stets für $n → ∞$ und $\rm BER \equiv 0$ gelten. | |

| + | *Würde man die strenge Forderung „fehlerfrei” auch an die Kanalcodes endlicher Codelänge $n$ anlegen, so wäre hierfür stets $10 · \lg \ (E_{\rm B}/N_0) \to \infty$ erforderlich. | ||

| + | *Dies ist aber ein eher akademisches Problem, also wenig praxisrelevant. Für $\text{BER} = 10^{–10}$ ergäbe sich eine qualitativ ähnliche Grafik. | ||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | {{GraueBox|TEXT= | |

| + | $\text{Beispiel 4:}$ | ||

| + | In der Grafik sind die Kenndaten von frühen Systemen mit Kanalcodierung und klassischer Decodierung angegeben. | ||

| + | Es folgen einige Erläuterungen zu den Daten, die der Vorlesung [Liv10]<ref name = 'Liv10'>Liva, G.: Channel Coding. | ||

| + | Vorlesungsmanuskript, Lehrstuhl für Nachrichtentechnik, TU München und DLR Oberpfaffenhofen, 2010.</ref> entnommen wurden. Die Links bei diesen Erläuterungen beziehen sich oft auf das $\rm LNTwww$–Buch [[Kanalcodierung]]. | ||

| + | [[Datei:P_ID2949__Inf_T_4_3_S6a.png|right|frame|Raten und erforderliches $E_{\rm B}/{N_0}$ verschiedener Kanalcodes]] | ||

| − | + | *Die Punkte $\rm A$, $\rm B$ und $\rm C$ markieren [[Kanalcodierung/Beispiele_binärer_Blockcodes#Hamming.E2.80.93Codes|Hamming–Codes]] der Raten $R = 4/7 ≈ 0.57$, $R ≈ 0.73$ bzw. $R ≈ 0.84$. Für $\text{BER} = 10^{–5}$ benötigen diese sehr frühen Codes (aus dem Jahr 1950) alle $10 · \lg (E_{\rm B}/N_0) > 8\ \rm dB$. | |

| + | *Die Markierung $\rm D$ kennzeichnet den binären [https://de.wikipedia.org/wiki/Golay-Code Golay–Code] mit der Rate $R = 1/2$ und der Punkt $\rm E$ einen [https://de.wikipedia.org/wiki/Reed-Muller-Code Reed–Muller–Code]. Dieser sehr niederratige Code kam bereits 1971 bei der [https://de.wikipedia.org/wiki/Mariner Raumsonde Mariner 9] zum Einsatz. | ||

| + | *Die [[Kanalcodierung/Definition_und_Eigenschaften_von_Reed–Solomon–Codes#Konstruktion_von_Reed.E2.80.93Solomon.E2.80.93Codes_.281.29|Reed–Solomon–Codes]] (RS–Codes, ca. 1960) sind eine Klasse zyklischer Blockcodes. $\rm F$ markiert einen RS–Code der Rate $223/255 \approx 0.875$ und einem erforderlichen $E_{\rm B}/N_0 < 6 \ \rm dB$. | ||

| + | *$\rm G$ und $\rm H$ bezeichnen zwei [[Kanalcodierung/Grundlagen_der_Faltungscodierung|Faltungscodes]] $($englisch: "Convolutional Codes", $\rm CC)$ mittlerer Rate. Der Code $\rm G$ wurde schon 1972 bei der [https://de.wikipedia.org/wiki/Pioneer_10 Pioneer 10–Mission] eingesetzt. | ||

| + | *Die Kanalcodierung der [https://voyager.jpl.nasa.gov/mission/ Voyager–Mission] Ende der 1970er Jahre ist mit $\rm I$ markiert. Es handelt sich um die [[Kanalcodierung/Soft–in_Soft–out_Decoder#Grundstruktur_von_verketteten_Codiersystemen|Verkettung]] eines $\text{(2, 1, 7)}$–Faltungscodes mit einem Reed–Solomon–Code. | ||

| − | |||

| + | Anzumerken ist, dass bei den Faltungscodes der dritte Kennungsparameter eine andere Bedeutung hat als bei den Blockcodes. So weist beispielsweise die Kennung $\text{(2, 1, 32)}$ auf das Memory $m = 32$ hin.}} | ||

| − | |||

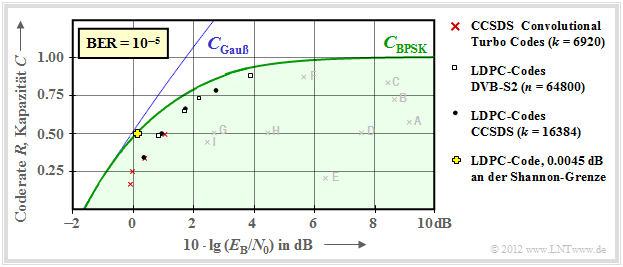

| − | [[Datei:P_ID2950__Inf_T_4_3_S6b.png| | + | [[Datei:P_ID2950__Inf_T_4_3_S6b.png|right|frame|Raten und erforderliches $E_{\rm B}/{N_0}$ für iterative Codierverfahren ]] |

| + | {{GraueBox|TEXT= | ||

| + | $\text{Beispiel 5:}$ | ||

| + | Die im $\text{Beispiel 4}$ genannten frühen Kanalcodes liegen noch relativ weit von der Kanalkapazitätskurve entfernt. | ||

| + | Dies war wahrscheinlich auch ein Grund, warum dem Autor dieses Lerntutorials die auch große praktische Bedeutung der Informationstheorie verschlossen blieb, als er diese Anfang der 1970er Jahre im Studium kennengelernt hat. | ||

| + | |||

| + | Die Sichtweise hat sich deutlich verändert, als in den 1990er Jahren sehr lange Kanalcodes zusammen mit iterativer Decodierung aufkamen. Die neuen Markierungspunkte liegen deutlich näher an der Kapazitätsgrenzkurve. | ||

| + | <br clear=all> | ||

Hier noch einige Erläuterungen zu dieser Grafik: | Hier noch einige Erläuterungen zu dieser Grafik: | ||

| − | *Rote Kreuze markieren | + | *Rote Kreuze markieren die so genannten [https://de.wikipedia.org/wiki/Turbo-Code Turbo–Codes] nach $\rm CCSDS$ ("Consultative Committee for Space Data Systems") mit jeweils $k = 6920$ Informationsbit und unterschiedlichen Codelängen $n = k/R$. Diese von [https://de.wikipedia.org/wiki/Claude_Berrou Claude Berrou] um 1990 erfundenen Codes können iterativ decodiert werden. Die (roten) Markierungen liegen jeweils weniger als $1 \ \rm dB$ von der Shannon–Grenze entfernt. |

| − | *Ähnlich verhalten sich die [https://en.wikipedia.org/wiki/Low-density_parity-check_code LDPC–Codes] ( | + | *Ähnlich verhalten sich die [https://en.wikipedia.org/wiki/Low-density_parity-check_code LDPC–Codes] ("Low Density Parity–check Codes") mit konstanter Codelänge $n = 64800$ ⇒ weiße Rechtecke. Sie werden seit 2006 bei [https://de.wikipedia.org/wiki/DVB-S DVB–S2] ("Digital Video Broadcast over Satellite") eingesetzt und eignen sich aufgrund der spärlichen Einsen–Belegung der Prüfmatrix sehr gut für die iterative Decodierung mittels [https://en.wikipedia.org/wiki/Factor_graph Faktor–Graphen] und [https://en.wikipedia.org/wiki/EXIT_chart Exit Charts]. |

| − | *Schwarze Punkte markieren die von CCSDS spezifizierten [https://de.wikipedia.org/wiki/Low-Density-Parity-Check-Code LDPC–Codes] mit konstanter Anzahl an Informationsbits ( | + | *Schwarze Punkte markieren die von $\rm CCSDS$ spezifizierten [https://de.wikipedia.org/wiki/Low-Density-Parity-Check-Code LDPC–Codes] mit konstanter Anzahl an Informationsbits $(k = 16384)$ und variabler Wortlänge $n = k/R$. Diese Codeklasse erfordert ein ähnliches $E_{\rm B}/N_0$ wie die roten Kreuze und die weißen Rechtecke. |

| + | *Um das Jahr 2000 hatten viele Forscher den Ehrgeiz, sich der Shannon–Grenze bis auf Bruchteile von einem $\rm dB$ anzunähern. Das gelbe Kreuz markiert ein solches Ergebnis $(0.0045 \ \rm dB)$ von [CFRU01]<ref name='CFRU01'> | ||

| + | Chung S.Y; Forney Jr., G.D.; Richardson, T.J.; Urbanke, R.: On the Design of Low-Density Parity- Check Codes within 0.0045 dB of the Shannon Limit. – <br>In: IEEE Communications Letters, vol. 5, no. 2 (2001), pp. 58–60.</ref> mit einem irregulären LDPC–Code der Rate $ R =1/2$ und der Länge $n = 10^7$.}} | ||

| − | |||

| − | An dieser Stelle soll nochmals die | + | {{BlaueBox|TEXT= |

| + | $\text{Fazit:}$ | ||

| + | An dieser Stelle soll nochmals die Brillanz und der Weitblick von [https://de.wikipedia.org/wiki/Claude_Shannon Claude E. Shannon] hervorgehoben werden: | ||

*Er hat 1948 eine bis dahin nicht bekannte Theorie entwickelt, mit der die Möglichkeiten, aber auch die Grenzen der Digitalsignalübertragung aufgezeigt werden. | *Er hat 1948 eine bis dahin nicht bekannte Theorie entwickelt, mit der die Möglichkeiten, aber auch die Grenzen der Digitalsignalübertragung aufgezeigt werden. | ||

| − | *Zu dieser Zeit waren die ersten Überlegungen zur digitalen Nachrichtenübertragung gerade mal zehn Jahre alt ⇒ Pulscodemodulation (Alec Reeves, 1938) und selbst der Taschenrechner kam erst mehr als zwanzig Jahre später. | + | *Zu dieser Zeit waren die ersten Überlegungen zur digitalen Nachrichtenübertragung gerade mal zehn Jahre alt ⇒ [[Modulationsverfahren/Pulscodemodulation|Pulscodemodulation]] ([https://de.wikipedia.org/wiki/Alec_Reeves Alec Reeves], 1938) und selbst der Taschenrechner kam erst mehr als zwanzig Jahre später. |

| − | *Shannon's Arbeiten zeigen uns, dass man auch ohne gigantische Computer Großes leisten kann. | + | *Shannon's Arbeiten zeigen uns, dass man auch ohne gigantische Computer Großes leisten kann.}} |

== Kanalkapazität des komplexen AWGN–Kanals== | == Kanalkapazität des komplexen AWGN–Kanals== | ||

| + | <br> | ||

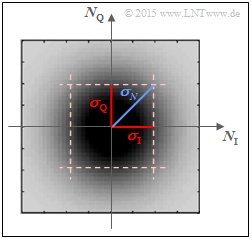

| + | Höherstufige Modulationsverfahren können jeweils durch eine Inphase– und eine Quadraturkomponente dargestellt werden. Hierzu gehören zum Beispiel | ||

| + | *die [[Modulationsverfahren/Quadratur–Amplitudenmodulation#QAM.E2.80.93Signalraumkonstellationen|M–QAM]] ⇒ Quadraturamplitudenmodulation; $M ≥ 4$ quadratisch angeordnete Signalraumpunkte, | ||

| + | *die [[Modulationsverfahren/Quadratur–Amplitudenmodulation#Weitere_Signalraumkonstellationen|M–PSK]] ⇒ $M ≥ 4$ Signalraumpunkte in kreisförmiger Anordnung. | ||

| − | |||

| − | |||

| − | |||

| − | + | Die beiden Komponenten lassen sich im [[Signaldarstellung/Äquivalentes_Tiefpass-Signal_und_zugehörige_Spektralfunktion#Motivation|äquivalenten Tiefpassbereich]] auch als Realteil bzw. Imaginärteil eines komplexen Rauschterms $N$ beschreiben. | |

| − | Die beiden Komponenten lassen sich im [[Signaldarstellung/Äquivalentes_Tiefpass-Signal_und_zugehörige_Spektralfunktion#Motivation|äquivalenten Tiefpassbereich]] auch als | + | *Alle oben genannten Verfahren sind zweidimensional. |

| − | Alle oben genannten Verfahren sind zweidimensional. Der (komplexe) AWGN–Kanal stellt somit $K = 2$ voneinander unabhängige Gaußkanäle zur Verfügung. Entsprechend der Seite [[Informationstheorie/AWGN–Kanalkapazität_bei_wertkontinuierlichem_Eingang#Parallele_Gau.C3.9Fsche_Kan.C3.A4le|Parallele Gaußsche Kanäle]] ergibt sich deshalb für die Kapazität eines solchen Kanals: | + | *Der (komplexe) AWGN–Kanal stellt somit $K = 2$ voneinander unabhängige Gaußkanäle zur Verfügung. |

| − | + | *Entsprechend der Seite [[Informationstheorie/AWGN–Kanalkapazität_bei_wertkontinuierlichem_Eingang#Parallele_Gau.C3.9Fsche_Kan.C3.A4le|Parallele Gaußsche Kanäle]] ergibt sich deshalb für die Kapazität eines solchen Kanals: | |

| − | :$$C_{\ | + | [[Datei:P_ID2955__Inf_T_4_3_S7.png|right|frame|2D–WDF des komplexen <br>Gaußschen Rauschens]] |

| + | :$$C_{\text{ Gauß, komplex} }= C_{\rm Gesamt} ( K=2) | ||

= {\rm log}_2 \hspace{0.1cm} ( 1 + \frac{P_X/2}{\sigma^2}) | = {\rm log}_2 \hspace{0.1cm} ( 1 + \frac{P_X/2}{\sigma^2}) | ||

\hspace{0.05cm}.$$ | \hspace{0.05cm}.$$ | ||

| − | * | + | *$P_X$ bezeichnet die gesamte Nutzleistung von Inphase– und Quadraturkomponente. |

| − | *Dagegen bezieht sich die Varianz $σ^2$ der Störung nur auf eine Dimension: $σ^2 = | + | *Dagegen bezieht sich die Varianz $σ^2$ der Störung nur auf eine Dimension: $σ^2 = σ_{\rm I}^2 = σ_{\rm Q}^2$. |

| − | |||

| − | |||

| − | |||

| − | |||

| + | Die Skizze zeigt die 2D–WDF $f_N(n)$ des Gaußschen Rauschprozesses $N$ über den beiden Achsen | ||

| + | * $N_{\rm I}$ (Inphase–Anteil, Realteil) und | ||

| + | * $N_{\rm Q}$ (Quadraturanteil, Imaginärteil). | ||

| − | Dunklere Bereiche der rotationssymmetrischen WDF $f_N(n)$ um den Nullpunkt weisen auf mehr Störanteile hin. Für die Varianz des komplexen Gaußschen Rauschens $N$ gilt aufgrund der Rotationsinvarianz $(σ_{\rm I} = σ_{\rm Q})$ folgender Zusammenhang: | + | |

| + | Dunklere Bereiche der rotationssymmetrischen WDF $f_N(n)$ um den Nullpunkt weisen auf mehr Störanteile hin. Für die Varianz des komplexen Gaußschen Rauschens $N$ gilt aufgrund der Rotationsinvarianz $(σ_{\rm I} = σ_{\rm Q})$ folgender Zusammenhang: | ||

:$$\sigma_N^2 = \sigma_{\rm I}^2 + \sigma_{\rm Q}^2 = 2\cdot \sigma^2 | :$$\sigma_N^2 = \sigma_{\rm I}^2 + \sigma_{\rm Q}^2 = 2\cdot \sigma^2 | ||

\hspace{0.05cm}.$$ | \hspace{0.05cm}.$$ | ||

| Zeile 304: | Zeile 342: | ||

Damit lässt sich die Kanalkapazität auch wie folgt ausdrücken: | Damit lässt sich die Kanalkapazität auch wie folgt ausdrücken: | ||

| − | :$$C_{\ | + | :$$C_{\text{ Gauß, komplex} }= {\rm log}_2 \hspace{0.1cm} ( 1 + \frac{P_X}{\sigma_N^2}) = {\rm log}_2 \hspace{0.1cm} ( 1 + SNR) |

\hspace{0.05cm}.$$ | \hspace{0.05cm}.$$ | ||

| − | + | Die Gleichung wird auf der nächsten Seite numerisch ausgewertet. Man kann aber jetzt schon sagen, dass für das Signal–zu–Störleistungsverhältnis gelten wird: | |

| − | \hspace{0.05cm}.$ | + | :$$SNR = {P_X}/{\sigma_N^2} |

| + | \hspace{0.05cm}.$$ | ||

==Maximale Coderate für QAM–Strukturen== | ==Maximale Coderate für QAM–Strukturen== | ||

| − | + | <br> | |

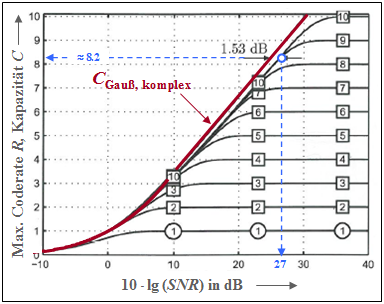

| − | [[Datei:P_ID2956__Inf_T_4_3_S8_neu.png|right|frame|Kanalkapazität von BPSK und | + | [[Datei:P_ID2956__Inf_T_4_3_S8_neu.png|right|frame|Kanalkapazität von BPSK und $M$–QAM]] |

| − | Die Grafik zeigt die | + | Die Grafik zeigt die Kapazität des komplexen AWGN–Kanals als rote Kurve: |

| − | :$$C_{\ | + | :$$C_{\text{ Gauß, komplex} }= {\rm log}_2 \hspace{0.1cm} ( 1 + SNR) |

\hspace{0.05cm}.$$ | \hspace{0.05cm}.$$ | ||

*Die Einheit dieser Kanalkapazität ist „bit/Kanalzugriff” oder „bit/Quellensymbol”. | *Die Einheit dieser Kanalkapazität ist „bit/Kanalzugriff” oder „bit/Quellensymbol”. | ||

| − | * | + | *Die Abszisse bezeichnet das Signal–zu–Störleistungsverhältnis $10 · \lg (SNR)$ mit ${SNR} = P_X/σ_N^2$. |

| − | *Die Grafik wurde | + | *Die Grafik wurde [Göb10]<ref name='Göb10'>Göbel, B.: Information–Theoretic Aspects of Fiber–Optic Communication Channels. Dissertation. TU München. <br>Verlag Dr. Hut, Reihe Informationstechnik, ISBN 978-3-86853-713-0, 2010.</ref> entnommen. Wir danken unserem ehemaligen Kollegen [[Biografien_und_Bibliografien/Beteiligte_der_Professur_Leitungsgebundene_Übertragungstechnik#Dr.-Ing._Bernhard_Göbel_(bei_LÜT_von_2004-2010)|Bernhard Göbel]], für sein Einverständnis, diese Abbildung verwenden zu dürfen, sowie für die große Unterstützung unseres Lerntutorials während seiner gesamten aktiven Zeit. |

| − | |||

| − | |||

| − | |||

| − | |||

| + | Die rote Kurve basiert entsprechend der Shannon–Theorie wieder auf einer Gaußverteilung $f_X(x)$ am Eingang. Zusätzlich eingezeichnet sind zehn weitere Kapazitätskurven für wertdiskreten Eingang: | ||

| + | *die Kurve für [[Modulationsverfahren/Lineare_digitale_Modulationsverfahren#BPSK_.E2.80.93_Binary_Phase_Shift_Keying|Binary Phase Shift Keying]] $($BPSK, mit „1” markiert ⇒ $K = 1)$, | ||

| + | *die [[Modulationsverfahren/Quadratur–Amplitudenmodulation#QAM.E2.80.93Signalraumkonstellationen|$M$–stufige Quadratur–Amplitudenmodulation]] $($mit $M = 2^K, K = 2$, ... , $10)$. | ||

| + | <br clear=all> | ||

Man erkennt aus dieser Darstellung: | Man erkennt aus dieser Darstellung: | ||

| − | *Alle Kurven (BPSK und | + | *Alle Kurven (BPSK und $M$–QAM) liegen rechts von der roten Shannon–Grenzkurve. Bei kleinem $SNR$ sind diese Kurven von der roten Kurve fast nicht unterscheidbar. |

| − | *Der Endwert aller Kurven für | + | *Der Endwert aller Kurven für wertdiskreten Eingang ist $K = \log_2 (M)$. Für $SNR \to ∞$ erhält man $C_{\rm BPSK} = 1$ (bit/Kanalzugriff) sowie $C_{\rm 4-QAM} = C_{\rm QPSK} = 2$. |

| − | *Die blauen Markierungen zeigen, dass eine $2^{10}$ | + | *Die blauen Markierungen zeigen, dass eine $\rm 2^{10}–QAM$ mit $10 · \lg (SNR) ≈ 27 \ \rm dB$ eine Coderate von $R ≈ 8.2$ ermöglicht. Abstand zur Shannon–Kurve: $1.53\ \rm dB$. |

| − | * | + | *Der "Shaping Gain" beträgt demnach $10 · \lg (π \cdot {\rm e}/6) = 1.53 \ \rm dB$. Diese Verbesserung lässt sich erzielen, wenn man die Lage der $2^{10} = 32^2$ quadratisch angeordneten Signalraumpunkte so ändert, dass sich eine gaußähnliche Eingangs–WDF ergibt ⇒ "Signal Shaping". |

| − | In der [[Aufgaben:4.Zehn_QPSK–Kanalkapazität| Aufgabe 4.10]] werden die AWGN–Kapazitätskurven von BPSK und QPSK diskutiert: | + | {{BlaueBox|TEXT= |

| − | *Ausgehend von der Abszisse $10 · \lg (E_{\rm B}/N_0)$ mit | + | $\text{Fazit:}$ |

| − | :$$C_{\rm QPSK}[10 \cdot {\rm lg} \hspace{0.1cm}(E_{\rm B}/{N_0})] | + | In der [[Aufgaben:4.Zehn_QPSK–Kanalkapazität| Aufgabe 4.10]] werden die AWGN–Kapazitätskurven von BPSK und QPSK diskutiert: |

| + | *Ausgehend von der Abszisse $10 · \lg (E_{\rm B}/N_0)$ mit $E_{\rm B}$ (Energie pro Informationsbit) kommt man zur QPSK–Kurve durch Verdopplung der BPSK–Kurve: | ||

| + | :$$C_{\rm QPSK}\big [10 \cdot {\rm lg} \hspace{0.1cm}(E_{\rm B}/{N_0})\big ] | ||

= | = | ||

| − | 2 \cdot C_{\rm BPSK}[10 \cdot {\rm lg} \hspace{0.1cm}(E_{\rm B}/{N_0}) ] .$$ | + | 2 \cdot C_{\rm BPSK}\big [10 \cdot {\rm lg} \hspace{0.1cm}(E_{\rm B}/{N_0}) \big ] .$$ |

| − | *Vergleicht man aber BPSK und QPSK bei gleicher Energie $E_{\rm S}$ pro Informationssymbol , so gilt: | + | *Vergleicht man aber BPSK und QPSK bei gleicher Energie $E_{\rm S}$ pro Informationssymbol, so gilt: |

:$$C_{\rm QPSK}[10 \cdot {\rm lg} \hspace{0.1cm}(E_{\rm S}/{N_0})] | :$$C_{\rm QPSK}[10 \cdot {\rm lg} \hspace{0.1cm}(E_{\rm S}/{N_0})] | ||

= | = | ||

2 \cdot C_{\rm BPSK}[10 \cdot {\rm lg} \hspace{0.1cm}(E_{\rm S}/{N_0}) - 3\,{\rm dB}] .$$ | 2 \cdot C_{\rm BPSK}[10 \cdot {\rm lg} \hspace{0.1cm}(E_{\rm S}/{N_0}) - 3\,{\rm dB}] .$$ | ||

| − | :Hierbei ist berücksichtigt, dass bei QPSK die Energie in einer Dimension nur $E_{\rm S} | + | :Hierbei ist berücksichtigt, dass bei QPSK die Energie in einer Dimension nur $E_{\rm S}/2$ beträgt.}} |

== Aufgaben zum Kapitel == | == Aufgaben zum Kapitel == | ||

| + | <br> | ||

| + | [[Aufgaben:4.8 Numerische Auswertung der AWGN-Kanalkapazität|Aufgabe 4.8: Numerische Auswertung der AWGN-Kanalkapazität]] | ||

| − | + | [[Aufgaben:4.8Z Was sagt die AWGN-Kanalkapazitätskurve aus?|Aufgabe 4.8Z: Was sagt die AWGN-Kanalkapazitätskurve aus?]] | |

| − | |||

| − | [[Aufgaben:4.8Z Was sagt die AWGN-Kanalkapazitätskurve aus?| | ||

| − | [[Aufgaben:4.9 Höherstufige Modulation|Aufgabe 4.9: | + | [[Aufgaben:4.9 Höherstufige Modulation|Aufgabe 4.9: Höherstufige Modulation]] |

| − | [[Aufgaben:4.9Z Ist bei BPSK die Kanalkapazität C ≡ 1 möglich?| | + | [[Aufgaben:4.9Z Ist bei BPSK die Kanalkapazität C ≡ 1 möglich?|Aufgabe 4.9Z: Ist bei BPSK die Kanalkapazität $C ≡ 1$ möglich?]] |

| − | [[Aufgaben: | + | [[Aufgaben:Aufgabe_4.Zehn:_QPSK–Kanalkapazität|Aufgabe 4.10: QPSK–Kanalkapazität]] |

== Quellenverzeichnis== | == Quellenverzeichnis== | ||

Aktuelle Version vom 28. August 2021, 14:24 Uhr

Inhaltsverzeichnis

- 1 AWGN–Modell für zeitdiskrete bandbegrenzte Signale

- 2 Die Kanalkapazität $C$ als Funktion von $E_{\rm S}/N_0$

- 3 Systemmodell zur Interpretation der AWGN–Kanalkapazität

- 4 Die Kanalkapazität $C$ als Funktion von $E_{\rm B}/N_0$

- 5 AWGN–Kanalkapazität für binäre Eingangssignale

- 6 Vergleich zwischen Theorie und Praxis

- 7 Kanalkapazität des komplexen AWGN–Kanals

- 8 Maximale Coderate für QAM–Strukturen

- 9 Aufgaben zum Kapitel

- 10 Quellenverzeichnis

AWGN–Modell für zeitdiskrete bandbegrenzte Signale

Am Ende des letzten Kapitels wurde das AWGN–Modell entsprechend der linken Grafik verwendet, gekennzeichnet durch die beiden Zufallsgrößen $X$ und $Y$ am Eingang und Ausgang sowie die stochastische Störung $N$ als das Ergebnis eines mittelwertfreien Gaußschen Zufallsprozesses ⇒ „Weißes Rauschen” mit der Varianz $σ_N^2$. Die Störleistung $P_N$ ist ebenfalls gleich $σ_N^2$.

Die maximale Transinformation $I(X; Y)$ zwischen Eingang und Ausgang ⇒ Kanalkapazität $C$ ergibt sich dann, wenn eine Gaußsche Eingangs–WDF $f_X(x)$ vorliegt. Mit der Sendeleistung $P_X = σ_X^2$ ⇒ Varianz der Zufallsgröße $X$ lautet die Kanalkapazitätsgleichung:

- $$C = 1/2 \cdot {\rm log}_2 \hspace{0.1cm} ( 1 + {P_X}/{P_N}) \hspace{0.05cm}.$$

Nun beschreiben wir das AWGN–Kanalmodell gemäß dem rechts skizzierten Fall, dass am Kanaleingang die Folge $〈X_ν〉$ anliegt, wobei der Abstand zwischen aufeinander folgenden Werten $T_{\rm A}$ beträgt. Diese Folge ist das zeitdiskrete Äquivalent des zeitkontinuierlichen Signals $X(t)$ nach Bandbegrenzung und Abtastung.

Der Zusammenhang zwischen beiden Modellen kann anhand einer Grafik hergestellt werden, die anschließend genauer beschrieben wird.

Die $\text{wesentlichen Erkenntnisse}$ vorneweg:

- Beim rechten Modell gilt zu den Abtastzeitpunkten $ν·T_{\rm A}$ der gleiche Zusammenhang $Y_ν = X_ν + N_ν$ wie beim linken Modell.

- Die Störkomponente $N_ν$ ist nun durch $($auf $±B)$ bandbegrenztes Weißes Rauschen mit der zweiseitigen Leistungsdichte ${\it Φ}_N(f) = N_0/2$ zu modellieren,

wobei $B = 1/(2T_{\rm A})$ gelten muss ⇒ siehe Abtasttheorem.

$\text{ Interpretation:}$

Beim modifizierten Modell gehen wir von einer unendlichen Folge $〈X_ν〉$ von Gaußschen Zufallsgrößen aus, die einem Diracpuls $p_δ(t)$ eingeprägt werden. Das resultierende zeitdiskrete Signal lautet somit:

- $$X_{\delta}(t) = T_{\rm A} \cdot \hspace{-0.1cm} \sum_{\nu = - \infty }^{+\infty} X_{\nu} \cdot \delta(t- \nu \cdot T_{\rm A} )\hspace{0.05cm}.$$

Der Abstand aller (gewichteten) Diracfunktionen ist einheitlich $T_{\rm A}$. Durch das Interpolationsfilter mit Impulsantwort $h(t)$ sowie Frequenzgang $H(f)$,

- $$h(t) = 1/T_{\rm A} \cdot {\rm sinc}(t/T_{\rm A}) \quad \circ\!\!\!-\!\!\!-\!\!\!-\!\!\bullet \quad H(f) = \left\{ \begin{array}{c} 1 \\ 0 \\ \end{array} \right. \begin{array}{*{20}c} {\rm{f\ddot{u}r}} \hspace{0.3cm} |f| \le B, \\ {\rm{f\ddot{u}r}} \hspace{0.3cm} |f| > B, \\ \end{array},$$

wobei die (einseitige) Bandbreite $B = 1/(2T_{\rm A})$ ist, entsteht das zeitkontinuierliche Signal $X(t)$ mit folgenden Eigenschaften:

- Die Abtastwerte $X(ν·T_{\rm A})$ sind für alle ganzzahligen $ν$ identisch mit den Eingangswerten $X_ν$, was mit den äquidistanten Nullstellen der Funktion $\text{sinc}(x) = \sin(\pi x)/(\pi x)$ begründet werden kann.

- Gemäß dem Abtasttheorem ist $X(t)$ auf den Spektralbereich $±B$ ideal bandbegrenzt ⇒ wegen rechteckförmigem Frequenzgang $H(f)$.

$\text{Störleisungsbetrachtung:}$ Nach der Addition der Störkomponente $N(t)$ mit der (zweiseitigen) Leistungsdichte ${\it Φ}_N(t) = N_0/2$ folgt das Matched–Filter $\rm (MF)$ mit $\rm sinc$–förmiger Impulsantwort. Für die Störleistung am MF–Ausgang gilt dann:

- $$P_N = {\rm E}\big[N_\nu^2 \big] = \frac{N_0}{2T_{\rm A} } = N_0 \cdot B\hspace{0.05cm}.$$

$\text{Beweis:}$ Mit $B = 1/(2T_{\rm A} )$ erhält man für die Impulsantwort $h_{\rm E}(t)$ und die Spektralfunktion $H_{\rm E}(f)$:

- $$h_{\rm E}(t) = 2B \cdot {\rm sinc}(2 B \cdot t) \quad \circ\!\!\!-\!\!\!-\!\!\!-\!\!\bullet \quad H_{\rm E}(f) = \left\{ \begin{array}{c} 1 \\ 0 \\ \end{array} \right. \begin{array}{*{20}c} \text{für} \hspace{0.3cm} \vert f \vert \le B, \\ \text{für} \hspace{0.3cm} \vert f \vert > B. \\ \end{array} $$

Daraus folgt entsprechend den Erkenntnissen der Stochastischen Systemtheorie:

- $$P_N = \int_{-\infty}^{+\infty} \hspace{-0.3cm} {\it \Phi}_N (f) \cdot \vert H_{\rm E}(f)\vert^2 \hspace{0.15cm}{\rm d}f = \int_{-B}^{+B} \hspace{-0.3cm} {\it \Phi}_N (f) \hspace{0.15cm}{\rm d}f = \frac{N_0}{2} \cdot 2B = N_0 \cdot B \hspace{0.05cm}.$$

Weiter gilt:

- Tastet man das Matched–Filter–Ausgangssignal in äquidistanten Abständen $T_{\rm A}$ ab, so ergibt sich für die Zeitpunkte $ν ·T_{\rm A}$ die gleiche Konstellation wie bisher, nämlich: $Y_ν = X_ν + N_ν$.

- Der Störanteil $N_ν$ im zeitdiskreten Ausgangssignal $Y_ν$ ist somit „bandbegrenzt” und „weiß” ⇒ Die Kanalkapazitätsgleichung muss nur geringfügig angepasst werden.

- Mit $E_{\rm S} = P_X \cdot T_{\rm A}$ ⇒ Sende–Energie innerhalb einer „Symboldauer” $T_{\rm A}$ ⇒ Exergie pro Symbol gilt dann:

- $$C = {1}/{2} \cdot {\rm log}_2 \hspace{0.1cm} ( 1 + \frac {P_X}{N_0 \cdot B}) = {1}/{2} \cdot {\rm log}_2 \hspace{0.1cm} ( 1 + \frac {2 \cdot P_X \cdot T_{\rm A}}{N_0}) = {1}/{2} \cdot {\rm log}_2 \hspace{0.1cm} ( 1 + \frac {2 \cdot E_{\rm S}}{N_0}) \hspace{0.05cm}.$$

Die Kanalkapazität $C$ als Funktion von $E_{\rm S}/N_0$

$\text{Beispiel 1:}$ Die Grafik zeigt den Verlauf der AWGN–Kanalkapazität in Abhängigkeit des Quotienten $E_{\rm S}/N_0$, wobei die linke Koordinatenachse und die roten Beschriftungen gültig sind:

- $$C = {1}/{2} \cdot {\rm log}_2 \hspace{0.1cm} ( 1 + \frac { 2 \cdot E_{\rm S} }{N_0}) \hspace{0.5cm}{\rm Einheit\hspace{-0.15cm}: \hspace{0.05cm}bit/Kanalzugriff} \hspace{0.05cm}.$$

Die (Pseudo–)Einheit wird manchmal auch mit „bit/Quellensymbol” oder kurz „bit/Symbol” bezeichnet.

Die rechte (blaue) Achsenbeschriftung berücksichtigt die Beziehung $B = 1/(2T_{\rm A})$ und liefert somit eine obere Schranke für die Bitrate $R$ eines Digitalsystems, die bei diesem AWGN–Kanal noch möglich ist.

- $$C^{\hspace{0.05cm}*} = \frac{C}{T_{\rm A} } = B \cdot {\rm log}_2 \hspace{0.1cm} ( 1 + \frac { 2 \cdot E_{\rm S} }{N_0}) \hspace{0.5cm}{\rm Einheit\hspace{-0.15cm}: \hspace{0.05cm}bit/Sekunde} \hspace{0.05cm}.$$

$\text{Beispiel 2:}$ Oft gibt man den Quotienten aus Symbolenergie $(E_{\rm S})$ und AWGN–Rauschleistungsdichte $(N_0)$ logarithmisch an.

- Diese Grafik zeigt die Kanalkapazitäten $C$ bzw. $C^{\hspace{0.05cm}*}$ als Funktion von $10 · \lg (E_{\rm S}/N_0)$ im Bereich von $-20 \ \rm dB$ bis $+30 \ \rm dB$.

- Oberhalb von $\approx 10 \ \rm dB$ ergibt sich hier ein (nahezu) linearer Verlauf.

Systemmodell zur Interpretation der AWGN–Kanalkapazität

Um das Kanalcodierungstheorem im Zusammenhang mit dem AWGN–Kanal besprechen zu können, benötigen wir noch eine „Codiervorrichtung”, die hier allerdings informationstheoretisch allein durch die Coderate $R$ gekennzeichnet wird.

Die Grafik beschreibt das von Shannon betrachtete Nachrichtensystem mit den Blöcken Quelle, Coder, (AWGN–)Kanal, Decoder und Empfänger. Im Hintergrund erkennt man ein Originalbild aus einem Aufsatz über die Shannon–Theorie. Rot eingezeichnet wurden von uns nur einige Bezeichnungen und Erläuterungen für den folgenden Text:

- Das Quellensymbol $U$ entstammt einem Alphabet mit $M_U = |U| = 2^k$ Symbolen und kann durch $k$ gleichwahrscheinliche statistisch unabhängige Binärsymbole repräsentiert werden.

- Das Alphabet des Codesymbols $X$ hat den Symbolumfang $M_X = |X| = 2^n$, wobei sich $n$ aus der Coderate $R = k/n$ ergibt.

- Für die Coderate $R = 1$ gilt somit $n = k$ und der Fall $n > k$ führt zu einer Coderate $R < 1$.

$\rm Kanalcodierungstheorem:$

Dieses besagt, dass es (mindestens) einen Code der Rate $R$ gibt, der zur Symbolfehlerwahrscheinlichkeit $p_{\rm S} = \text{Pr}(V ≠ U) \equiv 0$ führt, falls folgende Bedingungen erfüllt sind:

- Die Coderate $R$ ist nicht größer als die Kanalkapazität $C$.

- Ein solcher geeigneter Code ist unendlich lang: $n → ∞$. Deshalb ist auch tatsächlich eine Gaußverteilung $f_X(x)$ am Kanaleingang möglich, die der bisherigen Berechnung der AWGN–Kanalkapazität stets zugrunde gelegt wurde:

- $$C = {1}/{2} \cdot {\rm log}_2 \hspace{0.1cm} ( 1 + \frac { 2 \cdot E_{\rm S} }{N_0}) \hspace{1.3cm}{\rm Einheit\hspace{-0.15cm}: \hspace{0.05cm}bit/Kanalzugriff\hspace{0.15cm} (englisch\hspace{-0.15cm}: \hspace{0.05cm}bit/channel \hspace{0.15cm}use)} \hspace{0.05cm}.$$

- Die Kanaleingangsgröße $X$ ist also wertkontinuierlich. Gleiches gilt für $U$ und für die Größen $Y$, $V$ nach dem AWGN–Kanal.

- Für einen Systemvergleich ist die "Energie pro Symbol" $(E_{\rm S} )$ allerdings ungeeignet.

- Ein Vergleich sollte vielmehr auf der "Energie pro Informationsbit" ⇒ kurz: "Energie pro Bit" $(E_{\rm B})$ basieren. Mit $E_{\rm B} = E_{\rm S}/R$ gilt somit auch:

- $$C = {1}/{2} \cdot {\rm log}_2 \hspace{0.1cm} ( 1 + \frac { 2 \cdot R \cdot E_{\rm B} }{N_0}) \hspace{0.7cm}{\rm Einheit\hspace{-0.15cm}: \hspace{0.05cm}bit/Kanalzugriff\hspace{0.1cm} (englisch\hspace{-0.15cm}: \hspace{0.05cm}bit/channel \hspace{0.15cm}use)} \hspace{0.05cm}.$$

Diese beiden Gleichungen werden auf der nächsten Seite diskutiert.

Die Kanalkapazität $C$ als Funktion von $E_{\rm B}/N_0$

$\text{Beispiel 3:}$ Die Grafik zu diesem Beispiel zeigt die AWGN–Kanalkapazität $C$

- als Funktion von $10 · \lg (E_{\rm S}/N_0)$ ⇒ roter Kurvenverlauf:

- $$C = {1}/{2} \cdot {\rm log}_2 \hspace{0.1cm} ( 1 + \frac { 2 \cdot E_{\rm S} }{N_0}); \hspace{1.0cm}{\rm Einheit\hspace{-0.15cm}: \hspace{0.05cm}bit/Symbol} \hspace{0.05cm}.$$

- Rote Zahlenwerte: Kapazität $C$ in „bit/Symbol” für Abszissen

$10 · \lg (E_{\rm S}/N_0) = -20 \ \rm dB, -15 \ \rm dB$, ... , $+30\ \rm dB$;

- als Funktion von $10 · \lg (E_{\rm B}/N_0)$ ⇒ grüner Kurvenverlauf:

- $$C = {1}/{2} \cdot {\rm log}_2 \hspace{0.1cm} ( 1 + \frac { 2 \cdot R \cdot E_{\rm B} }{N_0}) ; \hspace{0.8cm}{\rm Einheit\hspace{-0.15cm}: \hspace{0.05cm}bit/Symbol} \hspace{0.05cm}; $$

- Grüne Zahlenwerte: Erforderliches $10 · \lg (E_{\rm B}/N_0)$ in „dB” für Ordinate $C = 0,\ 1$, ... , $5$ in „bit/Symbol”.

- Die ausführliche $C(E_{\rm B}/N_0)$–Berechnung finden Sie in der Aufgabe 4.8 und der zugehörigen Musterlösung.

Im Folgenden interpretieren wir das (grüne) $C(E_{\rm B}/N_0)$–Ergebnis im Vergleich zur (roten) $C(E_{\rm S}/N_0)$–Kurve:

- Wegen $E_{\rm S} = R · E_{\rm B}$ liegt der Schnittpunkt beider Kurven bei $C (= R) = 1$ bit/Symbol. Erforderlich sind $10 · \lg (E_{\rm S}/N_0) = 1.76$ dB bzw. $10 · \lg (E_{\rm B}/N_0) = 1.76$ dB gleichermaßen.

- Im Bereich $C > 1$ liegt die grüne Kurve stets über der roten. Beispielsweise ergibt sich für $10 · \lg (E_{\rm B}/N_0) = 20$ dB die Kanalkapazität $C ≈ 5$, für $10 · \lg (E_{\rm S}/N_0) = 20$ dB nur $C = 3.83$.

- Ein Vergleich in horizontaler Richtung zeigt, dass die Kanalkapazität $C = 3$ bit/Symbol schon mit $10 · \lg (E_{\rm B}/N_0) \approx 10$ dB erreichbar ist, man aber $10 · \lg (E_{\rm S}/N_0) \approx 15$ dB benötigt.

- Im Bereich $C < 1$ liegt die rote Kurve stets über der grünen. Für jedes $E_{\rm S}/N_0 > 0$ gilt $C > 0$. Bei logarithmischer Abszisse wie in der vorliegenden Darstellung reicht somit die rote Kurve bis ins „Minus–Unendliche”.

- Dagegen endet die grüne Kurve bei $E_{\rm B}/N_0 = \ln (2) = 0.693$ ⇒ $10 · \lg (E_{\rm B}/N_0)= -1.59$ dB ⇒ absolute Grenze für die (fehlerfreie) Übertragung über den AWGN–Kanal.

AWGN–Kanalkapazität für binäre Eingangssignale

Auf den bisherigen Seiten dieses Kapitels wurde stets gemäß der Shannon–Theorie von einem gaußverteilten, also wertkontinuierlichen AWGN–Eingang $X$ ausgegangen.

Nun betrachten wir den binären Fall und werden somit erst jetzt der Kapitel–Überschrift „AWGN–Kanalkapazität bei wertdiskretem Eingang” gerecht.

Die Grafik zeigt das zugrundeliegende Blockschaltbild für Binary Phase Shift Keying $\rm (BPSK)$ mit binärem Eingang $U$ und binärem Ausgang $V$.

Durch die bestmögliche Codierung soll erreicht werden, dass die Bitfehlerwahrscheinlichkeit $\text{Pr}(V ≠ U)$ verschwindend klein wird.

- Der Coderausgang ist gekennzeichnet durch die binäre Zufallsgröße $X \hspace{0.03cm}' = \{0, 1\}$ ⇒ $M_{X'} = 2$, während der Ausgang $Y$ des AWGN–Kanals weiterhin wertkontinuierlich ist: $M_Y → ∞$.

- Durch das Mapping $X = 1 - 2X\hspace{0.03cm} '$ kommt man von der unipolaren Darstellung zu der für BPSK besser geeigneten bipolaren (antipodalen) Beschreibung: $X\hspace{0.03cm} ' = 0 → \ X = +1; \hspace{0.5cm} X\hspace{0.03cm} ' = 1 → X = -1$.

- Der AWGN–Kanal wird durch zwei bedingte Wahrscheinlichkeitsdichtefunktionen charakterisiert:

- $$f_{Y\hspace{0.05cm}|\hspace{0.03cm}{X}}(y\hspace{0.05cm}|\hspace{0.03cm}{X}=+1) =\frac{1}{\sqrt{2\pi\sigma^2}} \cdot {\rm e}^{-{(y - 1)^2}/(2 \sigma^2)} \hspace{0.05cm}\hspace{0.05cm},\hspace{0.5cm}\text{Kurzform:} \ \ f_{Y\hspace{0.05cm}|\hspace{0.03cm}{X}}(y\hspace{0.05cm}|\hspace{0.03cm}+1)\hspace{0.05cm},$$

- $$f_{Y\hspace{0.05cm}|\hspace{0.03cm}{X}}(y\hspace{0.05cm}|\hspace{0.03cm}{X}=-1) =\frac{1}{\sqrt{2\pi\sigma^2}} \cdot {\rm e}^{-{(y + 1)^2}/(2 \sigma^2)} \hspace{0.05cm}\hspace{0.05cm},\hspace{0.5cm}\text{Kurzform:} \ \ f_{Y\hspace{0.05cm}|\hspace{0.03cm}{X}}(y\hspace{0.05cm}|\hspace{0.03cm}-1)\hspace{0.05cm}.$$

- Da hier das Nutzsignal $X$ auf $±1$ normiert ist ⇒ Leistung $1$ anstelle von $P_X$, muss die Varianz des AWGN–Rauschens $N$ in gleicher Weise normiert werden: $σ^2 = P_N/P_X$.

- Der Empfänger trifft aus der reellwertigen Zufallsgröße $Y$ (am AWGN–Kanalausgang) eine Maximum–Likelihood–Entscheidung. Der Empfängerausgang $V$ ist binär $(0$ oder $1)$.

Ausgehend von diesem Modell berechnen wir nun die Kanalkapazität des AWGN–Kanals.

Diese lautet bei einer binären Eingangsgröße $X$ allgemein unter Berücksichtigung von $\text{Pr}(X = -1) = 1 - \text{Pr}(X = +1)$:

- $$C_{\rm BPSK} = \max_{ {\rm Pr}({X} =+1)} \hspace{-0.15cm} I(X;Y) \hspace{0.05cm}.$$

Aufgrund des symmetrischen Kanals ist offensichtlich, dass die Eingangswahrscheinlichkeiten

- $${\rm Pr}(X =+1) = {\rm Pr}(X =-1) = 0.5 $$

zum Optimum führen werden. Gemäß der Seite Transinformationsberechnung bei additiver Störung gibt es mehrere Berechnungsmöglichkeiten:

- $$ \begin{align*}C_{\rm BPSK} & = h(X) + h(Y) - h(XY)\hspace{0.05cm},\\ C_{\rm BPSK} & = h(Y) - h(Y|X)\hspace{0.05cm},\\ C_{\rm BPSK} & = h(X) - h(X|Y)\hspace{0.05cm}. \end{align*}$$

Alle Ergebnisse sind noch um die Pseudo–Einheit „bit/Kanalzugriff” zu ergänzen.

Wir wählen hier die mittlere Gleichung:

- Die hierfür benötigte bedingte differentielle Entropie ist gleich

- $$h(Y\hspace{0.03cm}|\hspace{0.03cm}X) = h(N) = 1/2 \cdot {\rm log}_2 \hspace{0.1cm}(2\pi{\rm e}\cdot \sigma^2) \hspace{0.05cm}. $$

- Die differentielle Entropie $h(Y)$ ist vollständig durch die WDF $f_Y(y)$ gegeben. Mit den vorne definierten und skizzierten bedingten Wahrscheinlichkeitsdichtefunktionen erhält man:

- $$f_Y(y) = {1}/{2} \cdot \big [ f_{Y\hspace{0.03cm}|\hspace{0.03cm}{X}}(y\hspace{0.05cm}|\hspace{0.05cm}{X}=-1) + f_{Y\hspace{0.03cm}|\hspace{0.03cm}{X}}(y\hspace{0.05cm}|\hspace{0.05cm}{X}=+1) \big ]$$

- $$\Rightarrow \hspace{0.3cm} h(Y) \hspace{-0.01cm}=\hspace{0.05cm} -\hspace{-0.7cm} \int\limits_{y \hspace{0.05cm}\in \hspace{0.05cm}{\rm supp}(f_Y)} \hspace{-0.65cm} f_Y(y) \cdot {\rm log}_2 \hspace{0.1cm} [f_Y(y)] \hspace{0.1cm}{\rm d}y \hspace{0.05cm}.$$

Es ist offensichtlich, dass $h(Y)$ nur durch numerische Integration ermittelt werden kann, insbesondere, wenn man berücksichtigt, dass sich $f_Y(y)$ im Überlappungsbereich aus der Summe der beiden bedingten Gauß–Funktionen ergibt.

In der obigen Grafik sind über der Abszisse $10 · \lg (E_{\rm B}/N_0)$ drei Kurven dargestellt:

- die blau gezeichnete Kanalkapazität $C_{\rm Gauß}$, gültig für eine Gaußsche Eingangsgröße $X$ ⇒ $M_X → ∞$,

- die grün gezeichnete Kanalkapazität $C_{\rm BPSK}$ für die Zufallsgröße $X = (+1, –1)$, sowie

- die mit „BPSK ohne Codierung” bezeichnete rote Horizontale.

Diese Kurvenverläufe sind wie folgt zu interpretieren:

- Die grüne Kurve $C_{\rm BPSK}$ gibt die maximal zulässige Coderate $R$ von "Binary Phase Shift Keying" (BPSK) an, bei der für das gegebene $E_{\rm B}/N_0$ durch bestmögliche Codierung die Bitfehlerwahrscheinlichkeit $p_{\rm B} \equiv 0$ möglich ist.

- Für alle BPSK–Systeme mit den Koordinaten $(10 · \lg \ E_{\rm B}/N_0, \ R)$ im „grünen Bereich” ist $p_{\rm B} \equiv 0$ prinzipiell erreichbar. Aufgabe der Nachrichtentechniker ist es, hierfür geeignete Codes zu finden.

- Die BPSK–Kurve liegt stets unter der absoluten Shannon–Grenzkurve $C_{\rm Gauß}$ für $M_X → ∞$ (blaue Kurve). Im unteren Bereich gilt $C_{\rm BPSK} ≈ C_{\rm Gauß}$. Zum Beispiel muss ein BPSK–System mit $R = 1/2$ nur ein um $0.1\ \rm dB$ größeres $E_{\rm B}/N_0$ bereitstellen, als es die (absolute) Kanalkapazität $C_{\rm Gauß}$ fordert.

- Ist $E_{\rm B}/N_0$ endlich, so gilt stets $C_{\rm BPSK} < 1$ ⇒ siehe Aufgabe 4.9Z. Eine BPSK mit $R = 1$ (und somit ohne Codierung) wird also stets eine Bitfehlerwahrscheinlichkeit $p_{\rm B} > 0$ zur Folge haben.

- Die Fehlerwahrscheinlichkeiten eines solchen BPSK–Systems ohne Codierung $($mit $R = 1)$ sind auf der roten Horizontalen angegeben. Um $p_{\rm B} ≤ 10^{–5}$ zu erreichen, benötigt man demnach mindestens $10 · \lg (E_{\rm B}/N_0) = 9.6\ \rm dB$.

- Diese Wahrscheinlichkeiten ergeben sich gemäß dem Kapitel Fehlerwahrscheinlichkeit des optimalen BPSK-Systems im Buch „Digitalsignalübertragung” zu

- $$p_{\rm B} = {\rm Q} \left ( \sqrt{S \hspace{-0.06cm}N\hspace{-0.06cm}R}\right ) \hspace{0.45cm} {\rm mit } \hspace{0.45cm} S\hspace{-0.06cm}N\hspace{-0.06cm}R = 2\cdot E_{\rm B}/{N_0} \hspace{0.05cm}. $$

Hinweise:

- In obiger Grafik ist als zweite, zusätzliche Abszissenachse $10 · \lg (SNR)$ eingezeichnet. "SNR" steht hierbei für "Signal-to-Noise Ratio".

- Die Funktion ${\rm Q}(x)$ bezeichnet man als das komplementäre Gaußsche Fehlerintegral.

Vergleich zwischen Theorie und Praxis

Anhand zweier Grafiken soll gezeigt werden, in wie weit sich etablierte Kanalcodes der BPSK–Kanalkapazität (grüne Kurve) annähern. Als Ordinate aufgetragen ist die Rate $R = k/n$ dieser Codes bzw. die Kapazität $C$ (wenn noch die Pseudo–Einheit „bit/Kanalzugriff” hinzugefügt wird).

Vorausgesetzt ist:

- der AWGN–Kanal, gekennzeichnet durch $10 · \lg (E_{\rm B}/N_0)$ in dB, und

- für die durch Kreuze markierten realisierten Codes eine Bitfehlerrate $\rm (BER)$ von $10^{–5}$.

Zu beachten ist, dass die Kanalkapazitätskurven stets für $n → ∞$ und $\rm BER \equiv 0$ gelten.

- Würde man die strenge Forderung „fehlerfrei” auch an die Kanalcodes endlicher Codelänge $n$ anlegen, so wäre hierfür stets $10 · \lg \ (E_{\rm B}/N_0) \to \infty$ erforderlich.

- Dies ist aber ein eher akademisches Problem, also wenig praxisrelevant. Für $\text{BER} = 10^{–10}$ ergäbe sich eine qualitativ ähnliche Grafik.

$\text{Beispiel 4:}$ In der Grafik sind die Kenndaten von frühen Systemen mit Kanalcodierung und klassischer Decodierung angegeben. Es folgen einige Erläuterungen zu den Daten, die der Vorlesung [Liv10][1] entnommen wurden. Die Links bei diesen Erläuterungen beziehen sich oft auf das $\rm LNTwww$–Buch Kanalcodierung.

- Die Punkte $\rm A$, $\rm B$ und $\rm C$ markieren Hamming–Codes der Raten $R = 4/7 ≈ 0.57$, $R ≈ 0.73$ bzw. $R ≈ 0.84$. Für $\text{BER} = 10^{–5}$ benötigen diese sehr frühen Codes (aus dem Jahr 1950) alle $10 · \lg (E_{\rm B}/N_0) > 8\ \rm dB$.

- Die Markierung $\rm D$ kennzeichnet den binären Golay–Code mit der Rate $R = 1/2$ und der Punkt $\rm E$ einen Reed–Muller–Code. Dieser sehr niederratige Code kam bereits 1971 bei der Raumsonde Mariner 9 zum Einsatz.

- Die Reed–Solomon–Codes (RS–Codes, ca. 1960) sind eine Klasse zyklischer Blockcodes. $\rm F$ markiert einen RS–Code der Rate $223/255 \approx 0.875$ und einem erforderlichen $E_{\rm B}/N_0 < 6 \ \rm dB$.

- $\rm G$ und $\rm H$ bezeichnen zwei Faltungscodes $($englisch: "Convolutional Codes", $\rm CC)$ mittlerer Rate. Der Code $\rm G$ wurde schon 1972 bei der Pioneer 10–Mission eingesetzt.

- Die Kanalcodierung der Voyager–Mission Ende der 1970er Jahre ist mit $\rm I$ markiert. Es handelt sich um die Verkettung eines $\text{(2, 1, 7)}$–Faltungscodes mit einem Reed–Solomon–Code.

Anzumerken ist, dass bei den Faltungscodes der dritte Kennungsparameter eine andere Bedeutung hat als bei den Blockcodes. So weist beispielsweise die Kennung $\text{(2, 1, 32)}$ auf das Memory $m = 32$ hin.

$\text{Beispiel 5:}$ Die im $\text{Beispiel 4}$ genannten frühen Kanalcodes liegen noch relativ weit von der Kanalkapazitätskurve entfernt.

Dies war wahrscheinlich auch ein Grund, warum dem Autor dieses Lerntutorials die auch große praktische Bedeutung der Informationstheorie verschlossen blieb, als er diese Anfang der 1970er Jahre im Studium kennengelernt hat.

Die Sichtweise hat sich deutlich verändert, als in den 1990er Jahren sehr lange Kanalcodes zusammen mit iterativer Decodierung aufkamen. Die neuen Markierungspunkte liegen deutlich näher an der Kapazitätsgrenzkurve.

Hier noch einige Erläuterungen zu dieser Grafik:

- Rote Kreuze markieren die so genannten Turbo–Codes nach $\rm CCSDS$ ("Consultative Committee for Space Data Systems") mit jeweils $k = 6920$ Informationsbit und unterschiedlichen Codelängen $n = k/R$. Diese von Claude Berrou um 1990 erfundenen Codes können iterativ decodiert werden. Die (roten) Markierungen liegen jeweils weniger als $1 \ \rm dB$ von der Shannon–Grenze entfernt.

- Ähnlich verhalten sich die LDPC–Codes ("Low Density Parity–check Codes") mit konstanter Codelänge $n = 64800$ ⇒ weiße Rechtecke. Sie werden seit 2006 bei DVB–S2 ("Digital Video Broadcast over Satellite") eingesetzt und eignen sich aufgrund der spärlichen Einsen–Belegung der Prüfmatrix sehr gut für die iterative Decodierung mittels Faktor–Graphen und Exit Charts.

- Schwarze Punkte markieren die von $\rm CCSDS$ spezifizierten LDPC–Codes mit konstanter Anzahl an Informationsbits $(k = 16384)$ und variabler Wortlänge $n = k/R$. Diese Codeklasse erfordert ein ähnliches $E_{\rm B}/N_0$ wie die roten Kreuze und die weißen Rechtecke.

- Um das Jahr 2000 hatten viele Forscher den Ehrgeiz, sich der Shannon–Grenze bis auf Bruchteile von einem $\rm dB$ anzunähern. Das gelbe Kreuz markiert ein solches Ergebnis $(0.0045 \ \rm dB)$ von [CFRU01][2] mit einem irregulären LDPC–Code der Rate $ R =1/2$ und der Länge $n = 10^7$.

$\text{Fazit:}$ An dieser Stelle soll nochmals die Brillanz und der Weitblick von Claude E. Shannon hervorgehoben werden:

- Er hat 1948 eine bis dahin nicht bekannte Theorie entwickelt, mit der die Möglichkeiten, aber auch die Grenzen der Digitalsignalübertragung aufgezeigt werden.

- Zu dieser Zeit waren die ersten Überlegungen zur digitalen Nachrichtenübertragung gerade mal zehn Jahre alt ⇒ Pulscodemodulation (Alec Reeves, 1938) und selbst der Taschenrechner kam erst mehr als zwanzig Jahre später.

- Shannon's Arbeiten zeigen uns, dass man auch ohne gigantische Computer Großes leisten kann.

Kanalkapazität des komplexen AWGN–Kanals

Höherstufige Modulationsverfahren können jeweils durch eine Inphase– und eine Quadraturkomponente dargestellt werden. Hierzu gehören zum Beispiel

- die M–QAM ⇒ Quadraturamplitudenmodulation; $M ≥ 4$ quadratisch angeordnete Signalraumpunkte,

- die M–PSK ⇒ $M ≥ 4$ Signalraumpunkte in kreisförmiger Anordnung.

Die beiden Komponenten lassen sich im äquivalenten Tiefpassbereich auch als Realteil bzw. Imaginärteil eines komplexen Rauschterms $N$ beschreiben.

- Alle oben genannten Verfahren sind zweidimensional.

- Der (komplexe) AWGN–Kanal stellt somit $K = 2$ voneinander unabhängige Gaußkanäle zur Verfügung.

- Entsprechend der Seite Parallele Gaußsche Kanäle ergibt sich deshalb für die Kapazität eines solchen Kanals:

- $$C_{\text{ Gauß, komplex} }= C_{\rm Gesamt} ( K=2) = {\rm log}_2 \hspace{0.1cm} ( 1 + \frac{P_X/2}{\sigma^2}) \hspace{0.05cm}.$$

- $P_X$ bezeichnet die gesamte Nutzleistung von Inphase– und Quadraturkomponente.

- Dagegen bezieht sich die Varianz $σ^2$ der Störung nur auf eine Dimension: $σ^2 = σ_{\rm I}^2 = σ_{\rm Q}^2$.

Die Skizze zeigt die 2D–WDF $f_N(n)$ des Gaußschen Rauschprozesses $N$ über den beiden Achsen

- $N_{\rm I}$ (Inphase–Anteil, Realteil) und

- $N_{\rm Q}$ (Quadraturanteil, Imaginärteil).

Dunklere Bereiche der rotationssymmetrischen WDF $f_N(n)$ um den Nullpunkt weisen auf mehr Störanteile hin. Für die Varianz des komplexen Gaußschen Rauschens $N$ gilt aufgrund der Rotationsinvarianz $(σ_{\rm I} = σ_{\rm Q})$ folgender Zusammenhang:

- $$\sigma_N^2 = \sigma_{\rm I}^2 + \sigma_{\rm Q}^2 = 2\cdot \sigma^2 \hspace{0.05cm}.$$

Damit lässt sich die Kanalkapazität auch wie folgt ausdrücken:

- $$C_{\text{ Gauß, komplex} }= {\rm log}_2 \hspace{0.1cm} ( 1 + \frac{P_X}{\sigma_N^2}) = {\rm log}_2 \hspace{0.1cm} ( 1 + SNR) \hspace{0.05cm}.$$

Die Gleichung wird auf der nächsten Seite numerisch ausgewertet. Man kann aber jetzt schon sagen, dass für das Signal–zu–Störleistungsverhältnis gelten wird:

- $$SNR = {P_X}/{\sigma_N^2} \hspace{0.05cm}.$$

Maximale Coderate für QAM–Strukturen

Die Grafik zeigt die Kapazität des komplexen AWGN–Kanals als rote Kurve:

- $$C_{\text{ Gauß, komplex} }= {\rm log}_2 \hspace{0.1cm} ( 1 + SNR) \hspace{0.05cm}.$$

- Die Einheit dieser Kanalkapazität ist „bit/Kanalzugriff” oder „bit/Quellensymbol”.

- Die Abszisse bezeichnet das Signal–zu–Störleistungsverhältnis $10 · \lg (SNR)$ mit ${SNR} = P_X/σ_N^2$.

- Die Grafik wurde [Göb10][3] entnommen. Wir danken unserem ehemaligen Kollegen Bernhard Göbel, für sein Einverständnis, diese Abbildung verwenden zu dürfen, sowie für die große Unterstützung unseres Lerntutorials während seiner gesamten aktiven Zeit.

Die rote Kurve basiert entsprechend der Shannon–Theorie wieder auf einer Gaußverteilung $f_X(x)$ am Eingang. Zusätzlich eingezeichnet sind zehn weitere Kapazitätskurven für wertdiskreten Eingang:

- die Kurve für Binary Phase Shift Keying $($BPSK, mit „1” markiert ⇒ $K = 1)$,

- die $M$–stufige Quadratur–Amplitudenmodulation $($mit $M = 2^K, K = 2$, ... , $10)$.

Man erkennt aus dieser Darstellung:

- Alle Kurven (BPSK und $M$–QAM) liegen rechts von der roten Shannon–Grenzkurve. Bei kleinem $SNR$ sind diese Kurven von der roten Kurve fast nicht unterscheidbar.

- Der Endwert aller Kurven für wertdiskreten Eingang ist $K = \log_2 (M)$. Für $SNR \to ∞$ erhält man $C_{\rm BPSK} = 1$ (bit/Kanalzugriff) sowie $C_{\rm 4-QAM} = C_{\rm QPSK} = 2$.

- Die blauen Markierungen zeigen, dass eine $\rm 2^{10}–QAM$ mit $10 · \lg (SNR) ≈ 27 \ \rm dB$ eine Coderate von $R ≈ 8.2$ ermöglicht. Abstand zur Shannon–Kurve: $1.53\ \rm dB$.

- Der "Shaping Gain" beträgt demnach $10 · \lg (π \cdot {\rm e}/6) = 1.53 \ \rm dB$. Diese Verbesserung lässt sich erzielen, wenn man die Lage der $2^{10} = 32^2$ quadratisch angeordneten Signalraumpunkte so ändert, dass sich eine gaußähnliche Eingangs–WDF ergibt ⇒ "Signal Shaping".

$\text{Fazit:}$ In der Aufgabe 4.10 werden die AWGN–Kapazitätskurven von BPSK und QPSK diskutiert:

- Ausgehend von der Abszisse $10 · \lg (E_{\rm B}/N_0)$ mit $E_{\rm B}$ (Energie pro Informationsbit) kommt man zur QPSK–Kurve durch Verdopplung der BPSK–Kurve:

- $$C_{\rm QPSK}\big [10 \cdot {\rm lg} \hspace{0.1cm}(E_{\rm B}/{N_0})\big ] = 2 \cdot C_{\rm BPSK}\big [10 \cdot {\rm lg} \hspace{0.1cm}(E_{\rm B}/{N_0}) \big ] .$$

- Vergleicht man aber BPSK und QPSK bei gleicher Energie $E_{\rm S}$ pro Informationssymbol, so gilt:

- $$C_{\rm QPSK}[10 \cdot {\rm lg} \hspace{0.1cm}(E_{\rm S}/{N_0})] = 2 \cdot C_{\rm BPSK}[10 \cdot {\rm lg} \hspace{0.1cm}(E_{\rm S}/{N_0}) - 3\,{\rm dB}] .$$

- Hierbei ist berücksichtigt, dass bei QPSK die Energie in einer Dimension nur $E_{\rm S}/2$ beträgt.

Aufgaben zum Kapitel

Aufgabe 4.8: Numerische Auswertung der AWGN-Kanalkapazität

Aufgabe 4.8Z: Was sagt die AWGN-Kanalkapazitätskurve aus?

Aufgabe 4.9: Höherstufige Modulation

Aufgabe 4.9Z: Ist bei BPSK die Kanalkapazität $C ≡ 1$ möglich?

Aufgabe 4.10: QPSK–Kanalkapazität

Quellenverzeichnis

- ↑ Liva, G.: Channel Coding. Vorlesungsmanuskript, Lehrstuhl für Nachrichtentechnik, TU München und DLR Oberpfaffenhofen, 2010.

- ↑

Chung S.Y; Forney Jr., G.D.; Richardson, T.J.; Urbanke, R.: On the Design of Low-Density Parity- Check Codes within 0.0045 dB of the Shannon Limit. –

In: IEEE Communications Letters, vol. 5, no. 2 (2001), pp. 58–60. - ↑ Göbel, B.: Information–Theoretic Aspects of Fiber–Optic Communication Channels. Dissertation. TU München.

Verlag Dr. Hut, Reihe Informationstechnik, ISBN 978-3-86853-713-0, 2010.