Stochastische Signaltheorie/Autokorrelationsfunktion (AKF): Unterschied zwischen den Versionen

| (4 dazwischenliegende Versionen desselben Benutzers werden nicht angezeigt) | |||

| Zeile 7: | Zeile 7: | ||

==Zufallsprozesse== | ==Zufallsprozesse== | ||

<br> | <br> | ||

| − | Ein wichtiger Begriff der stochastischen Signaltheorie ist der | + | Ein wichtiger Begriff der stochastischen Signaltheorie ist der "Zufallsprozess". Nachfolgend sind einige Charakteristika eines solchen "stochastischen Prozesses" – diese Bezeichnungen werden sowohl in der Literatur als auch in unserem Tutorial synonym verwendet – zusammengestellt. |

{{BlaueBox|TEXT= | {{BlaueBox|TEXT= | ||

| − | $\text{Definitionen:}$ Unter einem '''Zufallsprozess''' $\{x_i(t)\}$ verstehen wir ein | + | $\text{Definitionen:}$ Unter einem '''Zufallsprozess''' $\{x_i(t)\}$ verstehen wir ein mathematisches Modell für ein Ensemble von (vielen) Zufallssignalen, die sich zwar im Detail durchaus voneinander unterscheiden können und auch werden, trotzdem aber gewisse gemeinsame Eigenschaften aufweisen. |

| − | *Zur Beschreibung eines Zufallsprozesses $\{x_i(t)\}$ gehen wir von der Vorstellung aus, dass beliebig viele, in ihren physikalischen und statistischen Eigenschaften völlig gleiche Zufallsgeneratoren vorhanden sind, von denen jeder ein Zufallssignal $x_i(t)$ liefert. | + | *Zur Beschreibung eines Zufallsprozesses $\{x_i(t)\}$ gehen wir von der Vorstellung aus, dass beliebig viele, in ihren physikalischen und statistischen Eigenschaften völlig gleiche Zufallsgeneratoren vorhanden sind, von denen jeder ein Zufallssignal $x_i(t)$ liefert. |

| − | *Jeder Zufallsgenerator gibt trotz gleicher physikalischer Realisierung ein anderes Zeitsignal $x_i(t)$ ab, das für alle Zeiten von $–∞$ bis $+∞$ existiert. Man bezeichnet dieses spezifische Zufallssignal als das '''$i$-te Mustersignal'''. | + | *Jeder Zufallsgenerator gibt trotz gleicher physikalischer Realisierung ein anderes Zeitsignal $x_i(t)$ ab, das für alle Zeiten von $–∞$ bis $+∞$ existiert. Man bezeichnet dieses spezifische Zufallssignal als das '''$i$-te Mustersignal'''. |

*Jeder Zufallsprozess beinhaltet mindestens eine stochastische Komponente – zum Beispiel die Amplitude, Frequenz oder Phase eines Nachrichtensignals – und kann daher von einem Beobachter nicht exakt vorausgesagt werden. | *Jeder Zufallsprozess beinhaltet mindestens eine stochastische Komponente – zum Beispiel die Amplitude, Frequenz oder Phase eines Nachrichtensignals – und kann daher von einem Beobachter nicht exakt vorausgesagt werden. | ||

| − | *Der Zufallsprozess unterscheidet sich von den sonst in der Wahrscheinlichkeitsrechnung bzw. der Statistik üblichen Zufallsexperimenten dadurch, dass das Ergebnis kein | + | *Der Zufallsprozess unterscheidet sich von den sonst in der Wahrscheinlichkeitsrechnung bzw. der Statistik üblichen Zufallsexperimenten dadurch, dass das Ergebnis kein "Ereignis" ist, sondern ein "Funktionsverlauf"' (Zeitsignal). |

| − | *Betrachtet man den Zufallsprozess $\{x_i(t)\}$ zu einem festen Zeitpunkt, so gelangt man wieder zu dem einfacheren Modell aus dem Kapitel [[Stochastische_Signaltheorie/Vom_Zufallsexperiment_zur_Zufallsgröße|Vom Zufallsexperiment zur Zufallsgröße]], nach dem das Versuchsergebnis ein Ereignis ist, das einer Zufallsgröße zugeordnet werden kann.}} | + | *Betrachtet man den Zufallsprozess $\{x_i(t)\}$ zu einem festen Zeitpunkt, so gelangt man wieder zu dem einfacheren Modell aus dem Kapitel [[Stochastische_Signaltheorie/Vom_Zufallsexperiment_zur_Zufallsgröße|Vom Zufallsexperiment zur Zufallsgröße]], nach dem das Versuchsergebnis ein Ereignis ist, das einer Zufallsgröße zugeordnet werden kann.}} |

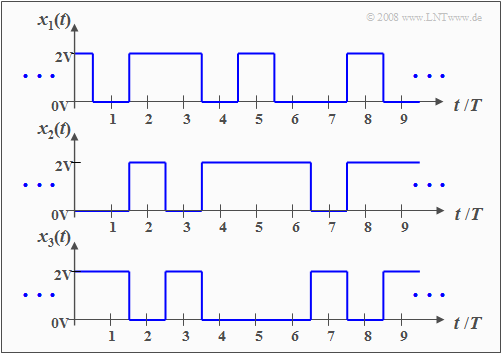

| − | Diese Aussagen werden nun am Beispiel eines binären Zufallsgenerators verdeutlicht, der – zumindest gedanklich – beliebig oft realisiert werden kann. | + | Diese Aussagen werden nun am Beispiel eines binären Zufallsgenerators verdeutlicht, der – zumindest gedanklich – beliebig oft realisiert werden kann. |

{{GraueBox|TEXT= | {{GraueBox|TEXT= | ||

| Zeile 24: | Zeile 24: | ||

[[Datei:Sto_T_4_4_S1.png|450px|right|frame| Zur Definition eines Zufallsprozesses]] | [[Datei:Sto_T_4_4_S1.png|450px|right|frame| Zur Definition eines Zufallsprozesses]] | ||

| − | *Der hier vorliegende Zufallsprozess $\{x_i(t)\}$ besteht aus einem Ensemble rechteckförmiger Musterfunktionen, die wie folgt beschrieben werden können: | + | *Der hier vorliegende Zufallsprozess $\{x_i(t)\}$ besteht aus einem Ensemble rechteckförmiger Musterfunktionen, die wie folgt beschrieben werden können: |

:$$x_i(t)=\sum^{+\infty}_{\nu=-\infty} (a_\nu)_i\cdot g(t-\nu \cdot T ).$$ | :$$x_i(t)=\sum^{+\infty}_{\nu=-\infty} (a_\nu)_i\cdot g(t-\nu \cdot T ).$$ | ||

| − | *Der Grundimpuls $g(t)$ besitzt im Bereich von $–T/2$ bis $+T/2$ den Wert $2\hspace{0.03cm}\rm V$; | + | *Der Grundimpuls $g(t)$ besitzt im Bereich von $–T/2$ bis $+T/2$ den Wert $2\hspace{0.03cm}\rm V$. Außerhalb ist er Null und exakt bei $\pm T/2$ nur halb so groß $(1\hspace{0.03cm}\rm V)$. |

| − | *Erinnern wir uns: Ein Impuls ist gemäß der Definition im Kapitel [[Signaldarstellung/Klassifizierung_von_Signalen|Klassifizierung von Signalen]] im Buch „Signaldarstellung” ein sowohl | + | *Erinnern wir uns: Ein Impuls ist gemäß der Definition im Kapitel [[Signaldarstellung/Klassifizierung_von_Signalen|Klassifizierung von Signalen]] im Buch „Signaldarstellung” ein sowohl "deterministisches" als auch "energiebegrenztes" Signal. |

*Die Statistik des betrachteten Zufallsprozesses ist allein auf die dimensionslosen Amplitudenkoeffizienten $(a_ν)_i ∈ \{0, 1\}$ zurückzuführen, die bei der $i$-ten Musterfunktion mit dem Zeitindex $ν$ versehen sind. | *Die Statistik des betrachteten Zufallsprozesses ist allein auf die dimensionslosen Amplitudenkoeffizienten $(a_ν)_i ∈ \{0, 1\}$ zurückzuführen, die bei der $i$-ten Musterfunktion mit dem Zeitindex $ν$ versehen sind. | ||

| − | *Trotz der im Detail unterschiedlichen Signalverläufe weisen die skizzierten Signale $x_1(t)$, $x_2(t)$, $x_3(t)$ und auch alle weiteren Mustersignale $x_4(t)$, $x_5(t)$, $x_6(t)$, ... gewisse Gemeinsamkeiten auf, die nachfolgend herausgearbeitet werden sollen. }} | + | *Trotz der im Detail unterschiedlichen Signalverläufe weisen die skizzierten Signale $x_1(t)$, $x_2(t)$, $x_3(t)$ und auch alle weiteren Mustersignale $x_4(t)$, $x_5(t)$, $x_6(t)$, ... gewisse Gemeinsamkeiten auf, die nachfolgend herausgearbeitet werden sollen. }} |

==Stationäre Zufallsprozesse== | ==Stationäre Zufallsprozesse== | ||

| Zeile 44: | Zeile 44: | ||

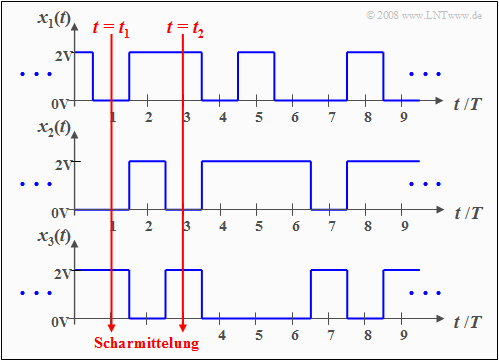

| − | + | $\text{Hinweis zur Nomenklatur:}$ Beachten Sie bitte, dass | |

*$x_1(t)$ und $x_2(t)$ Musterfunktionen des Zufallsprozesses $\{x_i(t)\}$ sind, | *$x_1(t)$ und $x_2(t)$ Musterfunktionen des Zufallsprozesses $\{x_i(t)\}$ sind, | ||

*während die Zufallsgrößen $x_1$ und $x_2$ den gesamten Prozess zu den Zeiten $t_1$ und $t_2$ charakterisieren. | *während die Zufallsgrößen $x_1$ und $x_2$ den gesamten Prozess zu den Zeiten $t_1$ und $t_2$ charakterisieren. | ||

| − | Die Berechnung der statistischen Kenngrößen muss durch Scharmittelung über alle möglichen Musterfunktionen erfolgen $($Mittelung über die Laufvariable $i$, also über alle Realisierungen$)$. | + | Die Berechnung der statistischen Kenngrößen muss durch Scharmittelung über alle möglichen Musterfunktionen erfolgen $($Mittelung über die Laufvariable $i$, also über alle Realisierungen$)$. |

<br clear=all> | <br clear=all> | ||

{{BlaueBox|TEXT= | {{BlaueBox|TEXT= | ||

| Zeile 55: | Zeile 55: | ||

*Bei einem '''stationären Zufallsprozess''' $\{x_i(t)\}$ sind alle statistischen Kenngrößen $($Mittelwert, Streuung, Momente höherer Ordnung, Auftrittswahrscheinlichkeiten, etc.$)$ der Zufallsgrößen $x_1 = \{ x_i(t_1)\}$ und $x_2 = \{ x_i(t_2)\}$ gleich. | *Bei einem '''stationären Zufallsprozess''' $\{x_i(t)\}$ sind alle statistischen Kenngrößen $($Mittelwert, Streuung, Momente höherer Ordnung, Auftrittswahrscheinlichkeiten, etc.$)$ der Zufallsgrößen $x_1 = \{ x_i(t_1)\}$ und $x_2 = \{ x_i(t_2)\}$ gleich. | ||

*Auch zu anderen Zeitpunkten ergeben sich genau gleiche Werte. | *Auch zu anderen Zeitpunkten ergeben sich genau gleiche Werte. | ||

| − | + | *Die Umkehrung lautet: Man bezeichnet einen Zufallsprozess $\{x_i(t)\}$ als "nicht-stationär", wenn er zu verschiedenen Zeitpunkten unterschiedliche statistische Eigenschaften aufweist. }} | |

| − | |||

| − | Die Umkehrung lautet: Man bezeichnet einen Zufallsprozess $\{x_i(t)\}$ als | ||

{{GraueBox|TEXT= | {{GraueBox|TEXT= | ||

$\text{Beispiel 2:}$ | $\text{Beispiel 2:}$ | ||

| − | Eine große Anzahl von Mess-Stationen am Äquator ermitteln täglich um 12 Uhr Ortszeit die Temperatur. Mittelt man über all diese Messwerte, so kann man den Einfluss lokaler Indikatoren (z. B. Golfstrom) eliminieren. Trägt man die | + | Eine große Anzahl von Mess-Stationen am Äquator ermitteln täglich um 12 Uhr Ortszeit die Temperatur. |

| − | + | *Mittelt man über all diese Messwerte, so kann man den Einfluss lokaler Indikatoren (z. B. Golfstrom) eliminieren. | |

| − | Eine vergleichbare Messreihe am 50. Breitengrad würde aufgrund der jahreszeitlichen Schwankungen auf einen | + | *Trägt man die Scharmittelwerte über der Zeit auf, so wird sich nahezu eine Konstante ergeben, und man kann von einem "stationären Prozess" sprechen. |

| + | *Eine vergleichbare Messreihe am 50. Breitengrad würde aufgrund der jahreszeitlichen Schwankungen auf einen "nicht-stationären Prozess" hinweisen mit deutlichen Unterschieden hinsichtlich Mittelwert und Varianz der Mittagstemperatur zwischen Januar und Juli. | ||

}} | }} | ||

==Ergodische Zufallsprozesse== | ==Ergodische Zufallsprozesse== | ||

<br> | <br> | ||

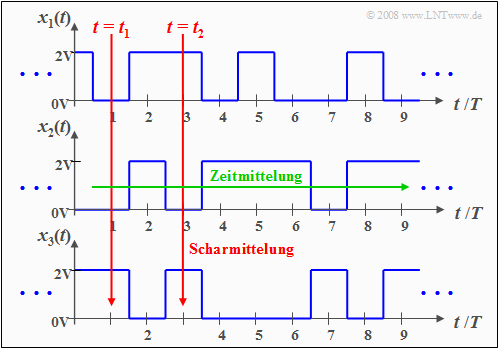

| − | Eine wichtige Unterklasse der stationären Zufallsprozesse sind die so genannten | + | Eine wichtige Unterklasse der stationären Zufallsprozesse sind die so genannten "ergodischen Prozesse" mit folgenden Eigenschaften: |

{{BlaueBox|TEXT= | {{BlaueBox|TEXT= | ||

| − | $\text{Definition:}$ Bei einem ergodischen Prozess $\{x_i(t)\}$ ist jede einzelne Musterfunktion $x_i(t)$ repräsentativ für das gesamte Ensemble. | + | $\text{Definition:}$ Bei einem '''ergodischen Prozess''' $\{x_i(t)\}$ ist jede einzelne Musterfunktion $x_i(t)$ repräsentativ für das gesamte Ensemble. |

| − | *Alle statistischen Beschreibungsgrößen eines ergodischen Prozesses kann man aus einer einzigen Musterfunktion durch Zeitmittelung (bezüglich der Laufvariablen $ν = t/T$ ⇒ normierte Zeit) gewinnen. | + | *Alle statistischen Beschreibungsgrößen eines ergodischen Prozesses kann man aus einer einzigen Musterfunktion durch Zeitmittelung $($bezüglich der Laufvariablen $ν = t/T$ ⇒ normierte Zeit$)$ gewinnen. |

| − | *Das bedeutet auch: Bei Ergodizität stimmen die Zeitmittelwerte einer jeden Musterfunktion mit den entsprechenden Scharmittelwerten zu beliebigen Zeitpunkten $ν$ überein.}} | + | *Das bedeutet auch: Bei Ergodizität stimmen die Zeitmittelwerte einer jeden Musterfunktion mit den entsprechenden Scharmittelwerten zu beliebigen Zeitpunkten $ν$ überein.}} |

[[Datei:Sto_T_4_4_S3.png|450px |right|frame|450px| Zur Definition ergodischer Zufallsprozesse]] | [[Datei:Sto_T_4_4_S3.png|450px |right|frame|450px| Zur Definition ergodischer Zufallsprozesse]] | ||

| − | Beispielsweise gilt bei Ergodizität für das Moment $k$-ter Ordnung: | + | Beispielsweise gilt bei Ergodizität für das Moment $k$-ter Ordnung: |

:$$m_k=\overline{x^k(t)}={\rm E}\big[x^k\big].$$ | :$$m_k=\overline{x^k(t)}={\rm E}\big[x^k\big].$$ | ||

| − | Die überstreichende Linie kennzeichnet hierbei den Zeitmittelwert, während der Scharmittelwert durch Erwartungswertswertbildung $\rm E\big[ \hspace{0.1cm}\text{...} \hspace{0.1cm} \big]$ zu ermitteln ist, wie im Kapitel [[Stochastische_Signaltheorie/Momente_einer_diskreten_Zufallsgröße|Momente einer diskreten Zufallsgröße]] beschrieben. | + | Die überstreichende Linie kennzeichnet hierbei den Zeitmittelwert, während der Scharmittelwert durch Erwartungswertswertbildung $\rm E\big[ \hspace{0.1cm}\text{...} \hspace{0.1cm} \big]$ zu ermitteln ist, wie im Kapitel [[Stochastische_Signaltheorie/Momente_einer_diskreten_Zufallsgröße|Momente einer diskreten Zufallsgröße]] beschrieben. |

| − | + | $\text{Anmerkung:}$ Die Ergodizität lässt sich aus einer endlichen Anzahl von Musterfunktionen und endlichen Signalausschnitten nicht nachweisen. | |

*Allerdings wird in den meisten Anwendungen zwar hypothetisch – aber trotzdem durchaus berechtigt – von Ergodizität ausgegangen. | *Allerdings wird in den meisten Anwendungen zwar hypothetisch – aber trotzdem durchaus berechtigt – von Ergodizität ausgegangen. | ||

| − | *Anhand der gefundenen Ergebnisse muss anschließend die Plausibilität dieser ''Ergodizitätshypothese'' überprüft werden. | + | *Anhand der gefundenen Ergebnisse muss anschließend die Plausibilität dieser '''Ergodizitätshypothese''' überprüft werden. |

<br clear=all> | <br clear=all> | ||

==Allgemeingültige Beschreibung von Zufallsprozessen== | ==Allgemeingültige Beschreibung von Zufallsprozessen== | ||

<br> | <br> | ||

| − | Ist der zu analysierende Zufallsprozess $\{x_i(t)\}$ nicht stationär und damit mit Sicherheit auch nicht ergodisch, so müssen die Momente stets als Scharmittelwerte bestimmt werden. Im Allgemeinen sind diese zeitabhängig: | + | Ist der zu analysierende Zufallsprozess $\{x_i(t)\}$ nicht stationär und damit mit Sicherheit auch nicht ergodisch, so müssen die Momente stets als Scharmittelwerte bestimmt werden. |

| + | *Im Allgemeinen sind diese zeitabhängig: | ||

:$$m_k(t_1) \ne m_k(t_2).$$ | :$$m_k(t_1) \ne m_k(t_2).$$ | ||

| − | Da durch die Momente aber auch die [[Stochastische_Signaltheorie/Erwartungswerte_und_Momente#Charakteristische_Funktion|charakteristische Funktion]] (Fourierrücktransformierte der WDF) | + | *Da durch die Momente aber auch die [[Stochastische_Signaltheorie/Erwartungswerte_und_Momente#Charakteristische_Funktion|charakteristische Funktion]] (Fourierrücktransformierte der WDF) |

:$$ C_x(\Omega) ={\rm\sum^{\infty}_{{\it k}=0}}\ \frac{m_k}{k!}\cdot \Omega^{k}\ \circ\!\!-\!\!\!-\!\!\!-\!\!\bullet\,\ f_{x}(x)$$ | :$$ C_x(\Omega) ={\rm\sum^{\infty}_{{\it k}=0}}\ \frac{m_k}{k!}\cdot \Omega^{k}\ \circ\!\!-\!\!\!-\!\!\!-\!\!\bullet\,\ f_{x}(x)$$ | ||

| − | festliegt, ist die Wahrscheinlichkeitsdichtefunktion $f_{x}(x)$ ebenfalls zeitabhängig. | + | festliegt, ist die Wahrscheinlichkeitsdichtefunktion $f_{x}(x)$ ebenfalls zeitabhängig. |

| − | + | *Sollen nicht nur die Amplitudenverteilungen zu verschiedenen Zeitpunkten $t_1, t_2$, ... ermittelt werden, sondern auch die statistischen Bindungen zwischen den Signalwerten zu diesen Zeiten, so muss man auf die [[Stochastische_Signaltheorie/Zweidimensionale_Zufallsgrößen#Verbundwahrscheinlichkeitsdichtefunktion|zweidimensionale Verbundwahrscheinlichkeitsdichtefunktion]] übergehen. | |

| − | Sollen nicht nur die Amplitudenverteilungen zu verschiedenen Zeitpunkten $t_1, t_2$, ... ermittelt werden, sondern auch die statistischen Bindungen zwischen den Signalwerten zu diesen Zeiten, so muss man auf die [[Stochastische_Signaltheorie/Zweidimensionale_Zufallsgrößen#Verbundwahrscheinlichkeitsdichtefunktion| | ||

| − | Betrachtet man beispielsweise die beiden Zeitpunkte $t_1$ und $t_2$, so ist folgendes zu vermerken: | + | Betrachtet man beispielsweise die beiden Zeitpunkte $t_1$ und $t_2$, so ist folgendes zu vermerken: |

| − | + | #Die 2D-WDF ergibt sich entsprechend den Angaben auf der Seite [[Stochastische_Signaltheorie/Zweidimensionale_Zufallsgrößen#Eigenschaften_und_Beispiele|Eigenschaften und Beispiele zweidimensionaler Zufallsgrößen]] mit $x = x(t_1)$ und $y = x(t_2)$. Es ist offensichtlich, dass bereits die Ermittlung dieser Größe sehr aufwändig ist. | |

| − | + | #Berücksichtigt man weiter, dass zur Erfassung aller statistischen Bindungen innerhalb des Zufallsprozesses eigentlich die $n$-dimensionale Verbundwahrscheinlichkeitsdichtefunktion herangezogen werden müsste, wobei möglichst noch der Grenzwert $n → ∞$ zu bilden ist, so erkennt man die Schwierigkeiten für die Lösung praktischer Probleme. | |

| − | + | #Aus diesen Gründen geht man zur Beschreibung der statistischen Bindungen eines Zufallsprozesses auf die Autokorrelationsfunktion über, die das Problem vereinfacht. Diese wird im folgenden Abschnitt zunächst für den allgemeinen Fall definiert. | |

==Allgemeine Definition der Autokorrelationsfunktion== | ==Allgemeine Definition der Autokorrelationsfunktion== | ||

<br> | <br> | ||

{{BlaueBox|TEXT= | {{BlaueBox|TEXT= | ||

| − | $\text{Allgemeingültige Definition:}$ | + | $\text{Allgemeingültige Definition:}$ |

| − | |||

| − | |||

| + | Die '''Autokorrelationsfunktion''' $\rm (AKF)$ eines Zufallsprozesses $\{x_i(t)\}$ ist gleich dem Erwartungswert des Produkts der Signalwerte zu zwei Zeitpunkten $t_1$ und $t_2$: | ||

| + | :$$\varphi_x(t_1,t_2)={\rm E}\big[x(t_{\rm 1})\cdot x(t_{\rm 2})\big].$$ | ||

| + | Diese Definition gilt unabhängig davon, ob der Zufallsprozess ergodisch oder nichtergodisch ist, und sie gilt im Prinzip auch für nicht-stationäre Prozesse. }} | ||

| − | + | :Hinweis zur Nomenklatur: | |

| − | Um den Zusammenhang mit der [[Stochastische_Signaltheorie/Kreuzkorrelationsfunktion_und_Kreuzleistungsdichte|Kreuzkorrelationsfunktion]] $φ_{xy}$ zwischen den beiden statistischen Größen $x$ und $y$ deutlich zu machen, wird in mancher Literatur für die Autokorrelationsfunktion anstelle von $φ_{x}$ auch häufig die Schreibweise $φ_{xx}$ verwendet. In unserem Lerntutorial verzichten wir darauf. | + | :Um den Zusammenhang mit der [[Stochastische_Signaltheorie/Kreuzkorrelationsfunktion_und_Kreuzleistungsdichte|Kreuzkorrelationsfunktion]] $φ_{xy}$ zwischen den beiden statistischen Größen $x$ und $y$ deutlich zu machen, wird in mancher Literatur für die Autokorrelationsfunktion anstelle von $φ_{x}$ auch häufig die Schreibweise $φ_{xx}$ verwendet. In unserem Lerntutorial verzichten wir darauf. |

| − | Ein Vergleich mit dem Abschnitt [[Stochastische_Signaltheorie/Zweidimensionale_Zufallsgrößen#Erwartungswerte_zweidimensionaler_Zufallsgr.C3.B6.C3.9Fen|Erwartungswerte zweidimensionaler Zufallsgrößen]] zeigt, dass der AKF–Wert $φ_x(t_1, t_2)$ das gemeinsame Moment $m_{11}$ zwischen den beiden Zufallsgrößen $x(t_1)$ und $x(t_2)$ angibt. | + | Ein Vergleich mit dem Abschnitt [[Stochastische_Signaltheorie/Zweidimensionale_Zufallsgrößen#Erwartungswerte_zweidimensionaler_Zufallsgr.C3.B6.C3.9Fen|Erwartungswerte zweidimensionaler Zufallsgrößen]] zeigt, dass der AKF–Wert $φ_x(t_1, t_2)$ das gemeinsame Moment $m_{11}$ zwischen den beiden Zufallsgrößen $x(t_1)$ und $x(t_2)$ angibt. |

| − | Während für exakte Aussagen hinsichtlich der statistischen Bindungen eines Zufallsprozesses eigentlich die $n$–dimensionale Verbunddichte (mit $n → ∞$ | + | Während für exakte Aussagen hinsichtlich der statistischen Bindungen eines Zufallsprozesses eigentlich die $n$–dimensionale Verbunddichte $($mit $n → ∞)$ benötigt wird, werden durch den Übergang auf die Autokorrelationsfunktion implizit folgende Vereinfachungen getroffen: |

| − | + | #Anstelle von unendlich vielen Zeitpunkten werden hier nur zwei betrachtet, und anstelle aller Momente $m_{\hspace{0.05cm}k\hspace{0.05cm}l}$ zu den beiden Zeitpunkten $t_1$ und $t_2$ mit $k, \ l ∈ \{1, 2, 3, \text{...} \}$ wird hier nur das gemeinsame Moment $m_{11}$ erfasst. | |

| − | + | #Das Moment $m_{11}$ gibt ausschließlich die lineare Abhängigkeit („Korrelation”) des Prozesses wieder. Alle statistische Bindungen höherer Ordnung werden dagegen nicht berücksichtigt. | |

| − | + | #Deshalb sollte bei der Bewertung von Zufallsprozessen mittels AKF stets berücksichtigt werden, dass diese nur sehr beschränkte Aussagen über die statistischen Bindungen allgemein erlaubt. | |

{{GraueBox|TEXT= | {{GraueBox|TEXT= | ||

| − | $\text{Beispiel 3:}$ Die obige Definition der Autokorrelationsfunktion gilt allgemein, also auch für | + | $\text{Beispiel 3:}$ Die obige Definition der Autokorrelationsfunktion gilt allgemein, also auch für nicht-stationäre und nicht-ergodische Prozesse. |

| − | *Ein Beispiel eines nichtstationären Vorgangs ist das Auftreten von Impulsstörungen im Fernsprechnetz, verursacht durch Wählimpulse in benachbarten Leitungen. | + | *Ein Beispiel eines nichtstationären Vorgangs ist das Auftreten von Impulsstörungen im Fernsprechnetz, verursacht durch Wählimpulse in benachbarten Leitungen. |

| − | *Bei Digitalsignalübertragung führen solche | + | *Bei Digitalsignalübertragung führen solche nicht-stationären Störprozesse meist zu Bündelfehlern.}} |

| − | ==Autokorrelationsfunktion bei ergodischen Prozessen== | + | ==Autokorrelationsfunktion bei stationären und ergodischen Prozessen== |

<br> | <br> | ||

[[Datei:Sto_T_4_4_S6.png |400px |right|frame| Zur Autokorrelationsfunktion bei ergodischen Prozessen]] | [[Datei:Sto_T_4_4_S6.png |400px |right|frame| Zur Autokorrelationsfunktion bei ergodischen Prozessen]] | ||

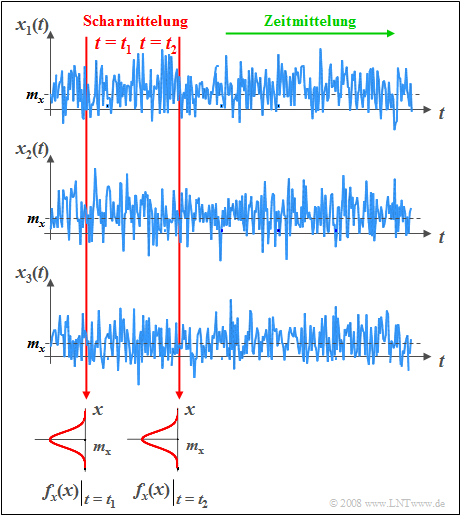

Im Folgenden beschränken wir uns auf stationäre und ergodische Prozesse. | Im Folgenden beschränken wir uns auf stationäre und ergodische Prozesse. | ||

| − | Ein solcher | + | Ein solcher Zufallsprozess $\{x_i(t)\}$ wird zum Beispiel bei der Untersuchung von [[Aufgaben:Aufgabe_1.3Z:_Thermisches_Rauschen|Thermischem Rauschen]] zugrunde gelegt. Dabei wird von der Vorstellung ausgegangen, dass |

| − | *beliebig viele, in ihren physikalischen und statistischen Eigenschaften völlig gleiche Widerstände vorhanden sind, | + | *beliebig viele, in ihren physikalischen und statistischen Eigenschaften völlig gleiche Widerstände vorhanden sind, |

| − | *von denen jeder ein anderes Zufallssignal $x_i(t)$ abgibt. | + | *von denen jeder ein anderes Zufallssignal $x_i(t)$ abgibt. |

Die Grafik zeigt einen solchen stationären und ergodischen Prozess: | Die Grafik zeigt einen solchen stationären und ergodischen Prozess: | ||

| − | + | #Die einzelnen Musterfunktionen $x_i(t)$ können zu allen beliebigen Zeiten alle beliebigen Werte annehmen. Das bedeutet, dass der hier betrachtete Zufallsprozess $\{x_i(t)\}$ sowohl wert– als auch zeitkontinuierlich ist. | |

| − | + | #Auch wenn über die tatsächlichen Signalwerte der einzelnen Musterfunktionen aufgrund der Stochastik keine Aussagen getroffen werden können, so sind die Momente und die WDF zu allen Zeitpunkten gleich. | |

| − | + | #In der Grafik ist aus Gründen einer verallgemeinerten Darstellung auch ein Gleichanteil $m_x$ berücksichtigt, der bei Thermischem Rauschen allerdings nicht vorhanden ist. | |

| − | |||

| − | |||

| − | |||

| − | |||

<br clear=all> | <br clear=all> | ||

{{BlaueBox|TEXT= | {{BlaueBox|TEXT= | ||

| − | $\text{Definition:}$ Man spricht von einem '''stationären Zufallsprozess''' $\{x_i(t)\}$, wenn seine statistischen Eigenschaften invariant gegenüber Zeitverschiebungen sind. | + | $\text{Definition:}$ Man spricht von einem '''stationären Zufallsprozess''' $\{x_i(t)\}$, wenn seine statistischen Eigenschaften invariant gegenüber Zeitverschiebungen sind. |

| − | *Für die Autokorrelationsfunktion (AKF) bedeutet diese Aussage, dass sie nicht mehr eine Funktion der beiden unabhängigen Zeitvariablen $t_1$ und $t_2$ ist, sondern nur noch von der Zeitdifferenz $τ = t_2 - t_1$ abhängt: | + | *Für die Autokorrelationsfunktion $\rm (AKF)$ bedeutet diese Aussage, dass sie nicht mehr eine Funktion der beiden unabhängigen Zeitvariablen $t_1$ und $t_2$ ist, sondern nur noch von der Zeitdifferenz $τ = t_2 - t_1$ abhängt: |

:$$\varphi_x(t_1,t_2)\rightarrow{\varphi_x(\tau)={\rm E}\big[x(t)\cdot x(t+\tau)\big]}.$$ | :$$\varphi_x(t_1,t_2)\rightarrow{\varphi_x(\tau)={\rm E}\big[x(t)\cdot x(t+\tau)\big]}.$$ | ||

| − | *Die Scharmittelung kann dabei zu jeder beliebigen Zeit $t$ erfolgen. }} | + | *Die Scharmittelung kann dabei zu jeder beliebigen Zeit $t$ erfolgen. }} |

| − | Unter der weiteren Annahme | + | #Unter der weiteren Annahme von Ergodizität können alle Momente auch durch Zeitmittelung über eine einzige ausgewählte Musterfunktion $x(t)$ ermittelt werden. |

| + | #Alle diese Zeitmittelwerte stimmen in diesem Sonderfall mit den entsprechenden Scharmittelwerten überein. | ||

| + | |||

{{BlaueBox|TEXT= | {{BlaueBox|TEXT= | ||

| − | $\text{Definition:}$ Damit folgt für die '''AKF eines ergodischen Zufallsprozesses''', dessen Mustersignale jeweils von $–∞$ bis $+∞$ reichen | + | $\text{Definition:}$ Damit folgt für die '''AKF eines ergodischen Zufallsprozesses''', dessen Mustersignale jeweils von $–∞$ bis $+∞$ reichen: |

:$$\varphi_x(\tau)=\overline{x(t)\cdot x(t+\tau)}=\lim_{T_{\rm M}\to\infty}\,\frac{1}{T_{\rm M} }\cdot\int^{T_{\rm M}/{\rm 2} }_{-T_{\rm M}/{\rm 2} }x(t)\cdot x(t+\tau)\,\,{\rm d}t.$$ | :$$\varphi_x(\tau)=\overline{x(t)\cdot x(t+\tau)}=\lim_{T_{\rm M}\to\infty}\,\frac{1}{T_{\rm M} }\cdot\int^{T_{\rm M}/{\rm 2} }_{-T_{\rm M}/{\rm 2} }x(t)\cdot x(t+\tau)\,\,{\rm d}t.$$ | ||

| − | Die überstreichende Linie kennzeichnet die Zeitmittelung über das unendlich ausgedehnte Zeitintervall. }} | + | *Die überstreichende Linie kennzeichnet die Zeitmittelung über das unendlich ausgedehnte Zeitintervall. |

| + | *$T_{\rm M}$ bezeichnet die Messdauer.}} | ||

| − | Bei periodischen Signalen kann man auf den Grenzübergang verzichten, so dass in diesem Sonderfall die Autokorrelationsfunktion mit der Periodendauer $T_0$ auch in folgender Weise geschrieben werden kann: | + | Bei periodischen Signalen kann man auf den Grenzübergang verzichten, so dass in diesem Sonderfall die Autokorrelationsfunktion mit der Periodendauer $T_0$ auch in folgender Weise geschrieben werden kann: |

:$$\varphi_x(\tau)=\frac{1}{T_{\rm 0}}\cdot\int^{T_{\rm 0}/2}_{-T_{\rm 0}/2}x(t)\cdot x(t+\tau)\,\,{\rm d}t=\frac{1}{T_{\rm 0}}\cdot\int^{T_{\rm 0}}_{\rm 0}x(t)\cdot x(t+\tau)\,\,{\rm d}t .$$ | :$$\varphi_x(\tau)=\frac{1}{T_{\rm 0}}\cdot\int^{T_{\rm 0}/2}_{-T_{\rm 0}/2}x(t)\cdot x(t+\tau)\,\,{\rm d}t=\frac{1}{T_{\rm 0}}\cdot\int^{T_{\rm 0}}_{\rm 0}x(t)\cdot x(t+\tau)\,\,{\rm d}t .$$ | ||

| − | Wichtig ist nur, dass insgesamt genau über eine Periodendauer $T_0$ (oder Vielfache davon) gemittelt wird. Egal ist, welchen Zeitausschnitt man verwendet. | + | Wichtig ist nur, dass insgesamt genau über eine Periodendauer $T_0$ (oder Vielfache davon) gemittelt wird. Egal ist, welchen Zeitausschnitt man verwendet. |

==Eigenschaften der Autokorrelationsfunktion== | ==Eigenschaften der Autokorrelationsfunktion== | ||

<br> | <br> | ||

| − | Hier werden wichtige Eigenschaften der Autokorrelationsfunktion (AKF) zusammengestellt, wobei wir von der ergodischen AKF–Form $φ_x(τ)$ ausgehen: | + | Hier werden wichtige Eigenschaften der Autokorrelationsfunktion (AKF) zusammengestellt, wobei wir von der ergodischen AKF–Form $φ_x(τ)$ ausgehen: |

| − | *Ist der betrachtete Zufallsprozess reell, so gilt dies auch für seine Autokorrelationsfunktion. | + | *Ist der betrachtete Zufallsprozess reell, so gilt dies auch für seine Autokorrelationsfunktion. |

| − | *Die AKF besitzt die Einheit einer Leistung, zum Beispiel „Watt” $\rm (W)$. Häufig bezieht man diese auf den Widerstand $1\hspace{0.03cm} Ω$; | + | *Die AKF besitzt die Einheit einer Leistung, zum Beispiel „Watt” $\rm (W)$. Häufig bezieht man diese auf den Widerstand $1\hspace{0.03cm} Ω$; $φ_x(τ)$ hat dann die Einheit $\rm V^2$ bzw. $\rm A^2$. |

*Die AKF ist immer eine gerade Funktion ⇒ $φ_x(–τ) = φ_x(τ)$. Alle Phasenbeziehungen des Zufallsprozesses gehen in der AKF verloren. | *Die AKF ist immer eine gerade Funktion ⇒ $φ_x(–τ) = φ_x(τ)$. Alle Phasenbeziehungen des Zufallsprozesses gehen in der AKF verloren. | ||

| − | *Die AKF an der Stelle $τ =$ | + | *Die AKF an der Stelle $τ = 0$ gibt das Moment zweiter Ordnung $(m_2)$ und damit die gesamte Signalleistung (Gleich– und Wechselanteil) an: |

:$$\varphi_x(\tau = 0)= m_2=\overline{ x^2(t)}.$$ | :$$\varphi_x(\tau = 0)= m_2=\overline{ x^2(t)}.$$ | ||

| − | *Das AKF–Maximum tritt stets bei $τ = 0$ auf, und es gilt: $|φ_x(τ)| ≤ φ_x(0)$. Bei nichtperiodischen Prozessen ist für $τ ≠ 0$ der Betrag $|φ_x(τ)|$ stets kleiner als $φ_x(\tau =0)$ ⇒ Leistung des Zufallsprozesses. | + | *Das AKF–Maximum tritt stets bei $τ = 0$ auf, und es gilt: $|φ_x(τ)| ≤ φ_x(0)$. Bei nichtperiodischen Prozessen ist für $τ ≠ 0$ der Betrag $|φ_x(τ)|$ stets kleiner als $φ_x(\tau =0)$ ⇒ Leistung des Zufallsprozesses. |

| − | *Bei einem periodischen Zufallsprozess weist die AKF die gleiche Periodendauer $T_0$ wie die einzelnen Mustersignale $x_i(t)$ auf: | + | *Bei einem periodischen Zufallsprozess weist die AKF die gleiche Periodendauer $T_0$ wie die einzelnen Mustersignale $x_i(t)$ auf: |

:$$\varphi_x(\pm{T_0})=\varphi_x(\pm{2\cdot T_0})= \hspace{0.1cm}\text{...} \hspace{0.1cm}= \varphi_x(0).$$ | :$$\varphi_x(\pm{T_0})=\varphi_x(\pm{2\cdot T_0})= \hspace{0.1cm}\text{...} \hspace{0.1cm}= \varphi_x(0).$$ | ||

| − | *Der Gleichanteil $m_1$ eines nichtperiodischen Signals kann aus dem Grenzwert der | + | *Der Gleichanteil $m_1$ eines nichtperiodischen Signals kann aus dem Grenzwert der Autokorrelationsfunktion für $τ → ∞$ berechnet werden. Hierbei gilt: |

:$$\lim_{\tau\to\infty}\,\varphi_x(\tau)= m_1^2=\big [\overline{ x(t)}\big]^2.$$ | :$$\lim_{\tau\to\infty}\,\varphi_x(\tau)= m_1^2=\big [\overline{ x(t)}\big]^2.$$ | ||

| − | *Dagegen schwankt bei Signalen mit periodischen Anteilen der Grenzwert der AKF für $τ → ∞$ um diesen Endwert (Quadrat des Gleichanteils). | + | *Dagegen schwankt bei Signalen mit periodischen Anteilen der Grenzwert der AKF für $τ → ∞$ um diesen Endwert (Quadrat des Gleichanteils). |

==Interpretation der Autokorrelationsfunktion== | ==Interpretation der Autokorrelationsfunktion== | ||

<br> | <br> | ||

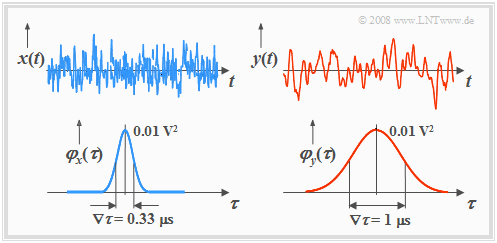

| − | Die Grafik zeigt oben je ein Mustersignal zweier Zufallsprozesse $\{x_i(t)\}$ und $\{y_i(t)\}$, unten die zugehörigen Autokorrelationsfunktionen. | + | Die Grafik zeigt oben je ein Mustersignal zweier Zufallsprozesse $\{x_i(t)\}$ und $\{y_i(t)\}$, unten die zugehörigen Autokorrelationsfunktionen. |

[[Datei: P_ID373__Sto_T_4_4_S8_neu.png |right|frame| AKF von hochfrequenten und niederfrequenten Prozessen]] | [[Datei: P_ID373__Sto_T_4_4_S8_neu.png |right|frame| AKF von hochfrequenten und niederfrequenten Prozessen]] | ||

Anhand dieser Darstellungen sind folgende Aussagen möglich: | Anhand dieser Darstellungen sind folgende Aussagen möglich: | ||

| − | *$\{y_i(t)\}$ hat stärkere innere statistische Bindungen als $\{x_i(t)\}$. Spektral gesehen ist der Prozess $\{y_i(t)\}$ also niederfrequenter. | + | *$\{y_i(t)\}$ hat stärkere innere statistische Bindungen als $\{x_i(t)\}$. Spektral gesehen ist der Prozess $\{y_i(t)\}$ also niederfrequenter. |

| − | *Die Mustersignale $x(t)$ und $y(t)$ lassen bereits vermuten, dass beide Prozesse mittelwertfrei sind und den gleichen Effektivwert aufweisen. | + | *Die skizzierten Mustersignale $x(t)$ und $y(t)$ lassen bereits vermuten, dass beide Prozesse mittelwertfrei sind und den gleichen Effektivwert aufweisen. |

| − | * | + | *Die obigen Autokorrelationsfunktionen bestätigen diese Aussagen. Die liearen Mittelwerte $m_x = m_y = 0$ ergeben sich jeweils aus dem AKF–Grenzwert für $τ → ∞$. |

| − | *Wegen $m_x = 0$ gilt für die Varianz: $σ_x^2 = φ_x(0) = 0.01 \hspace{0.05cm} \rm V^2$, und der Effektivwert ist $σ_x = 0.1 \hspace{0.05cm}\rm V$. | + | *Wegen $m_x = 0$ gilt hier für die Varianz: $σ_x^2 = φ_x(0) = 0.01 \hspace{0.05cm} \rm V^2$, und der Effektivwert ist demzufolge $σ_x = 0.1 \hspace{0.05cm}\rm V$. |

| − | * | + | *$y(t)$ hat die gleiche Varianz und und den gleichen Effektivwert wie $x(t)$. Die AKF–Werte fallen um so langsamer ab, je stärker die inneren statistischen Bindungen sind. |

| − | *Das Signal $x(t)$ mit schmaler AKF ändert sich zeitlich sehr schnell, während beim niederfrequenteren Signal $y(t)$ die statistischen Bindungen deutlich weiter reichen. | + | *Das Signal $x(t)$ mit schmaler AKF ändert sich zeitlich sehr schnell, während beim niederfrequenteren Signal $y(t)$ die statistischen Bindungen deutlich weiter reichen. |

| − | *Das bedeutet aber auch, dass der Signalwert $y(t + τ)$ aus $y(t)$ besser vorhergesagt werden kann als $x(t + τ)$ aus $x(t)$. | + | *Das bedeutet aber auch, dass der Signalwert $y(t + τ)$ aus $y(t)$ besser vorhergesagt werden kann als $x(t + τ)$ aus $x(t)$. |

{{BlaueBox|TEXT= | {{BlaueBox|TEXT= | ||

| − | $\text{Definition:}$ Eine quantitative Kenngröße für die Stärke der statistischen Bindungen ist die '''äquivalente AKF-Dauer''' $∇τ$ (man spricht „Nabla–tau”), die sich aus der AKF über das flächengleiche Rechteck ermitteln lässt: | + | $\text{Definition:}$ Eine quantitative Kenngröße für die Stärke der statistischen Bindungen ist die '''äquivalente AKF-Dauer''' $∇τ$ (man spricht „Nabla–tau”), die sich aus der AKF über das flächengleiche Rechteck ermitteln lässt: |

| − | :$${ {\rm \nabla} }\tau =\frac{1}{\varphi_x(0)}\cdot\int^{\infty}_{-\infty}\ \varphi_x(\tau)\,\,{\rm d}\tau. $$ | + | :$${ {\rm \nabla} }\tau =\frac{1}{\varphi_x(0)}\cdot\int^{\infty}_{-\infty}\ \varphi_x(\tau)\,\,{\rm d}\tau. $$}} |

| − | |||

| − | Als ein weiteres Maß für die Stärke der statistischen Bindungen wird in der Literatur häufig die [[Digitalsignalübertragung/Bündelfehlerkanäle#Fehlerkorrelationsfunktion_des_GE.E2.80.93Modells|Korrelationsdauer]] $T_{\rm K}$ verwendet. Diese gibt die Zeitdauer an, bei der die | + | *Bei den hier betrachteten Prozessen (mit gaußähnlicher AKF) gilt entsprechend obiger Skizze: $∇τ_x = 0.33 \hspace{0.05cm} \rm µ s$ bzw. $∇τ_y = 1 \hspace{0.05cm} \rm µs$. |

| + | *Als ein weiteres Maß für die Stärke der statistischen Bindungen wird in der Literatur häufig die [[Digitalsignalübertragung/Bündelfehlerkanäle#Fehlerkorrelationsfunktion_des_GE.E2.80.93Modells|Korrelationsdauer]] $T_{\rm K}$ verwendet. | ||

| + | *Diese gibt die Zeitdauer an, bei der die Autokorrelationsfunktion auf die Häfte ihres Maximalwertes abgefallen ist. | ||

==Numerische AKF-Ermittlung== | ==Numerische AKF-Ermittlung== | ||

<br> | <br> | ||

| − | Bisher haben wir stets zeitkontinuierliche Signale $x(t)$ betrachtet, die für die Darstellung und Simulation mittels Digitalrechner ungeeignet sind. Hierzu ist vielmehr eine zeitdiskrete Signaldarstellung $〈x_ν〉$ erforderlich, wie im Kapitel [[Signaldarstellung/Zeitdiskrete_Signaldarstellung|Zeitdiskrete Signaldarstellung]] unseres ersten Buches dargelegt. | + | Bisher haben wir stets zeitkontinuierliche Signale $x(t)$ betrachtet, die für die Darstellung und Simulation mittels Digitalrechner ungeeignet sind. Hierzu ist vielmehr eine zeitdiskrete Signaldarstellung $〈x_ν〉$ erforderlich, wie im Kapitel [[Signaldarstellung/Zeitdiskrete_Signaldarstellung|Zeitdiskrete Signaldarstellung]] unseres ersten Buches dargelegt. |

Hier eine kurze Zusammenfassung: | Hier eine kurze Zusammenfassung: | ||

| − | *Das zeitdiskrete Signal $〈x_ν〉$ ist die Folge der Abtastwerte $x_ν = x(ν · T_{\rm A}).$ Das zeitkontinuierliche Signal $x(t)$ wird durch die Folge $〈x_ν〉$ vollständig beschrieben, wenn das Abtasttheorem erfüllt ist: | + | *Das zeitdiskrete Signal $〈x_ν〉$ ist die Folge der Abtastwerte $x_ν = x(ν · T_{\rm A}).$ |

| + | *Das zeitkontinuierliche Signal $x(t)$ wird durch die Folge $〈x_ν〉$ vollständig beschrieben, wenn das Abtasttheorem erfüllt ist: | ||

:$$T_{\rm A} \le \frac{1}{2 \cdot B_x}.$$ | :$$T_{\rm A} \le \frac{1}{2 \cdot B_x}.$$ | ||

| − | *$B_x$ bezeichnet die absolute (einseitige) Bandbreite des Analogsignals $x(t)$. Diese sagt aus, dass die Spektralfunktion $X(f)$ für alle Frequenzen $| f | > B_x$ | + | *$B_x$ bezeichnet die absolute (einseitige) Bandbreite des Analogsignals $x(t)$. Diese sagt aus, dass die Spektralfunktion $X(f)$ für alle Frequenzen $| f | > B_x$ Null ist. |

| − | + | {{GraueBox|TEXT= | |

| − | |||

| − | {{GraueBox|TEXT= | ||

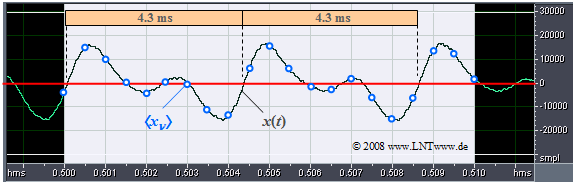

$\text{Beispiel 4:}$ | $\text{Beispiel 4:}$ | ||

| − | Das Bild zeigt einen Ausschnitt eines Audiosignals der Dauer 10 Millisekunden. | + | Das Bild zeigt einen Ausschnitt eines Audiosignals der Dauer $10$ Millisekunden. |

| − | + | [[Datei:P_ID638__Sto_T_4_4_S9_ganz_neu.png |frame| Abtastung eines Audiosignals]] | |

| − | Obwohl das gesamte Signal ein breites Spektrum mit der Mittenfrequenz bei etwa $500 \hspace{0.05cm} \rm Hz$ besitzt, ist | + | Obwohl das gesamte Signal ein breites Spektrum mit der Mittenfrequenz bei etwa $500 \hspace{0.05cm} \rm Hz$ besitzt, ist im betrachteten (kurzen) Zeitintervall ein (nahezu) periodisches Signal mit etwa der Periodendauer $T_0 = 4.3 \hspace{0.05cm} \rm ms$ zu erkennen. Daraus ergibt sich die Grundfrequenz zu |

| + | :$$f_0 = 1/T_0 \approx 230 \hspace{0.05cm} \rm Hz.$$ | ||

| − | Blau eingezeichnet sind die Abtastwerte im Abstand $T_{\rm A} = 0.5 \hspace{0.05cm} \rm ms$. | + | Blau eingezeichnet sind die Abtastwerte im Abstand $T_{\rm A} = 0.5 \hspace{0.05cm} \rm ms$. |

| − | *Diese Folge $〈x_ν〉$ von Abtastwerten würde allerdings nur dann die gesamte Information über das Analogsignal $x(t)$ beinhalten, wenn dieses auf den Frequenzbereich bis $1 \hspace{0.05cm} \rm kHz$ begrenzt wäre. | + | *Diese Folge $〈x_ν〉$ von Abtastwerten würde allerdings nur dann die gesamte Information über das Analogsignal $x(t)$ beinhalten, wenn dieses auf den Frequenzbereich bis $1 \hspace{0.05cm} \rm kHz$ begrenzt wäre. |

| − | *Sind im Signal $x(t)$ höhere Frequenzanteile enthalten, so muss $T_{\rm A}$ entsprechend kleiner gewählt werden.}} | + | *Sind im Signal $x(t)$ höhere Frequenzanteile enthalten, so muss $T_{\rm A}$ entsprechend kleiner gewählt werden.}} |

{{BlaueBox|TEXT= | {{BlaueBox|TEXT= | ||

$\text{Fazit:}$ | $\text{Fazit:}$ | ||

| − | + | # Liegen die Signalwerte nur zu diskreten Zeitpunkten $($bei Vielfachen von $T_{\rm A})$ vor, so kann man auch die Autokorrelationsfunktion nur zu ganzzahligen Vielfachen von $T_{\rm A}$ bestimmen. | |

| − | * | + | # Die AKF–Berechnung lässt sich somit wie folgt dargestellen (die überstreichende Linie kennzeichnet wieder die Zeitmittelung): |

| − | + | :$$\varphi_k = \overline {x_\nu \cdot x_{\nu + k} }$$ | |

| − | + | :*mit den zeitdiskreten Signalwerten $x_ν = x(ν · T_{\rm A})$ und $x_{ν+k} = x((ν+k) · T_{\rm A})$ | |

| + | :*sowie der zeitdiskreten AKF $φ_k = φ_x(k · T_{\rm A})$.}} | ||

| − | Wir stellen uns nun die Aufgabe, die AKF-Stützstellen $φ_0, \hspace{0.1cm}\text{...}\hspace{0.1cm} , φ_l$ aus $N$ Abtastwerten $(x_1, \hspace{0.1cm}\text{...}\hspace{0.1cm} , x_N)$ zu ermitteln, wobei der Parameter $l \ll N$ vorausgesetzt wird. | + | Wir stellen uns nun die Aufgabe, die AKF-Stützstellen $φ_0, \hspace{0.1cm}\text{...}\hspace{0.1cm} , φ_l$ |

| + | * aus $N$ Abtastwerten $(x_1, \hspace{0.1cm}\text{...}\hspace{0.1cm} , x_N)$ zu ermitteln, | ||

| + | *wobei der Parameter $l \ll N$ vorausgesetzt wird. | ||

| − | Die AKF-Berechnungsvorschrift lautet nun (mit $0 ≤ k ≤ l$ | + | |

| − | :$$\varphi_k = \frac{1}{N- k} \cdot \sum_{\nu = 1}^{N - | + | Beispielsweise gelte $l = 100$ und $N = 100000$. Die AKF-Berechnungsvorschrift lautet nun $($mit $0 ≤ k ≤ l)$: |

| − | Bringen wir $N - k$ auf die linke Seite, so erhalten wir daraus $l + 1$ Gleichungen, nämlich: | + | :$$\varphi_k = \frac{1}{N- k} \cdot \sum_{\nu = 1}^{N - k} x_{\nu} \cdot x_{\nu + k}.$$ |

| + | Bringen wir den Faktor $(N - k)$ auf die linke Seite, so erhalten wir daraus $l + 1$ Gleichungen, nämlich: | ||

:$$k = 0\text{:} \hspace{0.4cm}N \cdot \varphi_0 \hspace{1.03cm}=\hspace{0.1cm} x_{\rm 1} \cdot x_{\rm 1} \hspace{0.35cm}+ x_{\rm 2} \cdot x_{\rm 2} \hspace{0.3cm}+\text{ ...} \hspace{0.25cm}+x_{\nu} \cdot x_{\nu}\hspace{0.35cm}+\text{ ...} \hspace{0.05cm}+x_{N} \cdot x_{N},$$ | :$$k = 0\text{:} \hspace{0.4cm}N \cdot \varphi_0 \hspace{1.03cm}=\hspace{0.1cm} x_{\rm 1} \cdot x_{\rm 1} \hspace{0.35cm}+ x_{\rm 2} \cdot x_{\rm 2} \hspace{0.3cm}+\text{ ...} \hspace{0.25cm}+x_{\nu} \cdot x_{\nu}\hspace{0.35cm}+\text{ ...} \hspace{0.05cm}+x_{N} \cdot x_{N},$$ | ||

:$$k= 1\text{:} \hspace{0.3cm}(N-1) \cdot \varphi_1 \hspace{0.08cm}=\hspace{0.1cm} x_{\rm 1} \cdot x_{\rm 2} \hspace{0.4cm}+ x_{\rm 2} \cdot x_{\rm 3} \hspace{0.3cm}+ \text{ ...} \hspace{0.18cm}+x_{\nu} \cdot x_{\nu + 1}\hspace{0.01cm}+\text{ ...}\hspace{0.08cm}+x_{N-1} \cdot x_{N},$$ | :$$k= 1\text{:} \hspace{0.3cm}(N-1) \cdot \varphi_1 \hspace{0.08cm}=\hspace{0.1cm} x_{\rm 1} \cdot x_{\rm 2} \hspace{0.4cm}+ x_{\rm 2} \cdot x_{\rm 3} \hspace{0.3cm}+ \text{ ...} \hspace{0.18cm}+x_{\nu} \cdot x_{\nu + 1}\hspace{0.01cm}+\text{ ...}\hspace{0.08cm}+x_{N-1} \cdot x_{N},$$ | ||

| Zeile 256: | Zeile 260: | ||

$\text{Fazit:}$ | $\text{Fazit:}$ | ||

Nach diesem Schema ergibt sich der folgende Algorithmus: | Nach diesem Schema ergibt sich der folgende Algorithmus: | ||

| − | *Man definiert das Feld $\rm AKF\big[\hspace{0.05cm}0 : {\it l}\hspace{0.1cm}\big]$ vom Typ | + | *Man definiert das Feld $\rm AKF\big[\hspace{0.05cm}0 : {\it l}\hspace{0.1cm}\big]$ vom Typ „float” und belegt alle Elemente mit Nullen vor. |

| − | *Bei jedem Schleifendurchlauf (indiziert mit der Variablen $k$ | + | *Bei jedem Schleifendurchlauf $($indiziert mit der Variablen $k)$ werden die $l + 1$ Feldelemente ${\rm AKF}\big[\hspace{0.03cm}k\hspace{0.03cm}\big]$ jeweils um den Beitrag $x_ν · x_{ν+k}$ erhöht. |

| − | *Alle $l+1$ Feldelemente werden allerdings nur dann bearbeitet, so lange die Laufvariable $k$ nicht größer als $N - l$ ist. | + | *Alle $l+1$ Feldelemente werden allerdings nur dann bearbeitet, so lange die Laufvariable $k$ nicht größer als $N - l$ ist. |

| − | *Es ist stets zu berücksichtigen, dass $ν + k ≤ N$ gelten muss. Das bedeutet, dass die Mittelung in den unterschiedlichen Feldern $\rm AKF\big[\hspace{0.03cm}0\hspace{0.03cm}\big]$ ... $\rm AKF\big[\hspace{0.03cm}l\hspace{0.03cm}\big]$ über eine unterschiedliche Anzahl von Summanden | + | *Es ist stets zu berücksichtigen, dass $ν + k ≤ N$ gelten muss. Das bedeutet, dass die Mittelung in den unterschiedlichen Feldern $\rm AKF\big[\hspace{0.03cm}0\hspace{0.03cm}\big]$ ... ${\rm AKF}\big[\hspace{0.03cm}l\hspace{0.03cm}\big]$ über eine unterschiedliche Anzahl von Summanden erfolgen muss. |

| − | *Werden am Ende der Berechnung noch die in $\rm AKF\big[\hspace{0.03cm}k\hspace{0.03cm}\big]$ gespeicherten Werte durch die Anzahl der Summanden $(N - k)$ dividiert, so enthält dieses Feld die gesuchten diskreten AKF-Werte: | + | *Werden am Ende der Berechnung noch die in ${\rm AKF}\big[\hspace{0.03cm}k\hspace{0.03cm}\big]$ gespeicherten Werte durch die Anzahl der Summanden $(N - k)$ dividiert, so enthält dieses Feld die gesuchten diskreten AKF-Werte: |

:$$\varphi_x(k \cdot T_A)= {\rm AKF} \big[\hspace{0.03cm}k\hspace{0.03cm}\big].$$ | :$$\varphi_x(k \cdot T_A)= {\rm AKF} \big[\hspace{0.03cm}k\hspace{0.03cm}\big].$$ | ||

| − | + | $\text{Anmerkung:}$ Bei $l \ll N$ kann man den Algorithmus vereinfachen, indem die Anzahl der Summanden für alle $k$–Werte gleich gewählt werden: | |

:$$\varphi_k = \frac{1}{N- l} \cdot \sum_{\nu = 1}^{N - l} x_{\nu} \cdot x_{\nu + k}.$$}} | :$$\varphi_k = \frac{1}{N- l} \cdot \sum_{\nu = 1}^{N - l} x_{\nu} \cdot x_{\nu + k}.$$}} | ||

| Zeile 270: | Zeile 274: | ||

{{GraueBox|TEXT= | {{GraueBox|TEXT= | ||

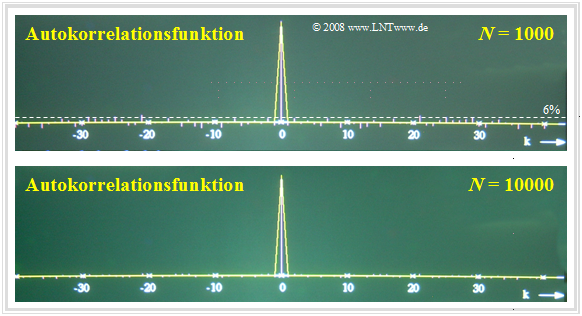

$\text{Beispiel 5:}$ | $\text{Beispiel 5:}$ | ||

| − | Der entscheidende Parameter für die Qualität der numerischen AKF–Berechnung ist die Anzahl $N$ der berücksichtigten Abtastwerte. | + | Der entscheidende Parameter für die Qualität der numerischen AKF–Berechnung ist die Anzahl $N$ der berücksichtigten Abtastwerte. |

| − | + | [[Datei:P_ID639__Sto_T_4_4_S9a_Ganz_neu.png |right|frame| AKF bei statistisch unabhängigen Abtastwerten]] | |

| − | + | ||

| + | In der oberen Grafik sehen Sie das Ergebnis der numerischen AKF-Berechnung für $N = 1000$. Die untere Grafik gilt für $N = 10000$ Abtastwerte. | ||

| + | |||

| + | *Die betrachteten Zufallsgrößen sind hier voneinander statistisch unabhängig. | ||

| + | *Somit sollten eigentlich alle AKF–Werte mit Ausnahme des Wertes bei $k = 0$ identisch Null sein. | ||

| + | |||

| + | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | * | + | *Bei $N = 10000$ (untere Grafik) beträgt der maximale Fehler nur etwa $1\%$ und ist bei dieser Darstellung fast nicht mehr sichtbar. |

| + | |||

| + | *Bei $N = 1000$ (obere Grafik) wächst der Fehler bis auf $±6\%$ an. }} | ||

<br clear = all> | <br clear = all> | ||

[[Datei:P_ID640__Sto_T_4_4_S9b_Ganz_neu.png|right|frame| AKF bei korrelierten Abtastwerten]] | [[Datei:P_ID640__Sto_T_4_4_S9b_Ganz_neu.png|right|frame| AKF bei korrelierten Abtastwerten]] | ||

{{GraueBox|TEXT= | {{GraueBox|TEXT= | ||

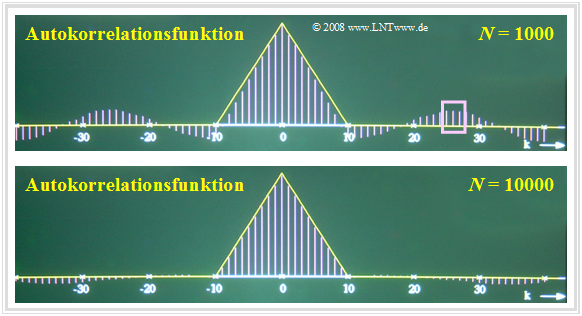

$\text{Beispiel 6:}$ | $\text{Beispiel 6:}$ | ||

| − | Die Ergebnisse ändern sich, wenn eine Zufallsgröße mit inneren statistischen Bindungen vorliegt. | + | Die Ergebnisse ändern sich, wenn eine Zufallsgröße mit inneren statistischen Bindungen vorliegt. |

| + | Betrachten wir beispielsweise eine dreieckförmige AKF mit $φ_x(k) ≠ 0$ für $\vert k \vert ≤ 10$, so erkennt man deutlich größere Abweichungen, nämlich | ||

| + | * Fehler bis zu etwa $±15\%$ bei $N = 1000$, | ||

| + | * Fehler bis zu etwa $±5\%$ bei $N = 10000$. | ||

| − | + | ||

| − | + | Begründung des schlechteren Ergebnisses gemäß $\text{Beispiel 6}$: | |

| − | + | *Aufgrund der inneren statistischen Bindungen liefern nun nicht mehr alle Abtastwerte volle Information über den Zufallsprozess. | |

| − | + | *Außerdem lassen die Bilder erkennen, dass bei der numerischen AKF–Berechnung einer Zufallsgröße mit statistischen Bindungen auch die Fehler korreliert sind. | |

| − | Begründung des schlechteren Ergebnisses gemäß $\text{Beispiel 6}$: | + | *Ist der AKF-Wert $φ_x({\rm 26})$ fälschlicherweise positiv und groß (siehe oberes Bild), so sind auch die benachbarten AKF-Werte $φ_x({\rm 25})$ und $φ_x({\rm 27})$ positiv und mit ähnlichen Zahlenwerten. |

| − | *Aufgrund der inneren statistischen Bindungen liefern nun nicht mehr alle Abtastwerte | + | *Dieser Bereich ist in der oberen Grafik durch das Rechteck markiert.}} |

| − | *Außerdem lassen die Bilder erkennen, dass bei der numerischen AKF–Berechnung einer Zufallsgröße mit statistischen Bindungen auch die Fehler korreliert sind. | ||

| − | *Ist | ||

==Aufgaben zum Kapitel== | ==Aufgaben zum Kapitel== | ||

Aktuelle Version vom 5. März 2022, 17:03 Uhr

Inhaltsverzeichnis

- 1 Zufallsprozesse

- 2 Stationäre Zufallsprozesse

- 3 Ergodische Zufallsprozesse

- 4 Allgemeingültige Beschreibung von Zufallsprozessen

- 5 Allgemeine Definition der Autokorrelationsfunktion

- 6 Autokorrelationsfunktion bei stationären und ergodischen Prozessen

- 7 Eigenschaften der Autokorrelationsfunktion

- 8 Interpretation der Autokorrelationsfunktion

- 9 Numerische AKF-Ermittlung

- 10 Genauigkeit der numerischen AKF-Berechnung

- 11 Aufgaben zum Kapitel

Zufallsprozesse

Ein wichtiger Begriff der stochastischen Signaltheorie ist der "Zufallsprozess". Nachfolgend sind einige Charakteristika eines solchen "stochastischen Prozesses" – diese Bezeichnungen werden sowohl in der Literatur als auch in unserem Tutorial synonym verwendet – zusammengestellt.

$\text{Definitionen:}$ Unter einem Zufallsprozess $\{x_i(t)\}$ verstehen wir ein mathematisches Modell für ein Ensemble von (vielen) Zufallssignalen, die sich zwar im Detail durchaus voneinander unterscheiden können und auch werden, trotzdem aber gewisse gemeinsame Eigenschaften aufweisen.

- Zur Beschreibung eines Zufallsprozesses $\{x_i(t)\}$ gehen wir von der Vorstellung aus, dass beliebig viele, in ihren physikalischen und statistischen Eigenschaften völlig gleiche Zufallsgeneratoren vorhanden sind, von denen jeder ein Zufallssignal $x_i(t)$ liefert.

- Jeder Zufallsgenerator gibt trotz gleicher physikalischer Realisierung ein anderes Zeitsignal $x_i(t)$ ab, das für alle Zeiten von $–∞$ bis $+∞$ existiert. Man bezeichnet dieses spezifische Zufallssignal als das $i$-te Mustersignal.

- Jeder Zufallsprozess beinhaltet mindestens eine stochastische Komponente – zum Beispiel die Amplitude, Frequenz oder Phase eines Nachrichtensignals – und kann daher von einem Beobachter nicht exakt vorausgesagt werden.

- Der Zufallsprozess unterscheidet sich von den sonst in der Wahrscheinlichkeitsrechnung bzw. der Statistik üblichen Zufallsexperimenten dadurch, dass das Ergebnis kein "Ereignis" ist, sondern ein "Funktionsverlauf"' (Zeitsignal).

- Betrachtet man den Zufallsprozess $\{x_i(t)\}$ zu einem festen Zeitpunkt, so gelangt man wieder zu dem einfacheren Modell aus dem Kapitel Vom Zufallsexperiment zur Zufallsgröße, nach dem das Versuchsergebnis ein Ereignis ist, das einer Zufallsgröße zugeordnet werden kann.

Diese Aussagen werden nun am Beispiel eines binären Zufallsgenerators verdeutlicht, der – zumindest gedanklich – beliebig oft realisiert werden kann.

$\text{Beispiel 1:}$ Die Grafik zeigt drei unterschiedliche Mustersignale eines Zufallsprozesses mit folgenden Eigenschaften:

- Der hier vorliegende Zufallsprozess $\{x_i(t)\}$ besteht aus einem Ensemble rechteckförmiger Musterfunktionen, die wie folgt beschrieben werden können:

- $$x_i(t)=\sum^{+\infty}_{\nu=-\infty} (a_\nu)_i\cdot g(t-\nu \cdot T ).$$

- Der Grundimpuls $g(t)$ besitzt im Bereich von $–T/2$ bis $+T/2$ den Wert $2\hspace{0.03cm}\rm V$. Außerhalb ist er Null und exakt bei $\pm T/2$ nur halb so groß $(1\hspace{0.03cm}\rm V)$.

- Erinnern wir uns: Ein Impuls ist gemäß der Definition im Kapitel Klassifizierung von Signalen im Buch „Signaldarstellung” ein sowohl "deterministisches" als auch "energiebegrenztes" Signal.

- Die Statistik des betrachteten Zufallsprozesses ist allein auf die dimensionslosen Amplitudenkoeffizienten $(a_ν)_i ∈ \{0, 1\}$ zurückzuführen, die bei der $i$-ten Musterfunktion mit dem Zeitindex $ν$ versehen sind.

- Trotz der im Detail unterschiedlichen Signalverläufe weisen die skizzierten Signale $x_1(t)$, $x_2(t)$, $x_3(t)$ und auch alle weiteren Mustersignale $x_4(t)$, $x_5(t)$, $x_6(t)$, ... gewisse Gemeinsamkeiten auf, die nachfolgend herausgearbeitet werden sollen.

Stationäre Zufallsprozesse

Definiert man den Momentanwert aller Musterfunktionen $x_i(t)$ zu einem festen Zeitpunkt $t = t_1$ als eine neue Zufallsgröße $x_1 = \{ x_i(t_1)\}$, so lassen sich deren statistische Eigenschaften nach den Aussagen

- des zweiten Kapitels „Diskrete Zufallsgrößen” und

- des dritten Kapitels „Kontinuierliche Zufallsgrößen”

in diesem Buch beschreiben.

In gleicher Weise erhalten wir für den Betrachtungszeitpunkt $t = t_2$ die Zufallsgröße $x_2 = \{ x_i(t_2)\}$.

$\text{Hinweis zur Nomenklatur:}$ Beachten Sie bitte, dass

- $x_1(t)$ und $x_2(t)$ Musterfunktionen des Zufallsprozesses $\{x_i(t)\}$ sind,

- während die Zufallsgrößen $x_1$ und $x_2$ den gesamten Prozess zu den Zeiten $t_1$ und $t_2$ charakterisieren.

Die Berechnung der statistischen Kenngrößen muss durch Scharmittelung über alle möglichen Musterfunktionen erfolgen $($Mittelung über die Laufvariable $i$, also über alle Realisierungen$)$.

$\text{Definition:}$

- Bei einem stationären Zufallsprozess $\{x_i(t)\}$ sind alle statistischen Kenngrößen $($Mittelwert, Streuung, Momente höherer Ordnung, Auftrittswahrscheinlichkeiten, etc.$)$ der Zufallsgrößen $x_1 = \{ x_i(t_1)\}$ und $x_2 = \{ x_i(t_2)\}$ gleich.

- Auch zu anderen Zeitpunkten ergeben sich genau gleiche Werte.

- Die Umkehrung lautet: Man bezeichnet einen Zufallsprozess $\{x_i(t)\}$ als "nicht-stationär", wenn er zu verschiedenen Zeitpunkten unterschiedliche statistische Eigenschaften aufweist.

$\text{Beispiel 2:}$ Eine große Anzahl von Mess-Stationen am Äquator ermitteln täglich um 12 Uhr Ortszeit die Temperatur.

- Mittelt man über all diese Messwerte, so kann man den Einfluss lokaler Indikatoren (z. B. Golfstrom) eliminieren.

- Trägt man die Scharmittelwerte über der Zeit auf, so wird sich nahezu eine Konstante ergeben, und man kann von einem "stationären Prozess" sprechen.

- Eine vergleichbare Messreihe am 50. Breitengrad würde aufgrund der jahreszeitlichen Schwankungen auf einen "nicht-stationären Prozess" hinweisen mit deutlichen Unterschieden hinsichtlich Mittelwert und Varianz der Mittagstemperatur zwischen Januar und Juli.

Ergodische Zufallsprozesse

Eine wichtige Unterklasse der stationären Zufallsprozesse sind die so genannten "ergodischen Prozesse" mit folgenden Eigenschaften:

$\text{Definition:}$ Bei einem ergodischen Prozess $\{x_i(t)\}$ ist jede einzelne Musterfunktion $x_i(t)$ repräsentativ für das gesamte Ensemble.

- Alle statistischen Beschreibungsgrößen eines ergodischen Prozesses kann man aus einer einzigen Musterfunktion durch Zeitmittelung $($bezüglich der Laufvariablen $ν = t/T$ ⇒ normierte Zeit$)$ gewinnen.

- Das bedeutet auch: Bei Ergodizität stimmen die Zeitmittelwerte einer jeden Musterfunktion mit den entsprechenden Scharmittelwerten zu beliebigen Zeitpunkten $ν$ überein.

Beispielsweise gilt bei Ergodizität für das Moment $k$-ter Ordnung:

- $$m_k=\overline{x^k(t)}={\rm E}\big[x^k\big].$$

Die überstreichende Linie kennzeichnet hierbei den Zeitmittelwert, während der Scharmittelwert durch Erwartungswertswertbildung $\rm E\big[ \hspace{0.1cm}\text{...} \hspace{0.1cm} \big]$ zu ermitteln ist, wie im Kapitel Momente einer diskreten Zufallsgröße beschrieben.

$\text{Anmerkung:}$ Die Ergodizität lässt sich aus einer endlichen Anzahl von Musterfunktionen und endlichen Signalausschnitten nicht nachweisen.

- Allerdings wird in den meisten Anwendungen zwar hypothetisch – aber trotzdem durchaus berechtigt – von Ergodizität ausgegangen.

- Anhand der gefundenen Ergebnisse muss anschließend die Plausibilität dieser Ergodizitätshypothese überprüft werden.

Allgemeingültige Beschreibung von Zufallsprozessen

Ist der zu analysierende Zufallsprozess $\{x_i(t)\}$ nicht stationär und damit mit Sicherheit auch nicht ergodisch, so müssen die Momente stets als Scharmittelwerte bestimmt werden.

- Im Allgemeinen sind diese zeitabhängig:

- $$m_k(t_1) \ne m_k(t_2).$$

- Da durch die Momente aber auch die charakteristische Funktion (Fourierrücktransformierte der WDF)

- $$ C_x(\Omega) ={\rm\sum^{\infty}_{{\it k}=0}}\ \frac{m_k}{k!}\cdot \Omega^{k}\ \circ\!\!-\!\!\!-\!\!\!-\!\!\bullet\,\ f_{x}(x)$$

festliegt, ist die Wahrscheinlichkeitsdichtefunktion $f_{x}(x)$ ebenfalls zeitabhängig.

- Sollen nicht nur die Amplitudenverteilungen zu verschiedenen Zeitpunkten $t_1, t_2$, ... ermittelt werden, sondern auch die statistischen Bindungen zwischen den Signalwerten zu diesen Zeiten, so muss man auf die zweidimensionale Verbundwahrscheinlichkeitsdichtefunktion übergehen.

Betrachtet man beispielsweise die beiden Zeitpunkte $t_1$ und $t_2$, so ist folgendes zu vermerken:

- Die 2D-WDF ergibt sich entsprechend den Angaben auf der Seite Eigenschaften und Beispiele zweidimensionaler Zufallsgrößen mit $x = x(t_1)$ und $y = x(t_2)$. Es ist offensichtlich, dass bereits die Ermittlung dieser Größe sehr aufwändig ist.

- Berücksichtigt man weiter, dass zur Erfassung aller statistischen Bindungen innerhalb des Zufallsprozesses eigentlich die $n$-dimensionale Verbundwahrscheinlichkeitsdichtefunktion herangezogen werden müsste, wobei möglichst noch der Grenzwert $n → ∞$ zu bilden ist, so erkennt man die Schwierigkeiten für die Lösung praktischer Probleme.

- Aus diesen Gründen geht man zur Beschreibung der statistischen Bindungen eines Zufallsprozesses auf die Autokorrelationsfunktion über, die das Problem vereinfacht. Diese wird im folgenden Abschnitt zunächst für den allgemeinen Fall definiert.

Allgemeine Definition der Autokorrelationsfunktion

$\text{Allgemeingültige Definition:}$

Die Autokorrelationsfunktion $\rm (AKF)$ eines Zufallsprozesses $\{x_i(t)\}$ ist gleich dem Erwartungswert des Produkts der Signalwerte zu zwei Zeitpunkten $t_1$ und $t_2$:

- $$\varphi_x(t_1,t_2)={\rm E}\big[x(t_{\rm 1})\cdot x(t_{\rm 2})\big].$$

Diese Definition gilt unabhängig davon, ob der Zufallsprozess ergodisch oder nichtergodisch ist, und sie gilt im Prinzip auch für nicht-stationäre Prozesse.

- Hinweis zur Nomenklatur:

- Um den Zusammenhang mit der Kreuzkorrelationsfunktion $φ_{xy}$ zwischen den beiden statistischen Größen $x$ und $y$ deutlich zu machen, wird in mancher Literatur für die Autokorrelationsfunktion anstelle von $φ_{x}$ auch häufig die Schreibweise $φ_{xx}$ verwendet. In unserem Lerntutorial verzichten wir darauf.

Ein Vergleich mit dem Abschnitt Erwartungswerte zweidimensionaler Zufallsgrößen zeigt, dass der AKF–Wert $φ_x(t_1, t_2)$ das gemeinsame Moment $m_{11}$ zwischen den beiden Zufallsgrößen $x(t_1)$ und $x(t_2)$ angibt.

Während für exakte Aussagen hinsichtlich der statistischen Bindungen eines Zufallsprozesses eigentlich die $n$–dimensionale Verbunddichte $($mit $n → ∞)$ benötigt wird, werden durch den Übergang auf die Autokorrelationsfunktion implizit folgende Vereinfachungen getroffen:

- Anstelle von unendlich vielen Zeitpunkten werden hier nur zwei betrachtet, und anstelle aller Momente $m_{\hspace{0.05cm}k\hspace{0.05cm}l}$ zu den beiden Zeitpunkten $t_1$ und $t_2$ mit $k, \ l ∈ \{1, 2, 3, \text{...} \}$ wird hier nur das gemeinsame Moment $m_{11}$ erfasst.

- Das Moment $m_{11}$ gibt ausschließlich die lineare Abhängigkeit („Korrelation”) des Prozesses wieder. Alle statistische Bindungen höherer Ordnung werden dagegen nicht berücksichtigt.

- Deshalb sollte bei der Bewertung von Zufallsprozessen mittels AKF stets berücksichtigt werden, dass diese nur sehr beschränkte Aussagen über die statistischen Bindungen allgemein erlaubt.

$\text{Beispiel 3:}$ Die obige Definition der Autokorrelationsfunktion gilt allgemein, also auch für nicht-stationäre und nicht-ergodische Prozesse.

- Ein Beispiel eines nichtstationären Vorgangs ist das Auftreten von Impulsstörungen im Fernsprechnetz, verursacht durch Wählimpulse in benachbarten Leitungen.

- Bei Digitalsignalübertragung führen solche nicht-stationären Störprozesse meist zu Bündelfehlern.

Autokorrelationsfunktion bei stationären und ergodischen Prozessen

Im Folgenden beschränken wir uns auf stationäre und ergodische Prozesse.

Ein solcher Zufallsprozess $\{x_i(t)\}$ wird zum Beispiel bei der Untersuchung von Thermischem Rauschen zugrunde gelegt. Dabei wird von der Vorstellung ausgegangen, dass

- beliebig viele, in ihren physikalischen und statistischen Eigenschaften völlig gleiche Widerstände vorhanden sind,

- von denen jeder ein anderes Zufallssignal $x_i(t)$ abgibt.

Die Grafik zeigt einen solchen stationären und ergodischen Prozess:

- Die einzelnen Musterfunktionen $x_i(t)$ können zu allen beliebigen Zeiten alle beliebigen Werte annehmen. Das bedeutet, dass der hier betrachtete Zufallsprozess $\{x_i(t)\}$ sowohl wert– als auch zeitkontinuierlich ist.

- Auch wenn über die tatsächlichen Signalwerte der einzelnen Musterfunktionen aufgrund der Stochastik keine Aussagen getroffen werden können, so sind die Momente und die WDF zu allen Zeitpunkten gleich.

- In der Grafik ist aus Gründen einer verallgemeinerten Darstellung auch ein Gleichanteil $m_x$ berücksichtigt, der bei Thermischem Rauschen allerdings nicht vorhanden ist.

$\text{Definition:}$ Man spricht von einem stationären Zufallsprozess $\{x_i(t)\}$, wenn seine statistischen Eigenschaften invariant gegenüber Zeitverschiebungen sind.

- Für die Autokorrelationsfunktion $\rm (AKF)$ bedeutet diese Aussage, dass sie nicht mehr eine Funktion der beiden unabhängigen Zeitvariablen $t_1$ und $t_2$ ist, sondern nur noch von der Zeitdifferenz $τ = t_2 - t_1$ abhängt:

- $$\varphi_x(t_1,t_2)\rightarrow{\varphi_x(\tau)={\rm E}\big[x(t)\cdot x(t+\tau)\big]}.$$

- Die Scharmittelung kann dabei zu jeder beliebigen Zeit $t$ erfolgen.

- Unter der weiteren Annahme von Ergodizität können alle Momente auch durch Zeitmittelung über eine einzige ausgewählte Musterfunktion $x(t)$ ermittelt werden.

- Alle diese Zeitmittelwerte stimmen in diesem Sonderfall mit den entsprechenden Scharmittelwerten überein.

$\text{Definition:}$ Damit folgt für die AKF eines ergodischen Zufallsprozesses, dessen Mustersignale jeweils von $–∞$ bis $+∞$ reichen:

- $$\varphi_x(\tau)=\overline{x(t)\cdot x(t+\tau)}=\lim_{T_{\rm M}\to\infty}\,\frac{1}{T_{\rm M} }\cdot\int^{T_{\rm M}/{\rm 2} }_{-T_{\rm M}/{\rm 2} }x(t)\cdot x(t+\tau)\,\,{\rm d}t.$$

- Die überstreichende Linie kennzeichnet die Zeitmittelung über das unendlich ausgedehnte Zeitintervall.

- $T_{\rm M}$ bezeichnet die Messdauer.

Bei periodischen Signalen kann man auf den Grenzübergang verzichten, so dass in diesem Sonderfall die Autokorrelationsfunktion mit der Periodendauer $T_0$ auch in folgender Weise geschrieben werden kann:

- $$\varphi_x(\tau)=\frac{1}{T_{\rm 0}}\cdot\int^{T_{\rm 0}/2}_{-T_{\rm 0}/2}x(t)\cdot x(t+\tau)\,\,{\rm d}t=\frac{1}{T_{\rm 0}}\cdot\int^{T_{\rm 0}}_{\rm 0}x(t)\cdot x(t+\tau)\,\,{\rm d}t .$$

Wichtig ist nur, dass insgesamt genau über eine Periodendauer $T_0$ (oder Vielfache davon) gemittelt wird. Egal ist, welchen Zeitausschnitt man verwendet.

Eigenschaften der Autokorrelationsfunktion

Hier werden wichtige Eigenschaften der Autokorrelationsfunktion (AKF) zusammengestellt, wobei wir von der ergodischen AKF–Form $φ_x(τ)$ ausgehen:

- Ist der betrachtete Zufallsprozess reell, so gilt dies auch für seine Autokorrelationsfunktion.

- Die AKF besitzt die Einheit einer Leistung, zum Beispiel „Watt” $\rm (W)$. Häufig bezieht man diese auf den Widerstand $1\hspace{0.03cm} Ω$; $φ_x(τ)$ hat dann die Einheit $\rm V^2$ bzw. $\rm A^2$.

- Die AKF ist immer eine gerade Funktion ⇒ $φ_x(–τ) = φ_x(τ)$. Alle Phasenbeziehungen des Zufallsprozesses gehen in der AKF verloren.

- Die AKF an der Stelle $τ = 0$ gibt das Moment zweiter Ordnung $(m_2)$ und damit die gesamte Signalleistung (Gleich– und Wechselanteil) an:

- $$\varphi_x(\tau = 0)= m_2=\overline{ x^2(t)}.$$

- Das AKF–Maximum tritt stets bei $τ = 0$ auf, und es gilt: $|φ_x(τ)| ≤ φ_x(0)$. Bei nichtperiodischen Prozessen ist für $τ ≠ 0$ der Betrag $|φ_x(τ)|$ stets kleiner als $φ_x(\tau =0)$ ⇒ Leistung des Zufallsprozesses.

- Bei einem periodischen Zufallsprozess weist die AKF die gleiche Periodendauer $T_0$ wie die einzelnen Mustersignale $x_i(t)$ auf:

- $$\varphi_x(\pm{T_0})=\varphi_x(\pm{2\cdot T_0})= \hspace{0.1cm}\text{...} \hspace{0.1cm}= \varphi_x(0).$$

- Der Gleichanteil $m_1$ eines nichtperiodischen Signals kann aus dem Grenzwert der Autokorrelationsfunktion für $τ → ∞$ berechnet werden. Hierbei gilt:

- $$\lim_{\tau\to\infty}\,\varphi_x(\tau)= m_1^2=\big [\overline{ x(t)}\big]^2.$$

- Dagegen schwankt bei Signalen mit periodischen Anteilen der Grenzwert der AKF für $τ → ∞$ um diesen Endwert (Quadrat des Gleichanteils).

Interpretation der Autokorrelationsfunktion

Die Grafik zeigt oben je ein Mustersignal zweier Zufallsprozesse $\{x_i(t)\}$ und $\{y_i(t)\}$, unten die zugehörigen Autokorrelationsfunktionen.

Anhand dieser Darstellungen sind folgende Aussagen möglich:

- $\{y_i(t)\}$ hat stärkere innere statistische Bindungen als $\{x_i(t)\}$. Spektral gesehen ist der Prozess $\{y_i(t)\}$ also niederfrequenter.

- Die skizzierten Mustersignale $x(t)$ und $y(t)$ lassen bereits vermuten, dass beide Prozesse mittelwertfrei sind und den gleichen Effektivwert aufweisen.

- Die obigen Autokorrelationsfunktionen bestätigen diese Aussagen. Die liearen Mittelwerte $m_x = m_y = 0$ ergeben sich jeweils aus dem AKF–Grenzwert für $τ → ∞$.

- Wegen $m_x = 0$ gilt hier für die Varianz: $σ_x^2 = φ_x(0) = 0.01 \hspace{0.05cm} \rm V^2$, und der Effektivwert ist demzufolge $σ_x = 0.1 \hspace{0.05cm}\rm V$.

- $y(t)$ hat die gleiche Varianz und und den gleichen Effektivwert wie $x(t)$. Die AKF–Werte fallen um so langsamer ab, je stärker die inneren statistischen Bindungen sind.

- Das Signal $x(t)$ mit schmaler AKF ändert sich zeitlich sehr schnell, während beim niederfrequenteren Signal $y(t)$ die statistischen Bindungen deutlich weiter reichen.

- Das bedeutet aber auch, dass der Signalwert $y(t + τ)$ aus $y(t)$ besser vorhergesagt werden kann als $x(t + τ)$ aus $x(t)$.

$\text{Definition:}$ Eine quantitative Kenngröße für die Stärke der statistischen Bindungen ist die äquivalente AKF-Dauer $∇τ$ (man spricht „Nabla–tau”), die sich aus der AKF über das flächengleiche Rechteck ermitteln lässt:

- $${ {\rm \nabla} }\tau =\frac{1}{\varphi_x(0)}\cdot\int^{\infty}_{-\infty}\ \varphi_x(\tau)\,\,{\rm d}\tau. $$

- Bei den hier betrachteten Prozessen (mit gaußähnlicher AKF) gilt entsprechend obiger Skizze: $∇τ_x = 0.33 \hspace{0.05cm} \rm µ s$ bzw. $∇τ_y = 1 \hspace{0.05cm} \rm µs$.

- Als ein weiteres Maß für die Stärke der statistischen Bindungen wird in der Literatur häufig die Korrelationsdauer $T_{\rm K}$ verwendet.

- Diese gibt die Zeitdauer an, bei der die Autokorrelationsfunktion auf die Häfte ihres Maximalwertes abgefallen ist.

Numerische AKF-Ermittlung

Bisher haben wir stets zeitkontinuierliche Signale $x(t)$ betrachtet, die für die Darstellung und Simulation mittels Digitalrechner ungeeignet sind. Hierzu ist vielmehr eine zeitdiskrete Signaldarstellung $〈x_ν〉$ erforderlich, wie im Kapitel Zeitdiskrete Signaldarstellung unseres ersten Buches dargelegt.

Hier eine kurze Zusammenfassung:

- Das zeitdiskrete Signal $〈x_ν〉$ ist die Folge der Abtastwerte $x_ν = x(ν · T_{\rm A}).$

- Das zeitkontinuierliche Signal $x(t)$ wird durch die Folge $〈x_ν〉$ vollständig beschrieben, wenn das Abtasttheorem erfüllt ist:

- $$T_{\rm A} \le \frac{1}{2 \cdot B_x}.$$

- $B_x$ bezeichnet die absolute (einseitige) Bandbreite des Analogsignals $x(t)$. Diese sagt aus, dass die Spektralfunktion $X(f)$ für alle Frequenzen $| f | > B_x$ Null ist.

$\text{Beispiel 4:}$ Das Bild zeigt einen Ausschnitt eines Audiosignals der Dauer $10$ Millisekunden.

Obwohl das gesamte Signal ein breites Spektrum mit der Mittenfrequenz bei etwa $500 \hspace{0.05cm} \rm Hz$ besitzt, ist im betrachteten (kurzen) Zeitintervall ein (nahezu) periodisches Signal mit etwa der Periodendauer $T_0 = 4.3 \hspace{0.05cm} \rm ms$ zu erkennen. Daraus ergibt sich die Grundfrequenz zu

- $$f_0 = 1/T_0 \approx 230 \hspace{0.05cm} \rm Hz.$$

Blau eingezeichnet sind die Abtastwerte im Abstand $T_{\rm A} = 0.5 \hspace{0.05cm} \rm ms$.

- Diese Folge $〈x_ν〉$ von Abtastwerten würde allerdings nur dann die gesamte Information über das Analogsignal $x(t)$ beinhalten, wenn dieses auf den Frequenzbereich bis $1 \hspace{0.05cm} \rm kHz$ begrenzt wäre.

- Sind im Signal $x(t)$ höhere Frequenzanteile enthalten, so muss $T_{\rm A}$ entsprechend kleiner gewählt werden.

$\text{Fazit:}$

- Liegen die Signalwerte nur zu diskreten Zeitpunkten $($bei Vielfachen von $T_{\rm A})$ vor, so kann man auch die Autokorrelationsfunktion nur zu ganzzahligen Vielfachen von $T_{\rm A}$ bestimmen.

- Die AKF–Berechnung lässt sich somit wie folgt dargestellen (die überstreichende Linie kennzeichnet wieder die Zeitmittelung):

- $$\varphi_k = \overline {x_\nu \cdot x_{\nu + k} }$$

- mit den zeitdiskreten Signalwerten $x_ν = x(ν · T_{\rm A})$ und $x_{ν+k} = x((ν+k) · T_{\rm A})$

- sowie der zeitdiskreten AKF $φ_k = φ_x(k · T_{\rm A})$.

Wir stellen uns nun die Aufgabe, die AKF-Stützstellen $φ_0, \hspace{0.1cm}\text{...}\hspace{0.1cm} , φ_l$

- aus $N$ Abtastwerten $(x_1, \hspace{0.1cm}\text{...}\hspace{0.1cm} , x_N)$ zu ermitteln,

- wobei der Parameter $l \ll N$ vorausgesetzt wird.

Beispielsweise gelte $l = 100$ und $N = 100000$. Die AKF-Berechnungsvorschrift lautet nun $($mit $0 ≤ k ≤ l)$:

- $$\varphi_k = \frac{1}{N- k} \cdot \sum_{\nu = 1}^{N - k} x_{\nu} \cdot x_{\nu + k}.$$

Bringen wir den Faktor $(N - k)$ auf die linke Seite, so erhalten wir daraus $l + 1$ Gleichungen, nämlich:

- $$k = 0\text{:} \hspace{0.4cm}N \cdot \varphi_0 \hspace{1.03cm}=\hspace{0.1cm} x_{\rm 1} \cdot x_{\rm 1} \hspace{0.35cm}+ x_{\rm 2} \cdot x_{\rm 2} \hspace{0.3cm}+\text{ ...} \hspace{0.25cm}+x_{\nu} \cdot x_{\nu}\hspace{0.35cm}+\text{ ...} \hspace{0.05cm}+x_{N} \cdot x_{N},$$

- $$k= 1\text{:} \hspace{0.3cm}(N-1) \cdot \varphi_1 \hspace{0.08cm}=\hspace{0.1cm} x_{\rm 1} \cdot x_{\rm 2} \hspace{0.4cm}+ x_{\rm 2} \cdot x_{\rm 3} \hspace{0.3cm}+ \text{ ...} \hspace{0.18cm}+x_{\nu} \cdot x_{\nu + 1}\hspace{0.01cm}+\text{ ...}\hspace{0.08cm}+x_{N-1} \cdot x_{N},$$

- $$\text{..................................................}$$

- $$k \hspace{0.2cm}{\rm allg.\hspace{-0.1cm}:}\hspace{0.15cm}(N - k) \cdot \varphi_k \hspace{0.01cm}=\hspace{0.1cm} x_{\rm 1} \cdot x_{ {\rm 1} + k} \hspace{0.01cm}+ x_{\rm 2} \cdot x_{ {\rm 2}+ k}\hspace{0.1cm} + \text{ ...}\hspace{0.01cm}+x_{\nu} \cdot x_{\nu+k}\hspace{0.1cm}+\text{ ...}\hspace{0.01cm}+x_{N-k} \cdot x_{N},$$

- $$\text{..................................................}$$

- $$k = l\text{:} \hspace{0.3cm}(N - l) \cdot \varphi_l \hspace{0.14cm}=\hspace{0.1cm} x_{\rm 1} \cdot x_{ {\rm 1}+l} \hspace{0.09cm}+ x_{\rm 2} \cdot x_{ {\rm 2}+ l} \hspace{0.09cm}+ \text{ ...}\hspace{0.09cm}+x_{\nu} \cdot x_{\nu+ l} \hspace{0.09cm}+ \text{ ...}\hspace{0.09cm}+x_{N- l} \cdot x_{N}.$$

$\text{Fazit:}$ Nach diesem Schema ergibt sich der folgende Algorithmus:

- Man definiert das Feld $\rm AKF\big[\hspace{0.05cm}0 : {\it l}\hspace{0.1cm}\big]$ vom Typ „float” und belegt alle Elemente mit Nullen vor.

- Bei jedem Schleifendurchlauf $($indiziert mit der Variablen $k)$ werden die $l + 1$ Feldelemente ${\rm AKF}\big[\hspace{0.03cm}k\hspace{0.03cm}\big]$ jeweils um den Beitrag $x_ν · x_{ν+k}$ erhöht.

- Alle $l+1$ Feldelemente werden allerdings nur dann bearbeitet, so lange die Laufvariable $k$ nicht größer als $N - l$ ist.

- Es ist stets zu berücksichtigen, dass $ν + k ≤ N$ gelten muss. Das bedeutet, dass die Mittelung in den unterschiedlichen Feldern $\rm AKF\big[\hspace{0.03cm}0\hspace{0.03cm}\big]$ ... ${\rm AKF}\big[\hspace{0.03cm}l\hspace{0.03cm}\big]$ über eine unterschiedliche Anzahl von Summanden erfolgen muss.

- Werden am Ende der Berechnung noch die in ${\rm AKF}\big[\hspace{0.03cm}k\hspace{0.03cm}\big]$ gespeicherten Werte durch die Anzahl der Summanden $(N - k)$ dividiert, so enthält dieses Feld die gesuchten diskreten AKF-Werte:

- $$\varphi_x(k \cdot T_A)= {\rm AKF} \big[\hspace{0.03cm}k\hspace{0.03cm}\big].$$

$\text{Anmerkung:}$ Bei $l \ll N$ kann man den Algorithmus vereinfachen, indem die Anzahl der Summanden für alle $k$–Werte gleich gewählt werden:

- $$\varphi_k = \frac{1}{N- l} \cdot \sum_{\nu = 1}^{N - l} x_{\nu} \cdot x_{\nu + k}.$$

Genauigkeit der numerischen AKF-Berechnung

$\text{Beispiel 5:}$ Der entscheidende Parameter für die Qualität der numerischen AKF–Berechnung ist die Anzahl $N$ der berücksichtigten Abtastwerte.

In der oberen Grafik sehen Sie das Ergebnis der numerischen AKF-Berechnung für $N = 1000$. Die untere Grafik gilt für $N = 10000$ Abtastwerte.

- Die betrachteten Zufallsgrößen sind hier voneinander statistisch unabhängig.

- Somit sollten eigentlich alle AKF–Werte mit Ausnahme des Wertes bei $k = 0$ identisch Null sein.

- Bei $N = 10000$ (untere Grafik) beträgt der maximale Fehler nur etwa $1\%$ und ist bei dieser Darstellung fast nicht mehr sichtbar.

- Bei $N = 1000$ (obere Grafik) wächst der Fehler bis auf $±6\%$ an.

$\text{Beispiel 6:}$ Die Ergebnisse ändern sich, wenn eine Zufallsgröße mit inneren statistischen Bindungen vorliegt.

Betrachten wir beispielsweise eine dreieckförmige AKF mit $φ_x(k) ≠ 0$ für $\vert k \vert ≤ 10$, so erkennt man deutlich größere Abweichungen, nämlich

- Fehler bis zu etwa $±15\%$ bei $N = 1000$,

- Fehler bis zu etwa $±5\%$ bei $N = 10000$.

Begründung des schlechteren Ergebnisses gemäß $\text{Beispiel 6}$:

- Aufgrund der inneren statistischen Bindungen liefern nun nicht mehr alle Abtastwerte volle Information über den Zufallsprozess.

- Außerdem lassen die Bilder erkennen, dass bei der numerischen AKF–Berechnung einer Zufallsgröße mit statistischen Bindungen auch die Fehler korreliert sind.

- Ist der AKF-Wert $φ_x({\rm 26})$ fälschlicherweise positiv und groß (siehe oberes Bild), so sind auch die benachbarten AKF-Werte $φ_x({\rm 25})$ und $φ_x({\rm 27})$ positiv und mit ähnlichen Zahlenwerten.

- Dieser Bereich ist in der oberen Grafik durch das Rechteck markiert.

Aufgaben zum Kapitel

Aufgabe 4.09Z: Periodische AKF

Aufgabe 4.10: Binär und quaternär

Aufgabe 4.10Z: Korrelationsdauer

Aufgabe 4.11: C-Programm „akf1”

Aufgabe 4.11Z: C-Programm „akf2”