Fehlerwahrscheinlichkeit bei Basisbandübertragung

Inhaltsverzeichnis

Definition der Bitfehlerwahrscheinlichkeit

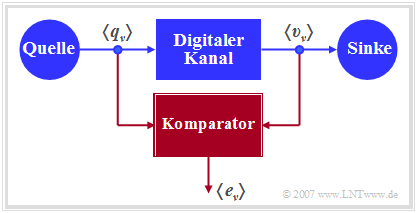

Die Grafik zeigt ein sehr einfaches, aber allgemeingültiges Modell eines binären Übertragungssystems.

Dieses lässt sich wie folgt charakterisieren:

- Die Quelle und die Sinke werden durch die beiden Binärfolgen 〈qν〉 und 〈υν〉 beschrieben.

- Das gesamte Übertragungsystem – bestehend aus Sender, Übertragungskanal inklusive Störungen und Empfänger – wird als „Black Box” mit binärem Ein– und Ausgang betrachtet.

- Dieser „Digitale Kanal” wird allein durch die Fehlerfolge 〈eν〉 charakterisiert. Bei fehlerfreier Übertragung des ν–ten Bits (υν = qν) gilt eν = 0, andernfalls (υν ≠ qν) wird eν = 1 gesetzt.

Diese statistische Größe ist das wichtigste Beurteilungskriterium eines jeden Digitalsystems.

Die Berechnung als Erwartungswert E[…..] gemäß dem ersten Teil der obigen Gleichung entspricht einer Scharmittelung über die Verfälschungswahrscheinlichkeit Pr(υν ≠ qν) des ν–ten Symbols, während die überstreichende Linie im rechten Teil eine Zeitmittelung kennzeichnet. Beide Berechnungsarten führen – unter der gerechtfertigten Annahme ergodischer Prozesse – zum gleichen Ergebnis, wie im Kapitel 4 des Buches „Stochastische Signaltheorie” gezeigt wurde.

Auch aus der Fehlerfolge 〈eν〉 lässt sich die Bitfehlerwahrscheinlichkeit als Erwartungswert bestimmen, wobei zu berücksichtigen ist, dass eν nur die Werte 0 und 1 annehmen kann:\[\it p_{\rm B} = \rm E[\rm Pr(\it e_{\nu}=\rm 1)]= {\rm E}[{\it e_{\nu}}]\hspace{0.05cm}.\] Die obige Definition der Bitfehlerwahrscheinlichkeit gilt unabhängig davon, ob es statistische Bindungen innerhalb der Fehlerfolge 〈eν〉 gibt oder nicht. Je nachdem ist der Aufwand zur Berechnung von pB unterschiedlich groß und bei einer Systemsimulation müssen unterschiedliche digitale Kanalmodelle herangezogen werden. Im Kapitel 5 wird gezeigt, dass das sog. BSC–Modell (Binary Symmetrical Channel) statistisch unabhängige Fehler liefert, während für die Beschreibung von Bündelfehlerkanälen auf die Modelle von Gilbert–Elliott: .: Capacity of Burst–Noise Channel, In: Bell Syst. Techn. J. Vol. 39, 1960, pp. 1253–1266 and McCullough : The Binary Regenerative Channel, In: Bell Syst. Techn. J. (47), 1968 zurückgegriffen werden muss.

Definition der Bitfehlerquote (1)

Die Bitfehlerwahrscheinlichkeit pB eignet sich zum Beispiel gut für die Konzipierung und Optimierung von Digitalsystemen. Diese ist eine Apriori-Kenngröße, die eine Vorhersage über das Fehlerverhalten eines Nachrichtensystems erlaubt, ohne dass dieses bereits realisiert sein muss.

Dagegen muss zur messtechnischen Erfassung der Qualität eines realisierten Systems oder bei einer Systemsimulation auf die Bitfehlerquote übergegangen werden, die durch den Vergleich von Quellen– und Sinkensymbolfolge ermittelt wird. Diese ist somit eine Aposteriori-Kenngröße des Systems.

Die Schreibweise hB(N) soll deutlich machen, dass die per Messung oder durch Simulation ermittelte Bitfehlerquote signifikant von dem Parameter N – also der Anzahl der insgesamt übertragenen oder simulierten Symbole – abhängt. Nach den elementaren Gesetzen der Wahrscheinlichkeitsrechnung stimmt nur im Grenzfall N → ∞ die Aposteriori–Kenngröße hB mit der Apriori–Kenngröße pB exakt überein.

Der Zusammenhang zwischen Wahrscheinlichkeit und relativer Häufigkeit wird in einem Lernvideo zum Buch „Stochastische Signaltheorie” verdeutlicht:

Das Bernoullische Gesetz der großen Zahlen (Dateigröße: 1.97 MB, Dauer: 4:25)

Für die nachfolgende Herleitung wird das BSC–Modell zugrunde gelegt, das in Kapitel 5.2 im Detail beschrieben wird. Jedes einzelne Bit wird mit der Wahrscheinlichkeit p = Pr(υν ≠ qν) = Pr(eν = 1) verfälscht, unabhängig von den Fehlerwahrscheinlichkeiten der benachbarten Symbole. Die (mittlere) Bitfehlerwahrscheinlichkeit pB ist somit ebenfalls gleich p.

Definition der Bitfehlerquote (2)

Nun soll abgeschätzt werden, wie genau die Bitfehlerwahrscheinlichkeit pB = p beim BSC-Modell durch die Bitfehlerquote hB approximiert wird. Dies geschieht in mehreren Schritten:

- Die Anzahl der Bitfehler bei der Übertragung von N Symbolen ist eine diskrete Zufallsgröße:\[n_{\rm B}(N) = \sum\limits_{\it \nu=\rm 1}^{\it N} e_{\nu} \hspace{0.2cm} \in \hspace{0.2cm} \{0, 1, ... , N \}\hspace{0.05cm}.\]

- Bei statistisch unabhängigen Fehlern (BSC) ist nB binominalverteilt. Demzufolge gilt:\[m_{n{\rm B}}=N \cdot p_{\rm B},\hspace{0.2cm}\sigma_{n{\rm B}}=\sqrt{N\cdot p_{\rm B}\cdot (\rm 1- \it p_{\rm B})}\hspace{0.05cm}.\]

- Für Mittelwert und Streuung der Bitfehlerquote hB = nB/N gilt deshalb:\[m_{h{\rm B}}= \frac{m_{n{\rm B}}}{N} = p_{\rm B}\hspace{0.05cm},\hspace{0.2cm}\sigma_{h{\rm B}}= \frac{\sigma_{n{\rm B}}}{N}= \sqrt{\frac{ p_{\rm B}\cdot (\rm 1- \it p_{\rm B})}{N}}\hspace{0.05cm}.\]

- Nach Moivre und Laplace lässt sich die Binominalverteilung in eine Gaußverteilung überführen:\[f_{h{\rm B}}({h_{\rm B}}) \approx \frac{1}{\sqrt{2\pi}\cdot\sigma_{h{\rm B}}}\cdot {\rm exp} \left[-\frac{(h_{\rm B}-p_{\rm B})^2}{2 \cdot \sigma_{h{\rm B}}^2}\right].\]

- Mit dem Gaußschen Fehlerintergal Q(x) lässt sich somit die Wahrscheinlichkeit pε berechnen, dass die per Simulation/Messung über N Symbole ermittelte Bitfehlerquote hB(N) betragsmäßig um weniger als einen Wert ε von der tatsächlichen Bitfehlerwahrscheinlichkeit pB abweicht:\[p_{\varepsilon}= {\rm Pr} \left( |h_{\rm B}(N) - p_{\rm B}| < \varepsilon \right) = 1 -2 \cdot {\rm Q} \left( \frac{\varepsilon}{\sigma_{h{\rm B}}} \right)= 1 -2 \cdot {\rm Q} \left( \frac{\varepsilon \cdot \sqrt{N}}{\sqrt{p_{\rm B} \cdot (1-p_{\rm B})}} \right)\hspace{0.05cm}.\]

Dieses Ergebnis ist wie folgt zu interpretieren: Wenn man unendlich viele Versuchsreihen über jeweils N Symbole durchführt, ist der Mittelwert mhB tatsächlich gleich der gesuchten Fehlerwahrscheinlichkeit pB. Bei einer einzigen Versuchsreihe wird man dagegen nur eine Näherung erhalten, wobei die jeweilige Abweichung vom Sollwert bei mehreren Versuchsreihen gaußverteilt ist.

\(\sigma_{h{\rm B}}= \sqrt{{ p_{\rm B}\cdot (\rm 1- \it p_{\rm B})}/{N}}\approx 10^{-4}\hspace{0.05cm}.\)

Fehlerwahrscheinlichkeit bei Gaußsch (..) n (1)

Entsprechend den und Voraussetzungen für Kapitel 1 Voraussetzungen zu diesem Kapitel gehen wir davon aus, dass das Detektionssignal zu den Detektionszeitpunkten wie folgt dargestellt werden kann: