Aufgabe 4.5Z: Nochmals Transinformation

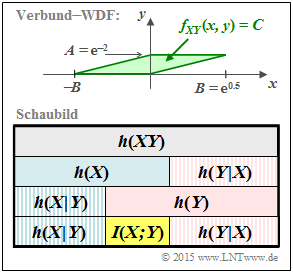

Die Grafik zeigt oben die in dieser Aufgabe zu betrachtende Verbund–WDF fXY(x, y), die identisch ist mit der „grünen” Konstellation in Aufgabe A4.5. Die Skizze ist in der y–Richtung um den Faktor 3 vergrößert. Im grün hinterlegten Definitionsgebiet ist die Verbund–WDF konstant gleich C = 1/F, wobei F die Fläche des Parallelogramms angibt.

In der Aufgabe A4.5 wurden folgende differentielle Entropien berechnet: $$h(X) \ = \ {\rm log} \hspace{0.1cm} (\hspace{0.05cm}A\hspace{0.05cm})\hspace{0.05cm},$$ $$h(Y) = {\rm log} \hspace{0.1cm} (\hspace{0.05cm}B \cdot \sqrt{ {\rm e } } \hspace{0.05cm})\hspace{0.05cm},$$ $$h(XY) = {\rm log} \hspace{0.1cm} (\hspace{0.05cm}F \hspace{0.05cm}) = {\rm log} \hspace{0.1cm} (\hspace{0.05cm}A \cdot B \hspace{0.05cm})\hspace{0.05cm}.$$ In dieser Aufgabe sind nun die speziellen Parameterwerte A = e–2 und B = e0.5 zu verwenden. Außerdem ist zu beachten:

- Bei Verwendung des natürlichen Logarithmus „ln” ist die Pseudo–Einheit „nat” anzufügen.

- Verwendet man den Logarithmus dualis ⇒ „log2”, so ergeben sich alle Größen in „bit”.

Entsprechend dem obigen Schaubild sollen nun auch die bedingten differentiellen Entropien h(Y|X) und h(X|Y) ermittelt und deren Bezug zur Transinformation I(X;Y) angegeben werden.

Hinweis: Die Aufgabe gehört zum Themengebiet von Kapitel 4.2.

Fragebogen

Musterlösung