Aufgaben:Aufgabe 4.4: Herkömmliche Entropie und differenzielle Entropie: Unterschied zwischen den Versionen

| (4 dazwischenliegende Versionen desselben Benutzers werden nicht angezeigt) | |||

| Zeile 4: | Zeile 4: | ||

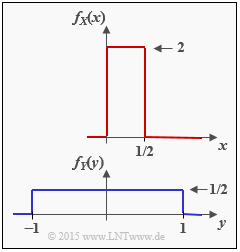

[[Datei:P_ID2878__Inf_A_4_4.png|right|frame|Zweimal Gleichverteilung]] | [[Datei:P_ID2878__Inf_A_4_4.png|right|frame|Zweimal Gleichverteilung]] | ||

| − | Wir betrachten die | + | Wir betrachten die beiden wertkontinuierlichen Zufallsgrößen $X$ und $Y$ mit den Wahrscheinlichkeitsdichtefunktionen $f_X(x)$ und $f_Y(y)$. Für diese Zufallsgrößen kann man |

| − | * die herkömmlichen Entropien $H(X)$ bzw. $H(Y)$ nicht angeben, | + | * die herkömmlichen Entropien $H(X)$ bzw. $H(Y)$ nicht angeben, |

| − | * jedoch aber die differentiellen Entropien $h(X)$ und $h(Y)$. | + | * jedoch aber die differentiellen Entropien $h(X)$ und $h(Y)$. |

Wir betrachten außerdem zwei wertdiskrete Zufallsgrößen: | Wir betrachten außerdem zwei wertdiskrete Zufallsgrößen: | ||

| − | *Die Zufallsgröße $Z_{X,\hspace{0.05cm}M}$ ergibt sich durch (geeignete) Quantisierung der Zufallsgröße $X$ mit der Quantisierungsstufenzahl | + | *Die Zufallsgröße $Z_{X,\hspace{0.05cm}M}$ ergibt sich durch (geeignete) Quantisierung der Zufallsgröße $X$ mit der Quantisierungsstufenzahl $M$ <br>⇒ Quantisierungsintervallbreite ${\it \Delta} = 0.5/M$. |

| − | * Die Zufallsgröße $Z_{Y,\hspace{0.05cm}M}$ ergibt sich nach Quantisierung der Zufallsgröße $Y$ mit der Quantisierungsstufenzahl $M$ ⇒ Quantisierungsintervallbreite ${\it \Delta} = 2/M$. | + | * Die Zufallsgröße $Z_{Y,\hspace{0.05cm}M}$ ergibt sich nach Quantisierung der Zufallsgröße $Y$ mit der Quantisierungsstufenzahl $M$ <br>⇒ Quantisierungsintervallbreite ${\it \Delta} = 2/M$. |

| − | Die Wahrscheinlichkeitsdichtefunktionen dieser diskreten Zufallsgrößen setzen sich jeweils aus $M$ Diracfunktionen zusammen, deren Impulsgewichte durch die Intervallflächen der zugehörigen wertkontinuierlichen Zufallsgrößen gegeben sind. | + | Die Wahrscheinlichkeitsdichtefunktionen dieser diskreten Zufallsgrößen setzen sich jeweils aus $M$ Diracfunktionen zusammen, deren Impulsgewichte durch die Intervallflächen der zugehörigen wertkontinuierlichen Zufallsgrößen gegeben sind. |

| − | Daraus lassen sich die Entropien $H(Z_{X,\hspace{0.05cm}M})$ und $H(Z_{Y,\hspace{0.05cm}M})$ in herkömmlicher Weise entsprechend dem Kapitel [[Informationstheorie/Einige_Vorbemerkungen_zu_zweidimensionalen_Zufallsgrößen#Wahrscheinlichkeitsfunktion_und_Entropie|Wahrscheinlichkeitsfunktion und Entropie]] bestimmen. | + | Daraus lassen sich die Entropien $H(Z_{X,\hspace{0.05cm}M})$ und $H(Z_{Y,\hspace{0.05cm}M})$ in herkömmlicher Weise entsprechend dem Kapitel [[Informationstheorie/Einige_Vorbemerkungen_zu_zweidimensionalen_Zufallsgrößen#Wahrscheinlichkeitsfunktion_und_Entropie|Wahrscheinlichkeitsfunktion und Entropie]] bestimmen. |

| − | Im Abschnitt [[Informationstheorie/Differentielle_Entropie#Entropie_wertkontinuierlicher_Zufallsgr.C3.B6.C3.9Fen_nach_Quantisierung|Entropie wertkontinuierlicher Zufallsgrößen nach Quantisierung]] wurde auch eine Näherung angegeben. Beispielsweise gilt: | + | Im Abschnitt [[Informationstheorie/Differentielle_Entropie#Entropie_wertkontinuierlicher_Zufallsgr.C3.B6.C3.9Fen_nach_Quantisierung|Entropie wertkontinuierlicher Zufallsgrößen nach Quantisierung]] wurde auch eine Näherung angegeben. Beispielsweise gilt: |

:$$H(Z_{X, \hspace{0.05cm}M}) \approx -{\rm log}_2 \hspace{0.1cm} ({\it \Delta}) + h(X)\hspace{0.05cm}. $$ | :$$H(Z_{X, \hspace{0.05cm}M}) \approx -{\rm log}_2 \hspace{0.1cm} ({\it \Delta}) + h(X)\hspace{0.05cm}. $$ | ||

| − | * | + | *Im Laufe der Aufgabe wird sich zeigen, dass bei rechteckförmiger WDF ⇒ Gleichverteilung diese „Näherung” das gleiche Ergebnis liefert wie die direkte Berechnung. |

| − | *Aber im allgemeinen Fall – so im [[Informationstheorie/Differentielle_Entropie#Entropie_wertkontinuierlicher_Zufallsgr.C3.B6.C3.9Fen_nach_Quantisierung|$\text{Beispiel 2}$]] mit dreieckförmiger WDF – stellt obige Gleichung tatsächlich nur eine Näherung dar, die erst im Grenzfall ${\it \Delta} \to 0$ mit der tatsächlichen Entropie $H(Z_{X,\hspace{0.05cm}M})$ übereinstimmt. | + | *Aber im allgemeinen Fall – so im [[Informationstheorie/Differentielle_Entropie#Entropie_wertkontinuierlicher_Zufallsgr.C3.B6.C3.9Fen_nach_Quantisierung|$\text{Beispiel 2}$]] mit dreieckförmiger WDF – stellt obige Gleichung tatsächlich nur eine Näherung dar, die erst im Grenzfall ${\it \Delta} \to 0$ mit der tatsächlichen Entropie $H(Z_{X,\hspace{0.05cm}M})$ übereinstimmt. |

| + | |||

| + | |||

| + | |||

| Zeile 30: | Zeile 33: | ||

''Hinweise:'' | ''Hinweise:'' | ||

| − | *Die Aufgabe gehört zum Kapitel [[Informationstheorie/Differentielle_Entropie|Differentielle Entropie]]. | + | *Die Aufgabe gehört zum Kapitel [[Informationstheorie/Differentielle_Entropie|Differentielle Entropie]]. |

| − | *Nützliche Hinweise zur Lösung dieser Aufgabe finden Sie insbesondere auf der Seite [[Informationstheorie/Differentielle_Entropie#Entropie_wertkontinuierlicher_Zufallsgr.C3.B6.C3.9Fen_nach_Quantisierung|Entropie wertkontinuierlicher Zufallsgrößen nach Quantisierung]] . | + | *Nützliche Hinweise zur Lösung dieser Aufgabe finden Sie insbesondere auf der Seite [[Informationstheorie/Differentielle_Entropie#Entropie_wertkontinuierlicher_Zufallsgr.C3.B6.C3.9Fen_nach_Quantisierung|Entropie wertkontinuierlicher Zufallsgrößen nach Quantisierung]] . |

| Zeile 39: | Zeile 42: | ||

<quiz display=simple> | <quiz display=simple> | ||

| − | {Berechnen Sie die differentielle Entropie $h(X)$. | + | {Berechnen Sie die differentielle Entropie $h(X)$. |

|type="{}"} | |type="{}"} | ||

$ h(X) \ = \ $ { -1.03--0.97 } $\ \rm bit$ | $ h(X) \ = \ $ { -1.03--0.97 } $\ \rm bit$ | ||

| Zeile 47: | Zeile 50: | ||

$ h(Y) \ = \ $ { 1 3% } $\ \rm bit$ | $ h(Y) \ = \ $ { 1 3% } $\ \rm bit$ | ||

| − | {Berechnen Sie die Entropie der wertdiskreten Zufallsgrößen $Z_{X,\hspace{0.05cm}M=4}$ | + | {Berechnen Sie die Entropie der wertdiskreten Zufallsgrößen $Z_{X,\hspace{0.05cm}M=4}$ nach der direkten Methode</u>. |

|type="{}"} | |type="{}"} | ||

$H(Z_{X,\hspace{0.05cm}M=4})\ = \ $ { 2 3% } $\ \rm bit$ | $H(Z_{X,\hspace{0.05cm}M=4})\ = \ $ { 2 3% } $\ \rm bit$ | ||

| − | {Berechnen Sie die Entropie der wertdiskreten Zufallsgrößen $Z_{X,\hspace{0.05cm}M=4}$ | + | {Berechnen Sie die Entropie der wertdiskreten Zufallsgrößen $Z_{X,\hspace{0.05cm}M=4}$ mit der angegebenen Näherung</u>. |

|type="{}"} | |type="{}"} | ||

$H(Z_{X,\hspace{0.05cm}M=4})\ = \ $ { 2 3% } $\ \rm bit$ | $H(Z_{X,\hspace{0.05cm}M=4})\ = \ $ { 2 3% } $\ \rm bit$ | ||

| − | {Berechnen Sie die Entropie der wertdiskreten Zufallsgröße | + | {Berechnen Sie die Entropie der wertdiskreten Zufallsgröße $Z_{Y,\hspace{0.05cm}M=8}$ mit der angegebenen Näherung</u>. |

| − | |||

| − | |||

| − | |||

| − | |||

|type="{}"} | |type="{}"} | ||

$H(Z_{Y,\hspace{0.05cm}M=8})\ = \ $ { 3 3% } $\ \rm bit$ | $H(Z_{Y,\hspace{0.05cm}M=8})\ = \ $ { 3 3% } $\ \rm bit$ | ||

| Zeile 65: | Zeile 64: | ||

{Welche der folgenden Aussagen sind zutreffend? | {Welche der folgenden Aussagen sind zutreffend? | ||

|type="[]"} | |type="[]"} | ||

| − | + Die Entropie einer wertdiskreten Zufallsgröße $Z$ ist stets $H(Z) \ge 0$. | + | + Die Entropie einer wertdiskreten Zufallsgröße $Z$ ist stets $H(Z) \ge 0$. |

| − | - Die differenzielle Entropie einer wertkontinuierlichen Zufallsgröße $X$ ist stets $h(X) \ge 0$. | + | - Die differenzielle Entropie einer wertkontinuierlichen Zufallsgröße $X$ ist stets $h(X) \ge 0$. |

| Zeile 78: | Zeile 77: | ||

| − | '''(2)''' Mit $y_{\rm min} = -1$ und $y_{\rm max} = +1$ ergibt sich dagegen für die differentielle Entropie der Zufallsgröße $Y$: | + | |

| + | '''(2)''' Mit $y_{\rm min} = -1$ und $y_{\rm max} = +1$ ergibt sich dagegen für die differentielle Entropie der Zufallsgröße $Y$: | ||

:$$h(Y) = {\rm log}_2 \hspace{0.1cm} (y_{\rm max} - y_{\rm min}) = {\rm log}_2 \hspace{0.1cm} (2) \hspace{0.15cm}\underline{= + 1\,{\rm bit}}\hspace{0.05cm}. $$ | :$$h(Y) = {\rm log}_2 \hspace{0.1cm} (y_{\rm max} - y_{\rm min}) = {\rm log}_2 \hspace{0.1cm} (2) \hspace{0.15cm}\underline{= + 1\,{\rm bit}}\hspace{0.05cm}. $$ | ||

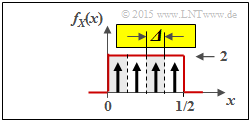

| − | [[Datei:P_ID2879__Inf_A_4_4c.png|right|frame|Quantisierte Zufallsgröße $Z_{X, \ M = 4}$]] | + | |

| − | '''(3)''' Die nebenstehende Grafik verdeutlicht die bestmögliche Quantisierung der Zufallsgröße $X$ mit der Quantisierungsstufenzahl $M = 4$ ⇒ Zufallsgröße $Z_{X, \ M = 4} | + | [[Datei:P_ID2879__Inf_A_4_4c.png|right|frame|Quantisierte Zufallsgröße $Z_{X, \ M = 4}$]] |

| + | '''(3)''' Die nebenstehende Grafik verdeutlicht die bestmögliche Quantisierung der Zufallsgröße $X$ mit der Quantisierungsstufenzahl $M = 4$ ⇒ Zufallsgröße $Z_{X, \ M = 4}$: | ||

*Die Intervallbreite ist hier gleich ${\it \Delta} = 0.5/4 = 1/8$. | *Die Intervallbreite ist hier gleich ${\it \Delta} = 0.5/4 = 1/8$. | ||

| − | *Die möglichen Werte (jeweils in der Intervallmitte) sind $z \in \{0.0625,\ 0.1875,\ 0.3125,\ 0.4375\}$. | + | *Die möglichen Werte (jeweils in der Intervallmitte) sind $z \in \{0.0625,\ 0.1875,\ 0.3125,\ 0.4375\}$. |

| − | + | ||

| + | |||

| + | Die <u>direkte Entropieberechnung</u> ergibt mit der Wahrscheinlichkeitsfunktion $P_Z(Z) = \big [1/4,\ \text{...} , \ 1/4 \big]$: | ||

:$$H(Z_{X, \ M = 4}) = {\rm log}_2 \hspace{0.1cm} (4) \hspace{0.15cm}\underline{= 2\,{\rm bit}} | :$$H(Z_{X, \ M = 4}) = {\rm log}_2 \hspace{0.1cm} (4) \hspace{0.15cm}\underline{= 2\,{\rm bit}} | ||

\hspace{0.05cm}.$$ | \hspace{0.05cm}.$$ | ||

| − | + | Mit der <u>Näherung</u> erhält man unter Berücksichtigung des Ergebnisses von '''(1)''': | |

| − | |||

:$$H(Z_{X,\hspace{0.05cm} M = 4}) \approx -{\rm log}_2 \hspace{0.1cm} ({\it \Delta}) + h(X) = | :$$H(Z_{X,\hspace{0.05cm} M = 4}) \approx -{\rm log}_2 \hspace{0.1cm} ({\it \Delta}) + h(X) = | ||

3\,{\rm bit} +(- 1\,{\rm bit})\hspace{0.15cm}\underline{= 2\,{\rm bit}}\hspace{0.05cm}. $$ | 3\,{\rm bit} +(- 1\,{\rm bit})\hspace{0.15cm}\underline{= 2\,{\rm bit}}\hspace{0.05cm}. $$ | ||

| − | < | + | <u>Hinweis:</u> Nur bei der Gleichverteilung liefert die Näherung genau das gleiche Ergebnis wie die direkte Berechnung, also die tatsächliche Entropie. |

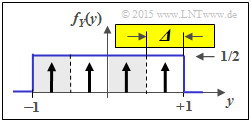

[[Datei:P_ID2880__Inf_A_4_4d.png|right|frame|Quantisierte Zufallsgröße $Z_{Y, \ M = 4}$]] | [[Datei:P_ID2880__Inf_A_4_4d.png|right|frame|Quantisierte Zufallsgröße $Z_{Y, \ M = 4}$]] | ||

<br> | <br> | ||

| − | '''( | + | '''(4)''' Aus der zweiten Grafik erkennt man die Gemeinsamkeiten / Unterschiede zur Teilaufgabe '''(3)''': |

| − | + | * Der Quantisierungsparameter ist nun ${\it \Delta} = 2/4 = 1/2$. | |

| − | + | * Die möglichen Werte sind nun $z \in \{\pm 0.75,\ \pm 0.25\}$. | |

| − | + | * Somit liefert hier die „Näherung” (ebenso wie die direkte Berechnung) das Ergebnis: | |

:$$H(Z_{Y,\hspace{0.05cm} M = 4}) \approx -{\rm log}_2 \hspace{0.1cm} ({\it \Delta}) + h(Y) = | :$$H(Z_{Y,\hspace{0.05cm} M = 4}) \approx -{\rm log}_2 \hspace{0.1cm} ({\it \Delta}) + h(Y) = | ||

1\,{\rm bit} + 1\,{\rm bit}\hspace{0.15cm}\underline{= 2\,{\rm bit}}\hspace{0.05cm}.$$ | 1\,{\rm bit} + 1\,{\rm bit}\hspace{0.15cm}\underline{= 2\,{\rm bit}}\hspace{0.05cm}.$$ | ||

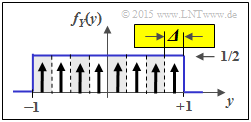

| − | [[Datei:P_ID2881__Inf_A_4_4e.png|right|frame|Quantisierte Zufallsgröße $Z_{Y, \ M = 8}$]] | + | [[Datei:P_ID2881__Inf_A_4_4e.png|right|frame|Quantisierte Zufallsgröße $Z_{Y, \ M = 8}$]] |

| − | '''( | + | '''(5)''' Im Gegensatz zur Teilaufgabe '''(4)''' gilt nun ${\it \Delta} = 1/4$. Daraus folgt für die „Näherung”: |

:$$H(Z_{Y,\hspace{0.05cm} M = 8}) \approx -{\rm log}_2 \hspace{0.1cm} ({\it \Delta}) + h(Y) = | :$$H(Z_{Y,\hspace{0.05cm} M = 8}) \approx -{\rm log}_2 \hspace{0.1cm} ({\it \Delta}) + h(Y) = | ||

2\,{\rm bit} + 1\,{\rm bit}\hspace{0.15cm}\underline{= 3\,{\rm bit}}\hspace{0.05cm}.$$ | 2\,{\rm bit} + 1\,{\rm bit}\hspace{0.15cm}\underline{= 3\,{\rm bit}}\hspace{0.05cm}.$$ | ||

| Zeile 113: | Zeile 115: | ||

| − | '''( | + | '''(6)''' Richtig ist nur die <u>Aussage 1</u>: |

| − | * Die Entropie $H(Z)$ einer diskreten Zufallsgröße $Z = \{z_1, \ \text{...} \ , z_M\}$ | + | * Die Entropie $H(Z)$ einer diskreten Zufallsgröße $Z = \{z_1, \ \text{...} \ , z_M\}$ ist nie negativ. |

| − | *Der Grenzfall $H(Z) = 0$ ergibt sich zum Beispiel für ${\rm Pr}(Z = z_1) = 1$ und ${\rm Pr}(Z = z_\mu) = 0$ für $2 \le \mu \le M$. | + | *Der Grenzfall $H(Z) = 0$ ergibt sich zum Beispiel für ${\rm Pr}(Z = z_1) = 1$ und ${\rm Pr}(Z = z_\mu) = 0$ für $2 \le \mu \le M$. |

| − | * Dagegen kann die differentielle Entropie $h(X)$ einer wertkontinuierlichen Zufallsgröße $X$ wie folgt sein: | + | * Dagegen kann die differentielle Entropie $h(X)$ einer wertkontinuierlichen Zufallsgröße $X$ wie folgt sein: |

| − | ** $h(X) < 0$ (Teilaufgabe 1), | + | ** $h(X) < 0$ $($Teilaufgabe 1$)$, |

| − | ** $h(X) > 0$ (Teilaufgabe 2), oder auch | + | ** $h(X) > 0$ $($Teilaufgabe 2$)$, oder auch |

| − | **$h(X) = 0$ (zum Beispiel für $x_{\rm min} = 0$ und $x_{\rm max} = 1$. | + | **$h(X) = 0$ $($zum Beispiel für $x_{\rm min} = 0$ und $x_{\rm max} = 1)$. |

{{ML-Fuß}} | {{ML-Fuß}} | ||

Aktuelle Version vom 28. September 2021, 15:16 Uhr

Wir betrachten die beiden wertkontinuierlichen Zufallsgrößen $X$ und $Y$ mit den Wahrscheinlichkeitsdichtefunktionen $f_X(x)$ und $f_Y(y)$. Für diese Zufallsgrößen kann man

- die herkömmlichen Entropien $H(X)$ bzw. $H(Y)$ nicht angeben,

- jedoch aber die differentiellen Entropien $h(X)$ und $h(Y)$.

Wir betrachten außerdem zwei wertdiskrete Zufallsgrößen:

- Die Zufallsgröße $Z_{X,\hspace{0.05cm}M}$ ergibt sich durch (geeignete) Quantisierung der Zufallsgröße $X$ mit der Quantisierungsstufenzahl $M$

⇒ Quantisierungsintervallbreite ${\it \Delta} = 0.5/M$. - Die Zufallsgröße $Z_{Y,\hspace{0.05cm}M}$ ergibt sich nach Quantisierung der Zufallsgröße $Y$ mit der Quantisierungsstufenzahl $M$

⇒ Quantisierungsintervallbreite ${\it \Delta} = 2/M$.

Die Wahrscheinlichkeitsdichtefunktionen dieser diskreten Zufallsgrößen setzen sich jeweils aus $M$ Diracfunktionen zusammen, deren Impulsgewichte durch die Intervallflächen der zugehörigen wertkontinuierlichen Zufallsgrößen gegeben sind.

Daraus lassen sich die Entropien $H(Z_{X,\hspace{0.05cm}M})$ und $H(Z_{Y,\hspace{0.05cm}M})$ in herkömmlicher Weise entsprechend dem Kapitel Wahrscheinlichkeitsfunktion und Entropie bestimmen.

Im Abschnitt Entropie wertkontinuierlicher Zufallsgrößen nach Quantisierung wurde auch eine Näherung angegeben. Beispielsweise gilt:

- $$H(Z_{X, \hspace{0.05cm}M}) \approx -{\rm log}_2 \hspace{0.1cm} ({\it \Delta}) + h(X)\hspace{0.05cm}. $$

- Im Laufe der Aufgabe wird sich zeigen, dass bei rechteckförmiger WDF ⇒ Gleichverteilung diese „Näherung” das gleiche Ergebnis liefert wie die direkte Berechnung.

- Aber im allgemeinen Fall – so im $\text{Beispiel 2}$ mit dreieckförmiger WDF – stellt obige Gleichung tatsächlich nur eine Näherung dar, die erst im Grenzfall ${\it \Delta} \to 0$ mit der tatsächlichen Entropie $H(Z_{X,\hspace{0.05cm}M})$ übereinstimmt.

Hinweise:

- Die Aufgabe gehört zum Kapitel Differentielle Entropie.

- Nützliche Hinweise zur Lösung dieser Aufgabe finden Sie insbesondere auf der Seite Entropie wertkontinuierlicher Zufallsgrößen nach Quantisierung .

Fragebogen

Musterlösung

- $$h(X) = {\rm log}_2 \hspace{0.1cm} (x_{\rm max} - x_{\rm min}) = {\rm log}_2 \hspace{0.1cm} (1/2) \hspace{0.15cm}\underline{= - 1\,{\rm bit}}\hspace{0.05cm}.$$

(2) Mit $y_{\rm min} = -1$ und $y_{\rm max} = +1$ ergibt sich dagegen für die differentielle Entropie der Zufallsgröße $Y$:

- $$h(Y) = {\rm log}_2 \hspace{0.1cm} (y_{\rm max} - y_{\rm min}) = {\rm log}_2 \hspace{0.1cm} (2) \hspace{0.15cm}\underline{= + 1\,{\rm bit}}\hspace{0.05cm}. $$

(3) Die nebenstehende Grafik verdeutlicht die bestmögliche Quantisierung der Zufallsgröße $X$ mit der Quantisierungsstufenzahl $M = 4$ ⇒ Zufallsgröße $Z_{X, \ M = 4}$:

- Die Intervallbreite ist hier gleich ${\it \Delta} = 0.5/4 = 1/8$.

- Die möglichen Werte (jeweils in der Intervallmitte) sind $z \in \{0.0625,\ 0.1875,\ 0.3125,\ 0.4375\}$.

Die direkte Entropieberechnung ergibt mit der Wahrscheinlichkeitsfunktion $P_Z(Z) = \big [1/4,\ \text{...} , \ 1/4 \big]$:

- $$H(Z_{X, \ M = 4}) = {\rm log}_2 \hspace{0.1cm} (4) \hspace{0.15cm}\underline{= 2\,{\rm bit}} \hspace{0.05cm}.$$

Mit der Näherung erhält man unter Berücksichtigung des Ergebnisses von (1):

- $$H(Z_{X,\hspace{0.05cm} M = 4}) \approx -{\rm log}_2 \hspace{0.1cm} ({\it \Delta}) + h(X) = 3\,{\rm bit} +(- 1\,{\rm bit})\hspace{0.15cm}\underline{= 2\,{\rm bit}}\hspace{0.05cm}. $$

Hinweis: Nur bei der Gleichverteilung liefert die Näherung genau das gleiche Ergebnis wie die direkte Berechnung, also die tatsächliche Entropie.

(4) Aus der zweiten Grafik erkennt man die Gemeinsamkeiten / Unterschiede zur Teilaufgabe (3):

- Der Quantisierungsparameter ist nun ${\it \Delta} = 2/4 = 1/2$.

- Die möglichen Werte sind nun $z \in \{\pm 0.75,\ \pm 0.25\}$.

- Somit liefert hier die „Näherung” (ebenso wie die direkte Berechnung) das Ergebnis:

- $$H(Z_{Y,\hspace{0.05cm} M = 4}) \approx -{\rm log}_2 \hspace{0.1cm} ({\it \Delta}) + h(Y) = 1\,{\rm bit} + 1\,{\rm bit}\hspace{0.15cm}\underline{= 2\,{\rm bit}}\hspace{0.05cm}.$$

(5) Im Gegensatz zur Teilaufgabe (4) gilt nun ${\it \Delta} = 1/4$. Daraus folgt für die „Näherung”:

- $$H(Z_{Y,\hspace{0.05cm} M = 8}) \approx -{\rm log}_2 \hspace{0.1cm} ({\it \Delta}) + h(Y) = 2\,{\rm bit} + 1\,{\rm bit}\hspace{0.15cm}\underline{= 3\,{\rm bit}}\hspace{0.05cm}.$$

Man erhält wieder das gleiche Ergebnis wie bei der direkten Berechnung.

(6) Richtig ist nur die Aussage 1:

- Die Entropie $H(Z)$ einer diskreten Zufallsgröße $Z = \{z_1, \ \text{...} \ , z_M\}$ ist nie negativ.

- Der Grenzfall $H(Z) = 0$ ergibt sich zum Beispiel für ${\rm Pr}(Z = z_1) = 1$ und ${\rm Pr}(Z = z_\mu) = 0$ für $2 \le \mu \le M$.

- Dagegen kann die differentielle Entropie $h(X)$ einer wertkontinuierlichen Zufallsgröße $X$ wie folgt sein:

- $h(X) < 0$ $($Teilaufgabe 1$)$,

- $h(X) > 0$ $($Teilaufgabe 2$)$, oder auch

- $h(X) = 0$ $($zum Beispiel für $x_{\rm min} = 0$ und $x_{\rm max} = 1)$.