Aufgaben:Aufgabe 3.9: Bedingte Transinformation: Unterschied zwischen den Versionen

Safwen (Diskussion | Beiträge) (Die Seite wurde neu angelegt: „ {{quiz-Header|Buchseite=Informationstheorie/Verschiedene Entropien zweidimensionaler Zufallsgrößen }} [[Datei:|right|]] ===Fragebogen=== <quiz display=s…“) |

Safwen (Diskussion | Beiträge) |

||

| Zeile 3: | Zeile 3: | ||

}} | }} | ||

| − | [[Datei:|right|]] | + | [[Datei:P_ID2813__Inf_A_3_8.png|right|]] |

| + | Wir gehen von den statistisch unabhängigen Zufallsgrößen $X$, $Y$ und $Z$mit den folgenden Eigenschaften aus : | ||

| + | |||

| + | $X \epsilon \{1,2\}$ , $Y \epsilon \{1,2\}$ , $Z \epsilon \{1,2\}$ | ||

| + | |||

| + | $P_X(X) = P_Y(Y) = [ 1/2 , 1/2]$ , $P_Z(Z) = [ p, 1-p]$. | ||

| + | |||

| + | Aus $X$, $Y$ und $Z$ bilden wir die neue Zufallsgröße | ||

| + | |||

| + | $W = (X+Y). Z$. | ||

| + | |||

| + | Damit ist offensichtlich, dass es zwischen den beiden Zufallsgrößen $X$und W statistische Abhängigkeiten gibt, die sich auch in der Transinformation $I(X; W) ≠ 0$ zeigen werden. | ||

| + | |||

| + | Außerdem wird auch $I(Y; W) ≠ 04 sowie $I(Z; W) ≠ 04 gelten, worauf in dieser Aufgabe jedoch nicht näher eingegangen wird. | ||

| + | |||

| + | In dieser Aufgabe werden drei verschiedene Transinformationsdefinitionen verwendet: | ||

| + | :*die ''herkömmliche'' Transinformation zwischen $X$ und $W$: | ||

| + | |||

| + | $I(X;W) = H(X) - H(X \mid W)$ , | ||

| + | :* die ''bedingte'' Transinformation zwischen $X$ und $W$ bei ''gegebenem Festwer''t $Z = z$: | ||

| + | |||

| + | $I(X;W \mid Z=z) = H(X \mid Z=z) - H(X \mid W , Z=z)$, | ||

| + | :* die ''bedingte'' Transinformation zwischen $X$ und $W$ bei ''gegebener Zufallsgröße'' $Z$: | ||

| + | |||

| + | $I(X;W \mid Z) = H(X \mid Z) - H(X \mid W Z)$. | ||

| + | |||

| + | |||

| + | Der Zusammenhang zwischen den beiden letzten Definitionen lautet: | ||

| + | |||

| + | $I(X;W \mid Z) = \sum\limits_{z \epsilon supp(P_Z)} P_Z(Z) . I(X; W \mid Z=z)$. | ||

| + | |||

| + | '''Hinwies:''' Die Aufgabe gehört zum Themengebiet von [http://www.lntwww.de/Informationstheorie/Verschiedene_Entropien_zweidimensionaler_Zufallsgr%C3%B6%C3%9Fen Kapitel 3.2]. | ||

| + | |||

| + | |||

| + | |||

| + | |||

Version vom 26. November 2016, 21:23 Uhr

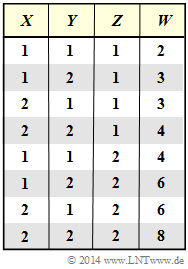

Wir gehen von den statistisch unabhängigen Zufallsgrößen $X$, $Y$ und $Z$mit den folgenden Eigenschaften aus :

$X \epsilon \{1,2\}$ , $Y \epsilon \{1,2\}$ , $Z \epsilon \{1,2\}$

$P_X(X) = P_Y(Y) = [ 1/2 , 1/2]$ , $P_Z(Z) = [ p, 1-p]$.

Aus $X$, $Y$ und $Z$ bilden wir die neue Zufallsgröße

$W = (X+Y). Z$.

Damit ist offensichtlich, dass es zwischen den beiden Zufallsgrößen $X$und W statistische Abhängigkeiten gibt, die sich auch in der Transinformation $I(X; W) ≠ 0$ zeigen werden.

Außerdem wird auch $I(Y; W) ≠ 04 sowie $I(Z; W) ≠ 04 gelten, worauf in dieser Aufgabe jedoch nicht näher eingegangen wird.

In dieser Aufgabe werden drei verschiedene Transinformationsdefinitionen verwendet:

- die herkömmliche Transinformation zwischen $X$ und $W$:

$I(X;W) = H(X) - H(X \mid W)$ ,

- die bedingte Transinformation zwischen $X$ und $W$ bei gegebenem Festwert $Z = z$:

$I(X;W \mid Z=z) = H(X \mid Z=z) - H(X \mid W , Z=z)$,

- die bedingte Transinformation zwischen $X$ und $W$ bei gegebener Zufallsgröße $Z$:

$I(X;W \mid Z) = H(X \mid Z) - H(X \mid W Z)$.

Der Zusammenhang zwischen den beiden letzten Definitionen lautet:

$I(X;W \mid Z) = \sum\limits_{z \epsilon supp(P_Z)} P_Z(Z) . I(X; W \mid Z=z)$.

Hinwies: Die Aufgabe gehört zum Themengebiet von Kapitel 3.2.

Fragebogen

Musterlösung