Aufgaben:Aufgabe 3.8Z: Tupel aus ternären Zufallsgrößen: Unterschied zwischen den Versionen

| Zeile 32: | Zeile 32: | ||

$ H(XY)\ = \ $ { 3.17 3% } $\ \rm bit$ | $ H(XY)\ = \ $ { 3.17 3% } $\ \rm bit$ | ||

| − | {Welche | + | {Welche Transinformation besteht zwischen den Zufallsgrößen $X$ und $Y$? |

|type="{}"} | |type="{}"} | ||

$I(X; Y)\ = \ $ { 0. } $\ \rm bit$ | $I(X; Y)\ = \ $ { 0. } $\ \rm bit$ | ||

| − | {Welche | + | {Welche Transinformation besteht zwischen den Zufallsgrößen $X$ und $Z$? |

|type="{}"} | |type="{}"} | ||

$I(X; Z)\ = \ $ { 1.585 3% } $\ \rm bit$ | $I(X; Z)\ = \ $ { 1.585 3% } $\ \rm bit$ | ||

| Zeile 51: | Zeile 51: | ||

===Musterlösung=== | ===Musterlösung=== | ||

{{ML-Kopf}} | {{ML-Kopf}} | ||

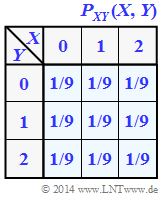

| − | '''(1)''' Bei den | + | '''(1)''' Bei den Zufallsgrößen $X =\{0, 1, 2\}$ ⇒ $|X| = 3$ und $Y = \{0, 1, 2\}$ ⇒ $|Y| = 3$ liegt jeweils eine Gleichverteilung vor. Damit erhält man für die Entropien: |

:$$H(X) = {\rm log}_2 \hspace{0.1cm} (3) | :$$H(X) = {\rm log}_2 \hspace{0.1cm} (3) | ||

| Zeile 58: | Zeile 58: | ||

\hspace{0.15cm}\underline{= 1.585\,{\rm (bit)}}\hspace{0.05cm}.$$ | \hspace{0.15cm}\underline{= 1.585\,{\rm (bit)}}\hspace{0.05cm}.$$ | ||

| − | Die 2D–Zufallsgröße $XY = \{00, 01, 02, 10, 11, 12, 20, 21, 22\}$ ⇒ $|XY| = |Z| = 9$ weist ebenfalls gleiche Wahrscheinlichkeiten auf: $p_{ 00 } = p_{ 01 } =\text{...} = p_{ 22 } = 1/9$ | + | Die 2D–Zufallsgröße $XY = \{00, 01, 02, 10, 11, 12, 20, 21, 22\}$ ⇒ $|XY| = |Z| = 9$ weist ebenfalls gleiche Wahrscheinlichkeiten auf: |

| + | :$$p_{ 00 } = p_{ 01 } =\text{...} = p_{ 22 } = 1/9.$$ | ||

| + | Daraus folgt: | ||

:$$H(XY) = {\rm log}_2 \hspace{0.1cm} (9) \hspace{0.15cm}\underline{= 3.170\,{\rm (bit)}} \hspace{0.05cm}.$$ | :$$H(XY) = {\rm log}_2 \hspace{0.1cm} (9) \hspace{0.15cm}\underline{= 3.170\,{\rm (bit)}} \hspace{0.05cm}.$$ | ||

| − | |||

| + | '''(2)''' Die Zufallsgrößen$X$und $Y$ sind wegen $P_{ XY }(⋅) = P_X(⋅) · P_Y(⋅)$ statistisch unabhängig. | ||

| + | *Daraus folgt $I(X, Y)\hspace{0.15cm}\underline{ = 0}$. | ||

| + | *Zum gleichen Ergebnis kommt man über die Gleichung $I(X; Y) = H(X) + H(Y) – H(XY)$. | ||

| − | |||

| − | [[Datei:P_ID2774__Inf_Z_3_7c.png|right| | + | '''(3)''' Interpretiert man $I(X; Z)$ als die verbleibende Unsicherheit hinsichtlich des Tupels $Z$, wenn die erste Komponente $X$ bekannt ist, so gilt offensichtlich |

| + | :$$ I(X; Z) = H(Y)\hspace{0.15cm}\underline{ = 1.585 \ \rm bit}.$$ | ||

| + | |||

| + | [[Datei:P_ID2774__Inf_Z_3_7c.png|right|frame|Wahrscheinlichkeitsfunktion der 2D-Zufallsgröße $XZ$]] | ||

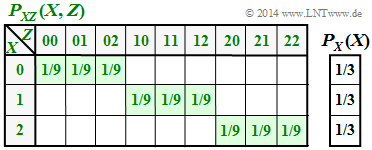

Rein formal lässt sich diese Aufgabe auch wie folgt lösen: | Rein formal lässt sich diese Aufgabe auch wie folgt lösen: | ||

* Die Entropie $H(Z)$ ist gleich der Verbundentropie $H(XY) = 3.170 \ \rm bit$. | * Die Entropie $H(Z)$ ist gleich der Verbundentropie $H(XY) = 3.170 \ \rm bit$. | ||

| − | * Die Verbundwahrscheinlichkeit $P_{ XZ }(X, Z)$ beinhaltet neun Elemente der Wahrscheinlichkeit $1/9$, alle anderen sind mit Nullen belegt ⇒ $H(XZ) = | + | * Die Verbundwahrscheinlichkeit $P_{ XZ }(X, Z)$ beinhaltet neun Elemente der Wahrscheinlichkeit $1/9$, alle anderen sind mit Nullen belegt ⇒ $H(XZ) = \log_2 (9) = 3.170 \ \rm bit $. |

| − | * Damit gilt für die Transinformation (gemeinsame Information der | + | * Damit gilt für die Transinformation (gemeinsame Information der Zufallsgrößen $X$ und $Z$): |

:$$I(X;Z) = H(X) + H(Z) - H(XZ) = 1.585 + 3.170- 3.170\hspace{0.15cm} \underline {= 1.585\,{\rm (bit)}} \hspace{0.05cm}.$$ | :$$I(X;Z) = H(X) + H(Z) - H(XZ) = 1.585 + 3.170- 3.170\hspace{0.15cm} \underline {= 1.585\,{\rm (bit)}} \hspace{0.05cm}.$$ | ||

| − | [[Datei:P_ID2773__Inf_Z_3_7d.png|right|Entropien der | + | |

| + | [[Datei:P_ID2773__Inf_Z_3_7d.png|right|frame|Entropien der 2D-Zufallsgröße $XZ$]] | ||

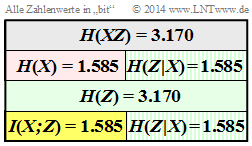

'''(4)''' Entsprechend der zweiten Grafik gilt: | '''(4)''' Entsprechend der zweiten Grafik gilt: | ||

| Zeile 79: | Zeile 86: | ||

:$$H(X \hspace{-0.1cm}\mid \hspace{-0.1cm} Z) = H(XZ) - H(Z) = 3.170-3.170\hspace{0.15cm} \underline {=0\,{\rm (bit)}} \hspace{0.05cm}.$$ | :$$H(X \hspace{-0.1cm}\mid \hspace{-0.1cm} Z) = H(XZ) - H(Z) = 3.170-3.170\hspace{0.15cm} \underline {=0\,{\rm (bit)}} \hspace{0.05cm}.$$ | ||

| − | * $H(Z|X)$ gibt die Restunsicherheit hinsichtlich des Tupels $Z$ an, wenn man die erste Komponente $X$ kennt. Die Unsicherheit hinsichtlich des Tupels $Z$ ist $H(Z) = 2 · \log_2 (3) bit$, bei Kenntnis der Komponente $X$ halbiert sich die Unsicherheit auf $H(Z|X) = \ | + | * $H(Z|X)$ gibt die Restunsicherheit hinsichtlich des Tupels $Z$ an, wenn man die erste Komponente $X$ kennt. |

| − | * $H(X|Z)$gibt die verbleibende Unsicherheit hinsichtlich der Komponente $X$ an, wenn man das Tupel $Z = (X, Y)$ kennt. Diese Unsicherheit ist natürlich Null: Kennt man $Z$, so kennt man auch $X$. | + | *Die Unsicherheit hinsichtlich des Tupels $Z$ ist $H(Z) = 2 · \log_2 (3) \ \rm bit$, bei Kenntnis der Komponente $X$ halbiert sich die Unsicherheit auf $H(Z|X) = \log_2 (3)\ \rm bit$. |

| + | * $H(X|Z)$ gibt die verbleibende Unsicherheit hinsichtlich der Komponente $X$ an, wenn man das Tupel $Z = (X, Y)$ kennt. Diese Unsicherheit ist natürlich Null: Kennt man $Z$, so kennt man auch $X$. | ||

{{ML-Fuß}} | {{ML-Fuß}} | ||

Version vom 9. Oktober 2018, 18:11 Uhr

Wir betrachten das Tupel $Z = (X, Y)$, wobei die Einzelkomponenten $X$ und $Y$ jeweils ternäre Zufallsgrößen darstellen ⇒ Symbolumfang $|X| = |Y| = 3$. Die gemeinsame Wahrscheinlichkeitsfunktion $P_{ XY }(X, Y)$ ist rechts skizziert.

In dieser Aufgabe sind zu berechnen:

- die Verbundentropie $H(XY)$ und die Transinformation $I(X; Y)$,

- die Verbundentropie $H(XZ)$ und die Transinformation $I(X; Z)$,

- die beiden bedingten Entropien $H(Z|X)$ und $H(X|Z)$.

Hinweise:

- Die Aufgabe gehört zum Kapitel Verschiedene Entropien zweidimensionaler Zufallsgrößen.

- Insbesondere wird Bezug genommen auf die Seiten

Bedingte Wahrscheinlichkeit und bedingte Entropie sowie

Transinformation zwischen zwei Zufallsgrößen.

Fragebogen

Musterlösung

- $$H(X) = {\rm log}_2 \hspace{0.1cm} (3) \hspace{0.15cm}\underline{= 1.585\,{\rm (bit)}} \hspace{0.05cm},$$

- $$H(Y) = {\rm log}_2 \hspace{0.1cm} (3) \hspace{0.15cm}\underline{= 1.585\,{\rm (bit)}}\hspace{0.05cm}.$$

Die 2D–Zufallsgröße $XY = \{00, 01, 02, 10, 11, 12, 20, 21, 22\}$ ⇒ $|XY| = |Z| = 9$ weist ebenfalls gleiche Wahrscheinlichkeiten auf:

- $$p_{ 00 } = p_{ 01 } =\text{...} = p_{ 22 } = 1/9.$$

Daraus folgt:

- $$H(XY) = {\rm log}_2 \hspace{0.1cm} (9) \hspace{0.15cm}\underline{= 3.170\,{\rm (bit)}} \hspace{0.05cm}.$$

(2) Die Zufallsgrößen$X$und $Y$ sind wegen $P_{ XY }(⋅) = P_X(⋅) · P_Y(⋅)$ statistisch unabhängig.

- Daraus folgt $I(X, Y)\hspace{0.15cm}\underline{ = 0}$.

- Zum gleichen Ergebnis kommt man über die Gleichung $I(X; Y) = H(X) + H(Y) – H(XY)$.

(3) Interpretiert man $I(X; Z)$ als die verbleibende Unsicherheit hinsichtlich des Tupels $Z$, wenn die erste Komponente $X$ bekannt ist, so gilt offensichtlich

- $$ I(X; Z) = H(Y)\hspace{0.15cm}\underline{ = 1.585 \ \rm bit}.$$

Rein formal lässt sich diese Aufgabe auch wie folgt lösen:

- Die Entropie $H(Z)$ ist gleich der Verbundentropie $H(XY) = 3.170 \ \rm bit$.

- Die Verbundwahrscheinlichkeit $P_{ XZ }(X, Z)$ beinhaltet neun Elemente der Wahrscheinlichkeit $1/9$, alle anderen sind mit Nullen belegt ⇒ $H(XZ) = \log_2 (9) = 3.170 \ \rm bit $.

- Damit gilt für die Transinformation (gemeinsame Information der Zufallsgrößen $X$ und $Z$):

- $$I(X;Z) = H(X) + H(Z) - H(XZ) = 1.585 + 3.170- 3.170\hspace{0.15cm} \underline {= 1.585\,{\rm (bit)}} \hspace{0.05cm}.$$

(4) Entsprechend der zweiten Grafik gilt:

- $$H(Z \hspace{-0.1cm}\mid \hspace{-0.1cm} X) = H(XZ) - H(X) = 3.170-1.585\hspace{0.15cm} \underline {=1.585\,{\rm (bit)}} \hspace{0.05cm},$$

- $$H(X \hspace{-0.1cm}\mid \hspace{-0.1cm} Z) = H(XZ) - H(Z) = 3.170-3.170\hspace{0.15cm} \underline {=0\,{\rm (bit)}} \hspace{0.05cm}.$$

- $H(Z|X)$ gibt die Restunsicherheit hinsichtlich des Tupels $Z$ an, wenn man die erste Komponente $X$ kennt.

- Die Unsicherheit hinsichtlich des Tupels $Z$ ist $H(Z) = 2 · \log_2 (3) \ \rm bit$, bei Kenntnis der Komponente $X$ halbiert sich die Unsicherheit auf $H(Z|X) = \log_2 (3)\ \rm bit$.

- $H(X|Z)$ gibt die verbleibende Unsicherheit hinsichtlich der Komponente $X$ an, wenn man das Tupel $Z = (X, Y)$ kennt. Diese Unsicherheit ist natürlich Null: Kennt man $Z$, so kennt man auch $X$.