Aufgaben:Aufgabe 3.2: Erwartungswertberechnungen: Unterschied zwischen den Versionen

K (Guenter verschob die Seite 3.02 Erwartungswertberechnungen nach 3.2 Erwartungswertberechnungen) |

|||

| Zeile 3: | Zeile 3: | ||

}} | }} | ||

| − | [[Datei:P_ID2751__Inf_A_3_2.png|right|]] | + | [[Datei:P_ID2751__Inf_A_3_2.png|right|2D–Wahrscheinlichkeitsfunktion]] |

Wir betrachten folgende Wahrscheinlichkeitsfunktionen: | Wir betrachten folgende Wahrscheinlichkeitsfunktionen: | ||

| − | : | + | : $P_X(X) = [1/2, 1/8, 0, 3/8]$, |

| − | + | : $P_Y(Y) = [1/2, 1/4, 1/4, 0]$, | |

| − | : | + | : $P_U(U) = [1/2, 1/2]$, |

| − | + | : $P_V(V) = [3/4, 1/4]$. | |

| − | : | ||

| − | |||

| − | : | ||

Für die dazugehörigen Zufallsgrößen gelte: | Für die dazugehörigen Zufallsgrößen gelte: | ||

| − | : | + | : $X= \{0, 1, 2, 3\}$, $Y= \{0, 1, 2, 3\}$, |

| − | + | : $U = \{0, 1\}$, $U = \{0, 1\}$. | |

| − | : | ||

| − | Oft muss man | + | Oft muss man für solche diskreten Zufallsgrößen verschiedene Erwartungswerte der Form |

:$${\rm E} \left [ F(X)\right ] = \sum_{x \hspace{0.05cm}\in \hspace{0.05cm} {\rm supp} (P_X)} \hspace{-0.1cm} | :$${\rm E} \left [ F(X)\right ] = \sum_{x \hspace{0.05cm}\in \hspace{0.05cm} {\rm supp} (P_X)} \hspace{-0.1cm} | ||

P_{X}(x) \cdot F(x) $$ | P_{X}(x) \cdot F(x) $$ | ||

| Zeile 26: | Zeile 22: | ||

berechnen. Hierbei bedeuten: | berechnen. Hierbei bedeuten: | ||

| − | + | * $P_X(X)$ bezeichnet die <i>Wahrscheinlichkeitsfunktion</i> der diskreten Zufallsgröße $X$. | |

| − | + | * Der <i>Support</i> von $P_X$ umfasst alle diejenigen Realisierungen $x$ der Zufallsgröße $X$ mit nicht verschwindender Wahrscheinlichkeit. <br>Formal kann hierfür geschrieben werden: | |

| − | |||

:$${\rm supp} (P_X) = \{ x: \hspace{0.25cm}x \in X \hspace{0.15cm}\underline{\rm und} \hspace{0.15cm} P_X(x) \ne 0 \} \hspace{0.05cm}.$$ | :$${\rm supp} (P_X) = \{ x: \hspace{0.25cm}x \in X \hspace{0.15cm}\underline{\rm und} \hspace{0.15cm} P_X(x) \ne 0 \} \hspace{0.05cm}.$$ | ||

| + | * $F(X)$ ist eine (beliebige) reellwertige Funktion, die im gesamten Definitionsgebiet der Zufallsgröße angebbar ist. | ||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | In der Aufgabe sollen die Erwartungswerte für verschiedene Funktionen $F(X)$ berechnet werden, unter anderem für | |

| − | + | : $F(X)= 1/P_X(X)$, | |

| + | : $F(X)= P_X(X)$, | ||

| + | : $F(X)= - \log_2 \ P_X(X)$. | ||

| − | |||

| − | :* Zu den binären Wahrscheinlichkeitsfunktionen | + | ''Hinweise:'' |

| + | *Die Aufgabe gehört zum Kapitel [[Informationstheorie/Einige_Vorbemerkungen_zu_zweidimensionalen_Zufallsgrößen|Einige Vorbemerkungen zu den 2D-Zufallsgrößen]]. | ||

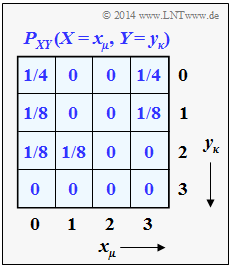

| + | * Die beiden „eindimensionalen” Wahrscheinlichkeitsfunktionen $P_X(X)$ und $P_Y(Y)$ ergeben sich aus der dargestellten 2D–PMF $P_{XY}(X, Y)$, wie in [[Aufgaben:3.2Z_2D–Wahrscheinlichkeitsfunktion|Zusatzaufgabe 3.2Z]] gezeigt werden soll. | ||

| + | * Zu den binären Wahrscheinlichkeitsfunktionen $P_U(U)$ und $P_V(V)$ kommt man entsprechend den Modulo–Operationen $U = X \hspace{0.1cm}\text{mod} \hspace{0.1cm}2$ sowie $V = Y \hspace{0.1cm}\text{mod} \hspace{0.1cm} 2$. | ||

| + | *Sollte die Eingabe des Zahlenwertes „0” erforderlich sein, so geben Sie bitte „0.” ein. | ||

| Zeile 53: | Zeile 47: | ||

{Welche Ergebnisse liefern die folgenden Erwartungswerte? | {Welche Ergebnisse liefern die folgenden Erwartungswerte? | ||

|type="{}"} | |type="{}"} | ||

| − | $E[1/P_X(X)]$ | + | ${\rm E}[1/P_X(X)] \ = \ $ { 3 3% } |

| − | $E[1/P_Y(Y)]$ | + | ${\rm E}[1/P_Y(Y)] \ = \ ${ 3 3% } |

{Geben Sie die folgenden Erwartungswerte an: | {Geben Sie die folgenden Erwartungswerte an: | ||

|type="{}"} | |type="{}"} | ||

| − | $E[P_X(X)]$ | + | ${\rm E}[P_X(X)] \ = \ $ { 0.406 3% } |

| − | $E[P_Y(Y)]$ | + | ${\rm E}[P_Y(Y)] \ = \ $ { 0.375 3% } |

{Berechnen Sie nun die folgenden Erwartungswerte: | {Berechnen Sie nun die folgenden Erwartungswerte: | ||

|type="{}"} | |type="{}"} | ||

| − | $E[P_Y(X)]$ | + | ${\rm E}[P_Y(X)] \ = \ $ { 0.281 3% } |

| − | $E[P_X(Y)]$ | + | ${\rm E}[P_X(Y)] \ = \ $ { 0.281 3% } |

{Welche der folgenden Aussagen sind zutreffend? | {Welche der folgenden Aussagen sind zutreffend? | ||

|type="[]"} | |type="[]"} | ||

| − | + E[ | + | + ${\rm E}[- \log_2 \ P_U(U)]$ ergibt die Entropie der Zufallsgröße $U$. |

| − | + E[ | + | + ${\rm E}[- \log_2 \ P_V(V)]$ ergibt die Entropie der Zufallsgröße $V$. |

| − | - E[ | + | - ${\rm E}[- \log_2 \ P_V(U)]$ ergibt die Entropie der Zufallsgröße $V$. |

Version vom 30. Mai 2017, 11:12 Uhr

Wir betrachten folgende Wahrscheinlichkeitsfunktionen:

- $P_X(X) = [1/2, 1/8, 0, 3/8]$,

- $P_Y(Y) = [1/2, 1/4, 1/4, 0]$,

- $P_U(U) = [1/2, 1/2]$,

- $P_V(V) = [3/4, 1/4]$.

Für die dazugehörigen Zufallsgrößen gelte:

- $X= \{0, 1, 2, 3\}$, $Y= \{0, 1, 2, 3\}$,

- $U = \{0, 1\}$, $U = \{0, 1\}$.

Oft muss man für solche diskreten Zufallsgrößen verschiedene Erwartungswerte der Form

- $${\rm E} \left [ F(X)\right ] = \sum_{x \hspace{0.05cm}\in \hspace{0.05cm} {\rm supp} (P_X)} \hspace{-0.1cm} P_{X}(x) \cdot F(x) $$

berechnen. Hierbei bedeuten:

- $P_X(X)$ bezeichnet die Wahrscheinlichkeitsfunktion der diskreten Zufallsgröße $X$.

- Der Support von $P_X$ umfasst alle diejenigen Realisierungen $x$ der Zufallsgröße $X$ mit nicht verschwindender Wahrscheinlichkeit.

Formal kann hierfür geschrieben werden:

- $${\rm supp} (P_X) = \{ x: \hspace{0.25cm}x \in X \hspace{0.15cm}\underline{\rm und} \hspace{0.15cm} P_X(x) \ne 0 \} \hspace{0.05cm}.$$

- $F(X)$ ist eine (beliebige) reellwertige Funktion, die im gesamten Definitionsgebiet der Zufallsgröße angebbar ist.

In der Aufgabe sollen die Erwartungswerte für verschiedene Funktionen $F(X)$ berechnet werden, unter anderem für

- $F(X)= 1/P_X(X)$,

- $F(X)= P_X(X)$,

- $F(X)= - \log_2 \ P_X(X)$.

Hinweise:

- Die Aufgabe gehört zum Kapitel Einige Vorbemerkungen zu den 2D-Zufallsgrößen.

- Die beiden „eindimensionalen” Wahrscheinlichkeitsfunktionen $P_X(X)$ und $P_Y(Y)$ ergeben sich aus der dargestellten 2D–PMF $P_{XY}(X, Y)$, wie in Zusatzaufgabe 3.2Z gezeigt werden soll.

- Zu den binären Wahrscheinlichkeitsfunktionen $P_U(U)$ und $P_V(V)$ kommt man entsprechend den Modulo–Operationen $U = X \hspace{0.1cm}\text{mod} \hspace{0.1cm}2$ sowie $V = Y \hspace{0.1cm}\text{mod} \hspace{0.1cm} 2$.

- Sollte die Eingabe des Zahlenwertes „0” erforderlich sein, so geben Sie bitte „0.” ein.

Fragebogen

Musterlösung

- $${\rm E} \left [ F(X)\right ] = \sum_{x \hspace{0.05cm}\in \hspace{0.05cm} {\rm supp} (P_X)} \hspace{0.01cm} P_{X}(x) \cdot F(x) \hspace{0.05cm}.$$

Im vorliegenden Beispiel gilt X = {0, 1, 2, 3} und PX(X) = [1/2, 1/8, 0, 3/8]. Wegen PX(X = 2) = 0 ergibt sich somit für die zu berücksichtigende Menge („Support”) in obiger Summation:

- $${\rm supp} (P_X) = \{ 0\hspace{0.05cm}, 1\hspace{0.05cm}, 3 \} \hspace{0.05cm}.$$

Mit F(X) = 1/PX(X) erhält man weiter:

- $${\rm E} \left [ 1/P_X(X)\right ] = \sum_{x \hspace{0.05cm}\in \hspace{0.05cm} \{ 0\hspace{0.05cm}, 1\hspace{0.05cm},\hspace{0.05cm} 3 \}} \hspace{0.01cm} P_{X}(x) \cdot {1}/{P_X(x)} = \sum_{x \hspace{0.05cm}\in \hspace{0.05cm} \{ 0\hspace{0.05cm}, 1\hspace{0.05cm},\hspace{0.05cm} 3 \}} \hspace{-0.3cm} 1 \hspace{0.15cm}\underline{ = 3} \hspace{0.05cm}.$$

Der zweite Erwartungswert liefert mit supp(PY) = {0, 1, 2} das gleiche Ergebnis: E[1/PY(Y)] = 3.

2. In beiden Fällen ist der Index der Wahrscheinlichkeitsfunktion mit der Zufallsvariablen (X bzw. Y) identisch und man erhält

- $${\rm E} \left [ P_X(X)\right ] = \hspace{0.3cm} \sum_{x \hspace{0.05cm}\in \hspace{0.05cm} \{ 0\hspace{0.05cm}, 1\hspace{0.05cm},\hspace{0.05cm} 3 \}} \hspace{0.3cm} P_{X}(x) \cdot {P_X(x)} = (1/2)^2 + (1/8)^2 + (3/8)^2 = 13/32 \hspace{0.15cm}\underline{ \approx 0.406} \hspace{0.05cm},$$

- $${\rm E} \left [ P_Y(Y)\right ] = \hspace{0.3cm} \sum_{y \hspace{0.05cm}\in \hspace{0.05cm} \{ 0\hspace{0.05cm}, 1\hspace{0.05cm},\hspace{0.05cm} 2 \}} \hspace{0.3cm} P_Y(y) \cdot P_Y(y) = (1/2)^2 + (1/4)^2 + (1/4)^2 \hspace{0.15cm}\underline{ = 0.375} \hspace{0.05cm}.$$

3. Hier gelten folgende Gleichungen:

- $${\rm E} \left [ P_Y(X)\right ] = \hspace{0.3cm} \sum_{x \hspace{0.05cm}\in \hspace{0.05cm} \{ 0\hspace{0.05cm}, 1\hspace{0.05cm},\hspace{0.05cm} 3 \}} \hspace{0.3cm} P_{X}(x) \cdot {P_Y(x)} = \frac{1}{2} \cdot \frac{1}{2} + \frac{1}{8} \cdot \frac{1}{4} + \frac{3}{8} \cdot 0 = 9/32 \hspace{0.15cm}\underline{ \approx 0.281} \hspace{0.05cm},$$

Die Erwartungswertbildung bezieht sich hier auf PX(·), also auf die Zufallsgröße X. PY(·) ist dabei die formale Funktion ohne (direkten) Bezug zur Zufallsgröße Y.

Für den zweiten Erwartungswert erhält man den gleichen Zahlenwert (das muss nicht so sein):

- $${\rm E} \left [ P_X(Y)\right ] = \hspace{0.3cm} \sum_{y \hspace{0.05cm}\in \hspace{0.05cm} \{ 0\hspace{0.05cm}, 1\hspace{0.05cm},\hspace{0.05cm} 2 \}} \hspace{0.3cm} P_{Y}(y) \cdot {P_X(y)} = \frac{1}{2} \cdot \frac{1}{2} + \frac{1}{4} \cdot \frac{1}{8} + \frac{1}{4} \cdot 0 = 9/32 \hspace{0.15cm}\underline{ \approx 0.281} \hspace{0.05cm}.$$

4. Wir berechnen zunächst die drei Erwartungswerte:

- $${\rm E} \left [-{\rm log}_2 \hspace{0.1cm} P_U(U)\right ] = \frac{1}{2} \cdot {\rm log}_2 \hspace{0.1cm} \frac{2}{1} + \frac{1}{2} \cdot {\rm log}_2 \hspace{0.1cm} \frac{2}{1} \hspace{0.15cm}\underline{ = 1\,{\rm bit}} \hspace{0.05cm},$$

- $${\rm E} \left [-{\rm log}_2 \hspace{0.1cm} P_V(V)\right ] = \frac{3}{4} \cdot {\rm log}_2 \hspace{0.1cm} \frac{4}{3} + \frac{1}{4} \cdot {\rm log}_2 \hspace{0.1cm} \frac{4}{1} \hspace{0.15cm}\underline{ = 0.811\,{\rm bit}} \hspace{0.05cm},$$

- $${\rm E} \left [-{\rm log}_2 \hspace{0.1cm} P_V(U)\right ] = \frac{1}{2} \cdot {\rm log}_2 \hspace{0.1cm} \frac{4}{3} + \frac{1}{2} \cdot {\rm log}_2 \hspace{0.1cm} \frac{4}{1} \hspace{0.15cm}\underline{ = 1.208\,{\rm bit}} \hspace{0.05cm}.$$

Richtig sind demnach die beiden ersten Aussagen:

- Die Entropie H(U) = 1 bit kann entsprechend der ersten Gleichung berechnet werden. Sie gilt für die binäre Zufallsgröße U mit gleichen Wahrscheinlichkeiten.

- Die Entropie H(V) = 0.811 bit berechnet sich entsprechend der zweiten Gleichung. Aufgrund der Wahrscheinlichkeiten 3/4 und 1/4 ist die Entropie (Unsicherheit) kleiner als für die Zufallsgröße U.

- Der dritte Erwartungswert kann schon allein vom Ergebnis her (1.208 bit) nicht die Entropie einer binären Zufallsgröße angeben, die stets auf 1 bit begrenzt ist.