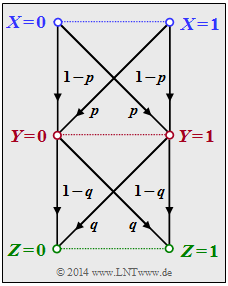

Wir betrachten die folgende Datenverarbeitungskette:

- Binäre Eingangsdaten X werden durch den Prozessor 1 (obere Hälfte in der Grafik) verarbeitet, der durch bedingte Wahrscheinlichkeiten ⇒ PY|X(⋅) beschreibbar ist. Dessen Ausgangsgröße ist Y.

- Ein zweiter Prozessor mit der Zufallsgröße Y am Eingang und der Zufallsgröße Z am Ausgang ist durch PZ|Y(⋅) gegeben (untere Hälfte in der Grafik). Z hängt allein von Y ab (deterministisch oder stochastisch) und ist unabhängig von X:

- PZ|XY(z|x,y)=PZ|Y(z|y).

Für diese Beschreibung wurde folgende Nomenklatur benutzt:

- x∈X={0,1},y∈Y={0,1},z∈Z={0,1}.

Die Verbund–Wahrscheinlichkeitsfunktion (englisch: "Joint Probability Mass Function") lautet:

- PXYZ(x,y,z)=PX(x)⋅PY|X(y|x)⋅PZ|Y(z|y).

Das bedeutet auch:

X→Y→Z bilden eine Markovkette. Für eine solche gilt das "Data Processing Theorem" mit folgender Konsequenz:

- I(X;Z)≤I(X;Y),

- I(X;Z)≤I(Y;Z).

Das Theorem besagt somit:

- Man kann durch Manipulation ("Processing") der Daten Y keine zusätzliche Information über den Eingang X gewinnen.

- Datenverarbeitung (durch den Prozessor 1) dient nur dem Zweck, die in X enthaltene Information besser sichtbar zu machen.

Hinweise:

- Die Aufgabe gehört zum Kapitel Anwendung auf die Digitalsignalübertragung.

- Bezug genommen wird auch auf die Seite Kettenregel der Transinformation im vorherigen Kapitel.

Fragebogen

Musterlösung

- Beide Prozessoren beschreiben streng symmetrische Kanäle ⇒ sowohl gleichmäßig dispersiv als auch gleichmäßig fokussierend.

- Für einen solchen Binärkanal gilt mit Y={0,1} ⇒ |Y|=2:

- I(X;Y)=1+∑y∈YPY|X(y|x)⋅log2PY|X(y|x).

- Hierbei ist es völlig egal, ob man von X=0 oder von X=1 ausgeht.

- Für X=0 erhält man mit PY|X(Y=1|X=0)=p und PY|X(Y=0|X=0)=1–p:

- I(X;Y)=1+p⋅log2(p)+(1−p)⋅log2(1−p)=1−Hbin(p),Hbin(p)=p⋅log21p+(1−p)⋅log211−p.

- Das Ergebnis gilt allerdings nur für PX(X)=(0.5, 0.5) ⇒ maximale Transinformation ⇒ Kanalkapazität.

- Andernfalls ist I(X;Y) kleiner. Beispielsweise gilt für PX(X)=(1, 0): H(X)=0 ⇒ I(X;Y)=0.

- Die binäre Entropiefunktion ist zwar konkav, aber diese Eigenschaft wurde bei der Herleitung nicht benutzt ⇒ Antwort 2 ist falsch.

(2) Für den Prozessor 1 ergibt sich mit p=0.1:

- I(X;Y)=1−Hbin(0.1)=1−0.469=0.531(bit)_.

(3) Entsprechend gilt für den zweiten Prozessor mit q=0.2:

- I(Y;Z)=1−Hbin(0.2)=1−0.722=0.278(bit)_.

(4) Die Wahrscheinlichkeit für Z=0 unter der Bedingung X=0 ergibt sich über zwei Wege zu

- P(Z=0|X=0)=(1−p)⋅(1−q)+p⋅q=1−p−q+2pq!=1−ε.

- Das Gesamtsystem hat dann die genau gleiche BSC–Struktur wie die Prozessoren 1 und 2, aber nun mit der Verfälschungswahrscheinlichkeit ε=p+q−2pq.

- Für p=0.1 und q=0.2 erhält man:

- ε=0.1+0.2−2⋅0.1⋅0.2=0.26⇒I(X;Z)=1−Hbin(0.26)=1−0.827=0.173(bit)_.

(5) Die Antwort ist natürlich JA, da beim "Data Processing Theorem" genau von den hier gegebenen Voraussetzungen ausgegangen wird.

Wir wollen aber zusätzlich einige numerische Ergebnisse auswerten:

- Gilt 0≤p<0.5 und 0≤q<0.5, so erhält man:

- ε=p+q⋅(1−2p)>p⇒I(X;Z)<I(X;Y),

- ε=q+p⋅(1−2q)>q⇒I(X;Z)<I(Y;Z).

- Für p=0.5 gilt unabhängig von q, da I(X;Z) nicht größer sein kann als I(X;Y):

- ε=0.5+q⋅(1−1)=0.5⇒I(X;Y)=0⇒I(X;Z)=0.

- Ebenso erhält man mit q=0.5 unabhängig von p:

- ε=0.5+p⋅(1−1)=0.5⇒I(Y;Z)=0⇒I(X;Z)=0.

- Auch für p<0.5 und q>0.5 wird das Data Processing Theorem nicht verletzt, was hier nur an einem Beispiel gezeigt werden soll:

- Mit p=0.1 und q=0.8 erhält man das gleiche Ergebnis wie in Teilaufgabe (4):

- ε=0.1+0.8−2⋅0.1⋅0.8=0.74⇒I(X;Z)=1−Hbin(0.74)=1−Hbin(0.26)=0.173(bit).